كما هو الحال ، تمتلك روبوتات الدردشة AI ترخيصًا وإذنًا مجانيًا مُصطنعًا لكشط محتوى مواقع الويب واستخدام المعلومات المُتاحة دون أي إذن. هل تشعر بالقلق من أنَّ الوصول إلى مُحتواك يتم إفساده بواسطة هذه الأدوات؟

الخبر السار هو أنه يُمكنك منع أدوات الذكاء الاصطناعي من الوصول إلى موقعك على الويب ، ولكن هناك بعض المحاذير. سنُوضح لك هنا كيفية حظر الروبوتات باستخدام ملف robots.txt لموقع الويب الخاص بك ، بالإضافة إلى إيجابيات وسلبيات القيام بذلك. تحقق من كيفية إنشاء ملف Robots.txt المثالي لـ SEO: ما هو وكيفية استخدامه بالتفصيل.

كيف تصل روبوتات الدردشة بالذكاء الاصطناعي إلى محتوى الويب؟

يتم تدريب روبوتات الدردشة بالذكاء الاصطناعي باستخدام مجموعات بيانات مُتعددة وضخمة ، بعضها مفتوح المصدر ومُتاح للجمهور. على سبيل المثال ، تم تدريب GPT3 باستخدام خمس مجموعات بيانات ، وفقًا لورقة بحثية نشرتها OpenAI:

- الزحف المُشترك (60% من بيانات التدريب).

- WebText2 (%22 من بيانات التدريب).

- Books1 (%8 من بيانات التدريب).

- Books2 (%8 من بيانات التدريب).

- ويكيبيديا (2% من بيانات التدريب).

يتضمن الزحف المُشترك بيتابايت (آلاف تيرابايت) من البيانات من مواقع الويب التي تم جمعها منذ عام 2008 ، على نحو مشابه لكيفية زحف خوارزمية بحث Google إلى محتوى الويب. WebText2 عبارة عن مجموعة بيانات تم إنشاؤها بواسطة OpenAI ، وتحتوي على ما يقرب من 45 مليون صفحة ويب مُرتبطة بمنشورات Reddit مع ثلاثة أصوات مؤيدة على الأقل.

لذلك ، في حالة ChatGPT ، لا يقوم نموذج الذكاء الاصطناعي بالوصول إلى صفحاتك على الويب والزحف إليها مباشرة — ليس بعد ، على أي حال. على الرغم من أنَّ إعلان OpenAI عن متصفح ويب يستضيف ChatGPT أثار مخاوف من أنَّ هذا قد يكون على وشك التغيير.

في غضون ذلك ، يجب على مالكي مواقع الويب مُراقبة روبوتات الدردشة الأخرى التي تعمل بالذكاء الاصطناعي ، حيث يصل المزيد منها إلى السوق. Bard هو الاسم الكبير الآخر في هذا المجال ، ولا يُعرف سوى القليل جدًا عن مجموعات البيانات المُستخدمة لتدريبه. من الواضح أننا نعلم أنَّ روبوتات بحث Google تزحف باستمرار إلى صفحات الويب ، ولكن هذا لا يعني بالضرورة أنَّ Bard لديه حق الوصول إلى نفس البيانات. تحقق من مُقارنة بين ChatGPT و Google Bard: أي نموذج هو الأفضل في البرمجة؟

لماذا يشعر بعض مالكي مواقع الويب بالقلق؟

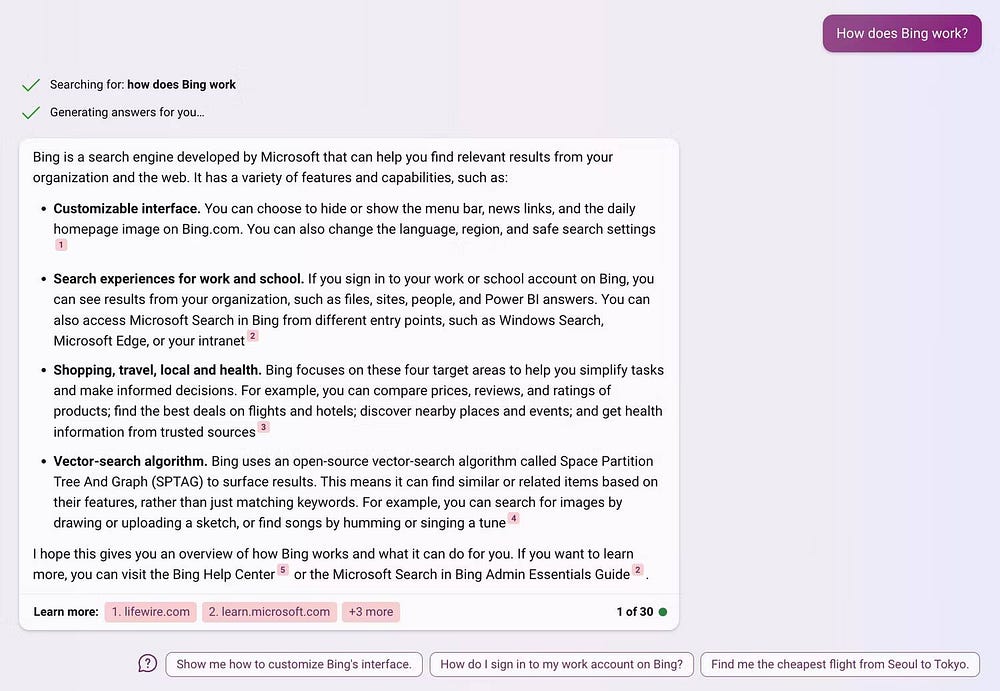

أكبر مصدر قلق لأصحاب مواقع الويب هو أنَّ نماذج الذكاء الاصطناعي مثل ChatGPT و Bard و Bing Chat تُقلل من قيمة محتواها. تستخدم روبوتات الدردشة المحتوى الحالي لإنشاء استجاباتها ، ولكنها تُقلل أيضًا من حاجة المستخدمين للوصول إلى المصدر الأصلي. بدلاً من زيارة المستخدمين لمواقع الويب للوصول إلى المعلومات ، يُمكنهم ببساطة الوصول إلى Google أو Bing لإنشاء مُلخص للمعلومات التي يحتاجون إليها.

عندما يتعلق الأمر بروبوتات الدردشة المدعومة بالذكاء الاصطناعي في البحث ، فإنَّ الشاغل الأكبر لأصحاب مواقع الويب هو فقدان حركة الزيارات. في حالة Bard ، نادرًا ما يتضمن نموذج الذكاء الاصطناعي اقتباسات للمصدر في توليد ردوده ، لإخبار المستخدمين بالصفحات التي يحصل على معلوماته منها.

لذا ، بصرف النظر عن استبدال زيارات موقع الويب باستجابات الذكاء الاصطناعي ، فإنَّ Bard يُزيل تقريبًا أي فرصة لتلقي موقع الويب المصدر لحركة الزيارات — حتى إذا كان المستخدم يُريد المزيد من المعلومات. من ناحية أخرى ، يربط Bing ِChat بشكل أكثر شيوعًا بمصادر المعلومات.

بعبارة أخرى ، تستخدم الأدوات الحالية من نماذج الذكاء الاصطناعي التوليدي عمل مُنشئي المحتوى لاستبدال الحاجة إليهم بشكل منهجي. في النهاية ، عليك أن تسأل عن الحافز الذي يتركه هذا لأصحاب مواقع الويب لمواصلة نشر المحتوى المُحدث. وبالتبعية ، ماذا يحدث لروبوتات الذكاء الاصطناعي عندما تتوقف مواقع الويب عن نشر المحتوى الذي تعتمد عليه من أجل توليد استجابات موثوقة؟ تحقق من طرق مسؤولة لاستخدام الذكاء الاصطناعي ككاتب أو مُحرِّر محتوى.

كيفية منع روبوتات الدردشة بالذكاء الاصطناعي من الوصول إلى موقعك على الويب

إذا كنت لا تُريد أن تستخدم روبوتات الذكاء الاصطناعي محتوى الويب الخاص بك ، فيُمكنك منعها من الوصول إلى موقعك على الويب باستخدام ملف robots.txt. لسوء الحظ ، يجب عليك حظر كل روبوت فردي وتحديده بالاسم.

على سبيل المثال ، يسمى روبوت تتبع الزحف المُشترك CCBot ويُمكنك حظره عن طريق إضافة الشفرة التالية إلى ملف robots.txt لديك:

User-agent: CCBot Disallow: /

سيؤدي هذا إلى منع روبوت الزحف المُشترك من الزحف إلى موقعك على الويب في المُستقبل ولكنه لن يزيل أي بيانات تم جمعها بالفعل من عمليات الزحف السابقة.

إذا كنت قلقًا بشأن وصول الإضافات الجديدة لـ ChatGPT إلى محتوى الويب ، فقد نشرت OpenAI بالفعل إرشادات لحظر روبوت الدردشة الخاص بها. في هذه الحالة ، يُطلق على روبوت ChatGPT اسم ChatGPT-User ويُمكنك حظره عن طريق إضافة الكود التالي إلى ملف robots.txt لديك:

User-agent: ChatGPT-User Disallow: /

على الرغم من ذلك ، فإن منع روبوتات الذكاء الاصطناعي لمحرك البحث من الزحف إلى المحتوى الخاص بك هي مشكلة أخرى تمامًا. نظرًا لأن Google شديدة السرية بشأن بيانات التدريب التي تستخدمها ، فمن المُستحيل تحديد برامج التتبع التي ستحتاج إلى حظرها وما إذا كانت ستحترم الأوامر الموجودة في ملف robots.txt (العديد من روبوتات الزحف لا تفعل ذلك). تحقق من أفضل أدوات مُراقبة تغيير محتوى مواقع الويب المجانية والمدفوعة.

ما مدى فعاليَّة هذه الطريقة؟

يُعد حظر نماذج الذكاء الاصطناعي في ملف robots.txt أكثر الطرق فعالية المُتاحة حاليًا ، ولكنها ليست موثوقة بشكل خاص.

المشكلة الأولى هي أنه يتعين عليك تحديد كل روبوت دردشة تُريد حظره ، ولكن من يُمكنه تتبع كل روبوت ذكاء اصطناعي يصل إلى السوق؟ المشكلة التالية هي أنَّ الأوامر الموجودة في ملف robots.txt هي تعليمات غير إلزامية. بينما تحترم روبوتات الزحف المُشترك و ChatGPT والعديد من الروبوتات الأخرى هذه الأوامر ، فإنَّ هناك العديد من الأدوات لا تحترمها.

التحذير الكبير الآخر هو أنه يُمكنك فقط منع روبوتات الذكاء الاصطناعي من إجراء عمليات الزحف المُستقبلية. لا يمكنك إزالة البيانات من عمليات الزحف السابقة أو إرسال طلبات إلى شركات مثل OpenAI لمحو جميع بياناتك. تحقق من بعض المشاكل الكبيرة مع ChatGPT من OpenAI.

هل يجب منع أدوات الذكاء الاصطناعي من الوصول إلى موقع الويب؟

لسوء الحظ ، لا توجد طريقة بسيطة لمنع جميع روبوتات الدردشة بالذكاء الاصطناعي من الوصول إلى موقعك على الويب ، كما أنَّ حظر كل روبوت فردي يدويًا يكاد يكون مستحيلًا. حتى إذا كنت مُواكبًا لأحدث روبوتات الذكاء الاصطناعي التي تتجول على الويب ، فليس هناك ما يضمن أنها ستلتزم جميعًا بالأوامر الموجودة في ملف robots.txt الخاص بك.

السؤال الحقيقي هنا هو ما إذا كانت النتائج تستحق الجهد ، والإجابة القصيرة هي (بالتأكيد) لا.

هناك جوانب سلبية مُحتملة لحظر روبوتات الذكاء الاصطناعي من الوصول إلى موقع الويب الخاص بك أيضًا. الأهم من ذلك كله ، أنك لن تكون قادرًا على جمع بيانات ذات مغزى لإثبات ما إذا كانت أدوات مثل Bard تستفيد أو تضر باستراتيجية التسويق عبر البحث الخاصة بك.

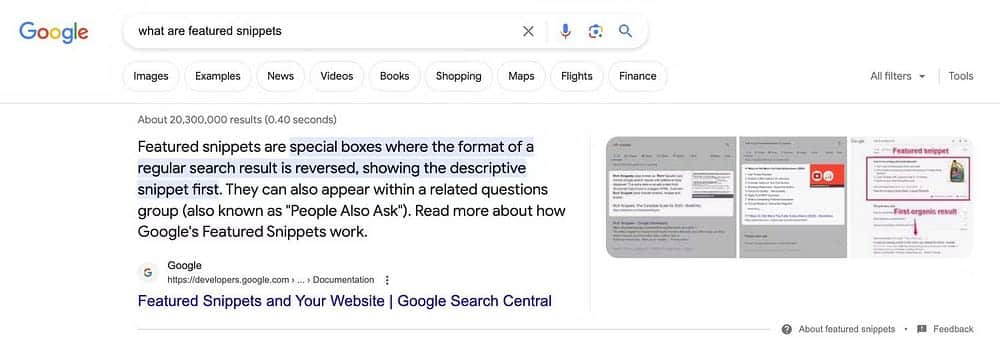

نعم ، يُمكنك أن تفترض أن قلة الاستشهادات ضارة ، لكنك لن تستطيع أن تُخمن إذا كنت تفتقر إلى البيانات لأنك حظرت روبوتات الذكاء الاصطناعي من الوصول إلى محتواك. لقد كانت هناك قصة مُماثلة عندما قدمت Google لأول مرة المقتطفات المُميزة إلى البحث.

بالنسبة إلى الاستعلامات ذات الصلة ، يعرض Google مُقتطفًا من المحتوى من صفحات الويب على صفحة النتائج ، للإجابة على سؤال المستخدم. هذا يعني أنَّ المستخدمين لا يحتاجون إلى النقر للوصول إلى موقع ويب للحصول على الإجابة التي يبحثون عنها. تسبب هذا في حالة من الذعر بين مالكي مواقع الويب وخبراء تحسين محركات البحث الذين يعتمدون على توليد حركة الزيارات من استعلامات البحث.

ومع ذلك ، فإن نوع الاستعلامات التي تؤدي إلى تشغيل المقتطفات المميزة هي بشكل عام عمليات بحث منخفضة القيمة مثل “ما هو X” أو “كيف هو الطقس في نيويورك”. أي شخص يُريد معلومات مُتعمقة أو تقريرًا شاملاً عن الطقس سيواصل النقر على النتائج ، وأولئك الذين لا يرغبون في الحصول على معلومات مُتعمقة أو تقرير شامل عن الطقس ، لم يكونوا أبدًا بهذه القيمة في المقام الأول.

قد تجد أنها قصة مشابهة لأدوات الذكاء الاصطناعي التوليدي ، لكنك ستحتاج إلى البيانات لإثبات ذلك. تحقق من أخطاء يجب تجنبها عند استخدام أدوات الذكاء الاصطناعي التوليدي.

لا تتسرع في أي شيء

من المفهوم أنَّ مالكي وناشري مواقع الويب قلقون بشأن تقنية الذكاء الاصطناعي ، كما أنهم مُحبطون من فكرة استخدام الروبوتات لمُحتواهم لتوليد ردود فورية. ومع ذلك ، هذا ليس الوقت المناسب للاندفاع إلى حركات هجوم مُضاد. تعد تقنية الذكاء الاصطناعي مجالًا سريع الحركة ، وستستمر الأشياء في التطور بوتيرة سريعة. اغتنم هذه الفرصة لترى كيف تسير الأمور وتحليل التهديدات والفرص المُحتملة التي يجلبها الذكاء الاصطناعي إلى الطاولة.

النظام الحالي للاعتماد على عمل منشئ المحتوى لاستبدالهم ليس مُستدامًا. سواء قامت شركات مثل Google و OpenAI بتغيير نهجها أو قامت الحكومات بإدخال لوائح جديدة ، هناك شيء يجب أن تُقدمه. في الوقت نفسه ، أصبحت الآثار السلبية لروبوتات الدردشة بالذكاء الاصطناعي على إنشاء المحتوى واضحة بشكل متزايد ، ويُمكن لمالكي مواقع الويب ومُنشئي المحتوى استخدامها لصالحهم. يُمكنك الإطلاع الآن على الطرق التي قد تُنظم بها الحكومات أدوات الذكاء الاصطناعي.