يُعد ملف Robots.txt أحد أبسط الملفات الموجودة على موقع الويب ، ولكنه أيضًا أحد الملفات الذي يُمكن أن يُسبب الكثير من الفوضى. يُمكن أن يؤدي حرف واحد فقط خارج المكان المناسب له إلى إحداث الكثير من المشاكل في SEO لديك وسيمنع محركات البحث من الوصول إلى المحتوى المهم على موقعك.

فهل سبق لك أن سمعت بمصطلح Robots.txt وتساءلت عن كيفية استخدامه على موقع الويب؟ تحتوي معظم مواقع الويب على ملف Robots.txt مُخصص ، ولكن هذا لا يعني أن معظم مشرفي المواقع يفهمون كيفية التعامل معه.

في هذا الموضوع ، نأمل أن نُغير ذلك من خلال توفير دليل مُتعمق حول ملف Robots.txt ، وكذلك كيف يُمكن التحكم والحد من وصول محركات البحث إلى موقع الويب الخاص بك.

بحلول نهاية هذه المقالة ، ستتمكن من الإجابة عن أسئلةٍ مثل:

- ما هو ملف Robots.txt؟

- كيف يساعد ملف Robots.txt موقع الويب الخاص بي؟

- كيف يمكنني إضافة Robots.txt إلى وردبريس؟

- ما أنواع القواعد التي يمكنني وضعها في Robots.txt؟

- كيف يمكنني اختبار ملف robots.txt؟

- كيف تقوم مواقع WordPress الكبيرة بتنفيذ ملف Robots.txt؟

هناك الكثير من التفاصيل لتغطيتها ، لذلك دعونا نبدأ!

ما هو ملف Robots.txt؟

قبل أن نتحدث عن ملف Robots.txt في حد ذاته ، من المهم تحديد ما الذي يعنيه Robots في هذه الحالة. الروبوتات هي أي نوع من “برامج الزحف” التي تزور مواقع الويب. المثال الأكثر شيوعًا هي زواحف محركات البحث. تعمل هذه الآلية على الزحف حول الويب لمساعدة محركات البحث مثل Google من أجل فهرسة وترتيب المليارات من الصفحات على الإنترنت.

لذا ، فإن البوتات ، بشكل عام ، شيء جيد للإنترنت … أو على الأقل شيء ضروري. ولكن هذا لا يعني بالضرورة أنك أو أيٌ من مشرفي مواقع الويب الآخرين يُريدون أن تتوجه هذه البوتات في جميع الأرجاء دون أي نوع من القيود.

أدت الرغبة في التحكم في كيفية تفاعل زاحف الشبكة مع مواقع الويب إلى إنشاء معيار استبعاد البوتات في منتصف التسعينات. ملف Robots.txt هو الخيار العملي لهذا المعيار – فهو يسمح لك بالتحكم في كيفية تفاعل البوتات المُشارِكة مع موقعك. يمكنك حظر الزاحف تمامًا ، وتقييد وصوله إلى مناطق معينة من موقعك ، والمزيد.

جزء “المُشارِكة” مُهم بالرغم من ذلك. لا يُمكن لملف robots.txt إجبار البوت على اتباع توجيهاته. ويمكن للبوتات الخبيثة أن تتجاهل ملف robots.txt. بالإضافة إلى ذلك ، تتجاهل المنظمات ذات السمعة الطيبة بعض الأوامر التي قد تُضيفها إلى ملف Robots.txt. على سبيل المثال ، ستتجاهل Google أي قواعد تضيفها إلى ملف robots.txt الخاص بك حول عدد المرات التي تزورها بوتات الزحف. إذا كنت تواجه الكثير من المشكلات مع البوتات ، فقد يكون الحل الأمني مثل Cloudflare أو Sucuri مفيدًا.

لماذا يجب أن تهتم بملف robots.txt الخاص بك؟

بالنسبة لمعظم مشرفي مواقع الويب ، تتلخص مزايا ملف robots.txt جيد التنظيم في فئتين:

- تحسين موارد الزحف لمحركات البحث من خلال إخبارها بعدم إضاعة الوقت على الصفحات التي لا تُريد فهرستها. وهذا يساعد على ضمان تركيز محركات البحث على الزحف إلى الصفحات التي تُهمك أكثر.

- تحسين استخدام الخادم الخاص بك عن طريق حظر البوتات التي تُهدر الموارد.

لا يتعلق ملف Robots.txt بالتحكم في تحديد الصفحات التي تتم فهرستها من محركات البحث

إن ملف Robots.txt ليس طريقة مضمونة للتحكم في الصفحات التي يتم فهرستها من محركات البحث. إذا كان هدفك الأساسي هو منع تضمين صفحات معينة في نتائج محرك البحث ، فإن الطريقة الصحيحة هي استخدام عنصر التعريف noindex أو طريقة مباشرة أخرى مشابهة.

وذلك لأن ملف Robots.txt الخاص بك لا يطلب من محركات البحث مباشرةً عدم فهرسة المحتوى – إنه فقط يطلب منها عدم الزحف إليه. على الرغم من أن Google لن يزحف إلى المناطق التي تم وضع علامة لعدم الزحف إليها من داخل موقعك ، فإن Google نفسها تنص على أنه إذا كان هناك موقع خارجي يرتبط بصفحة تستبعدها من خلال ملف Robots.txt الخاص بك ، فإن Google قد يستمر في فهرسة تلك الصفحة.

قد لا تتوافق توجيهات ملف robots.txt مع جميع محركات البحث

لا تستطيع التعليمات الموجودة في ملفات robots.txt فرض سلوك محدّد على الزاحف إلى موقع الويب لأن الزاحف هو من يتخذ قرار اتّباع هذه التعليمات أو لا. وبينما يتّبع Googlebot وزواحف الويب الأخرى حسنة السمعة إرشادات ملف robots.txt، قد لا تتبعها الزواحف الأخرى. لذا إذا أردت الحفاظ على المعلومات آمنة من زواحف الويب، فمن الأفضل استخدام طرق حظر أخرى مثل حماية الملفات الخاصة على الخادم بكلمة مرور.

كيفية إنشاء وتحرير ملف Robots.txt

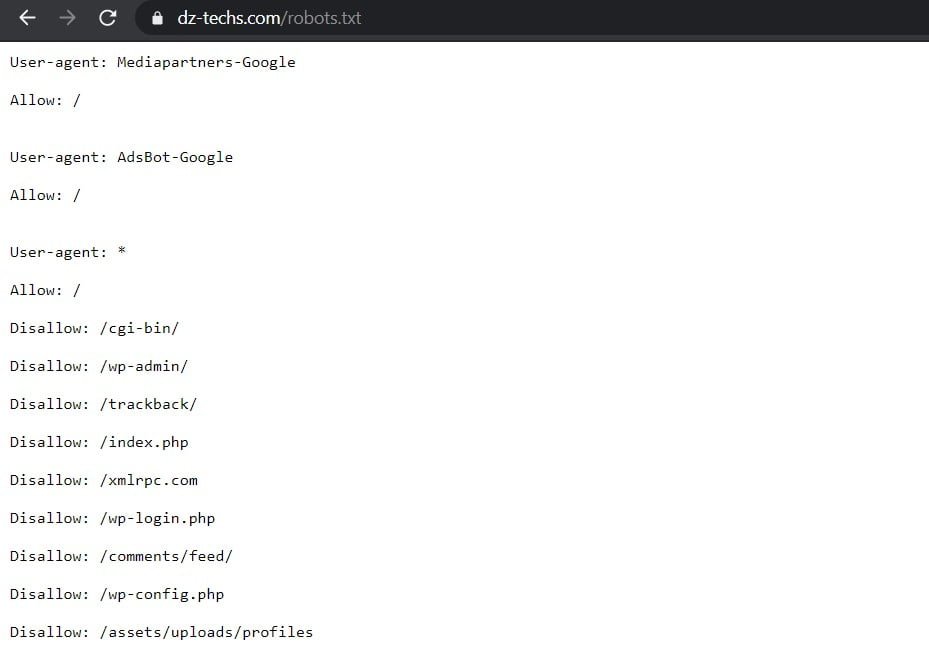

بشكل افتراضي ، يقوم WordPress تلقائيًا بإنشاء ملف robots.txt افتراضي لموقعك. لذلك حتى إذا لم تقم بأي شيئ ، يجب أن يحتوي موقعك بالفعل على ملف robots.txt الافتراضي. يُمكنك اختبار ما إذا كان هذا هو الحال من خلال إلحاق “/robots.txt” بنهاية اسم النطاق الخاص بك. على سبيل المثال ، يعرض “https://www.dz-techs.com/robots.txt” ملف robots.txt الذي نستخدمه هنا في Dz Techs:

بالنسبة للملف افتراضي ، لا يُمكنك تعديله مباشرةً. إذا كنت تُريد تعديل ملف robots.txt الخاص بك ، فستحتاج فعليًا إلى إنشاء ملف مُخصص على خادمك يُمكنك تعديله حسب الحاجة. فيما يلي ثلاث طرق بسيطة للقيام بذلك …

كيفية إنشاء وتحرير ملف Robots.txt باستخدام Yoast SEO

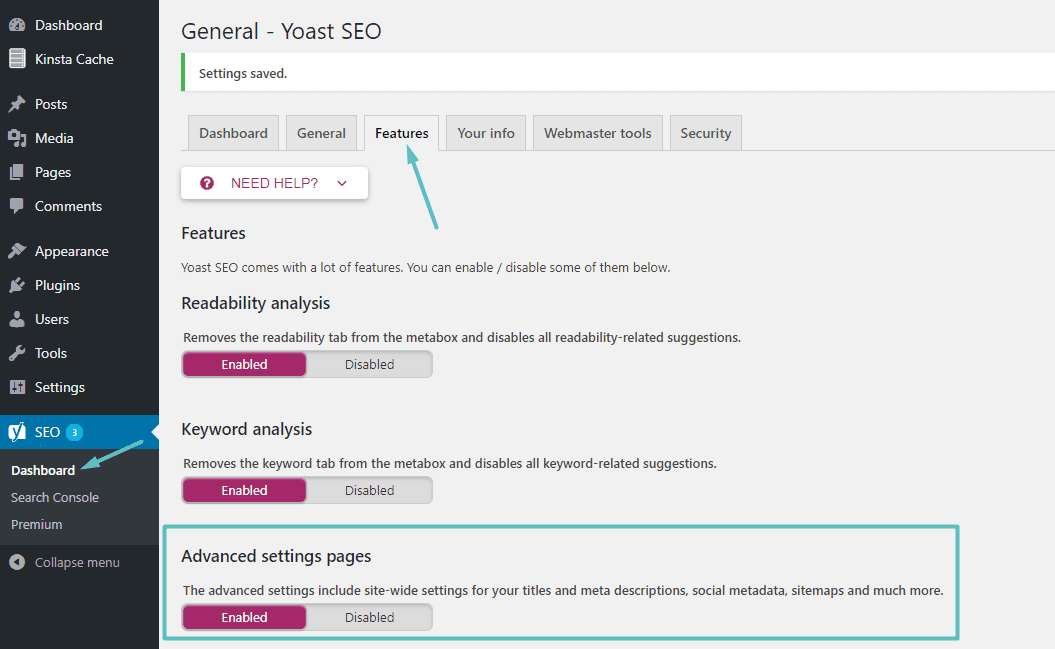

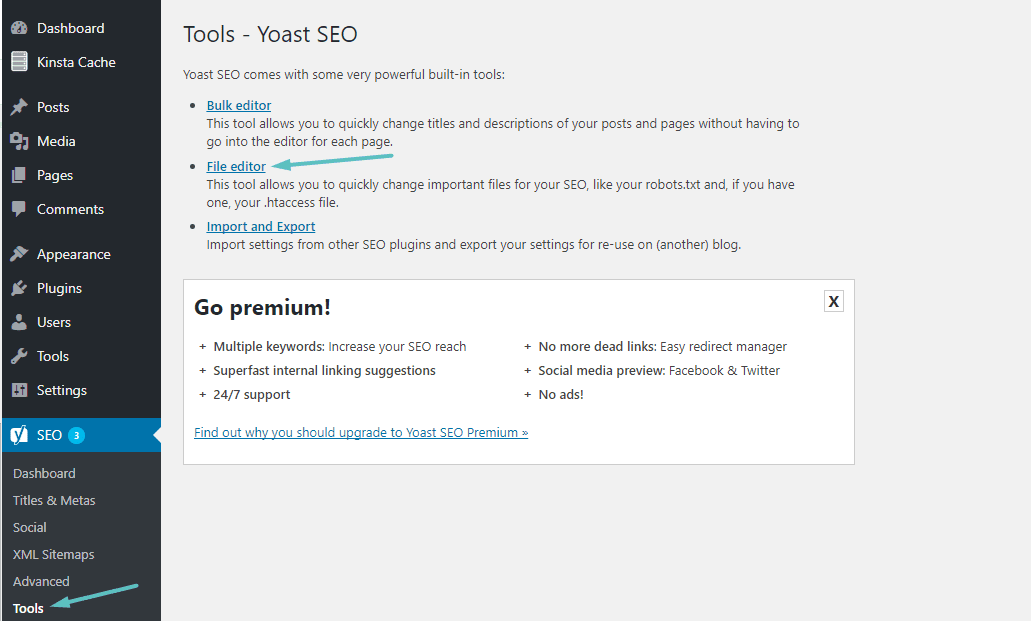

إذا كنت تستخدم الإضافة الشهيرة Yoast SEO ، يمكنك إنشاء (وتعديله لاحقًا) ملف robots.txt مباشرةً من واجهة Yoast. قبل أن تتمكن من الوصول إلى هذا الخيار ، تحتاج إلى تمكين ميزات Yoast SEO المتقدمة من خلال الانتقال إلى SEO → Dashboard → Features وتمكين شريط التمرير بجوار صفحات الإعدادات المتقدمة:

بمجرد تمكينه ، يمكنك الإنتقال إلى SEO → Tools والنقر على محرر الملف:

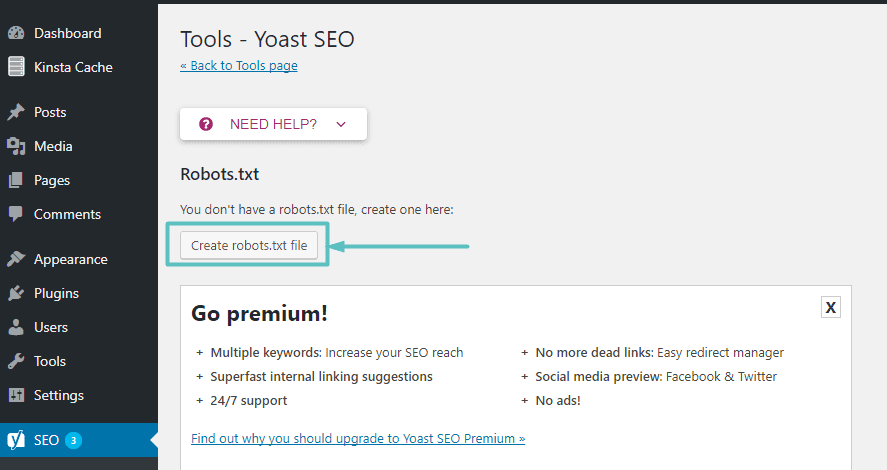

على افتراض أن موقع الويب لا يحتوي على ملف Robots.txt فعليًا ، ستُوفر لك Yoast خيارًا لإنشاء ملف robots.txt:

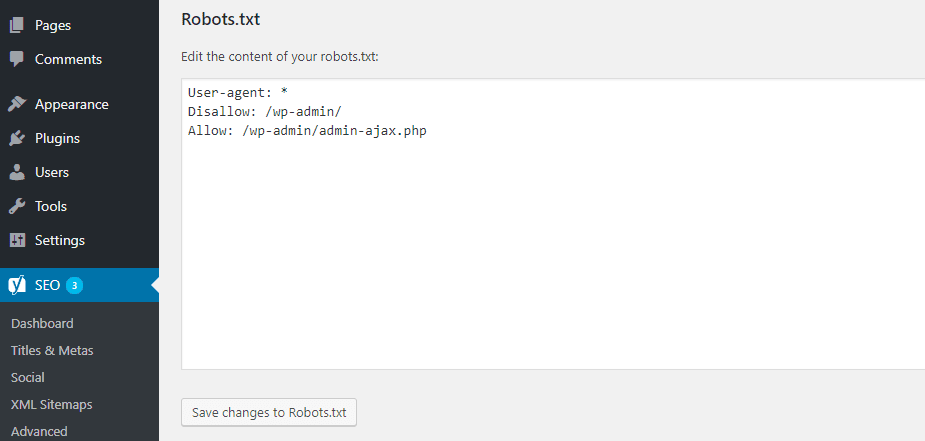

وبمجرد النقر فوق هذا الزر ، ستتمكن من تحرير محتويات ملف Robots.txt مباشرةً من نفس الواجهة:

بينما تُواصل القراءة ، سنبحث أكثر في أنواع التوجيهات التعليمية التي يُمكنك إضافتها في ملف robots.txt الخاص بك على موقع الويب.

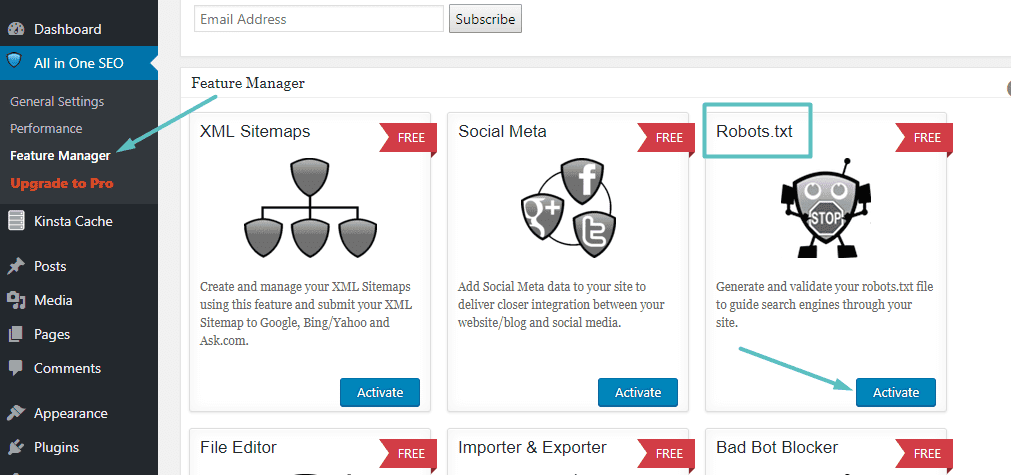

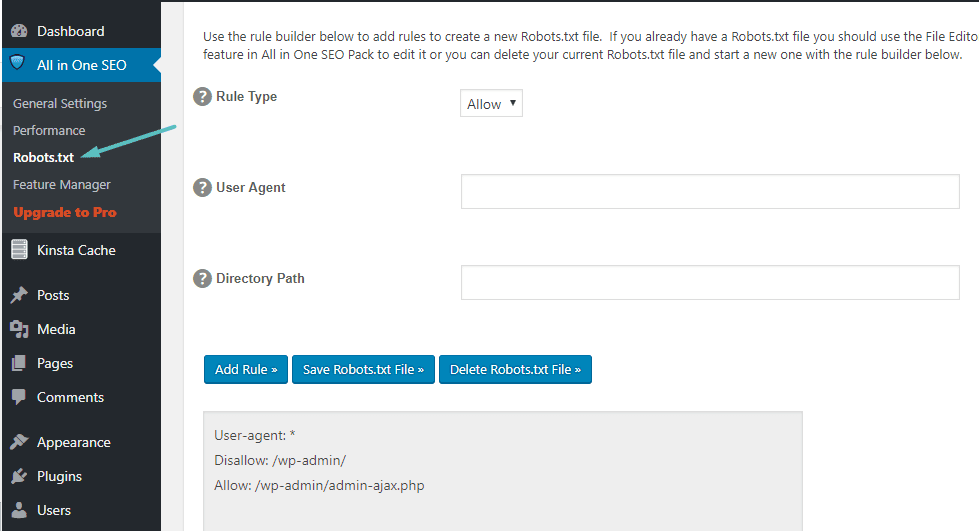

كيفية إنشاء وتحرير ملف Robots.txt باستخدام All In One SEO

إذا كنت تستخدم الإضافية الشعبية الأخرى التي تُشبه Yoast إلى حد ما: All in One SEO Pack ، فيُمكنك أيضًا إنشاء وتعديل ملف robots.txt مباشرةً من واجهة الإضافة. كل ما عليك فعله هو الانتقال إلى All in One SEO → Feature Manager وتفعيل ميزة Robots.txt:

بعد ذلك ، ستتمكن من إدارة ملف Robots.txt من خلال الانتقال إلى All in One SEO → Robots.txt:

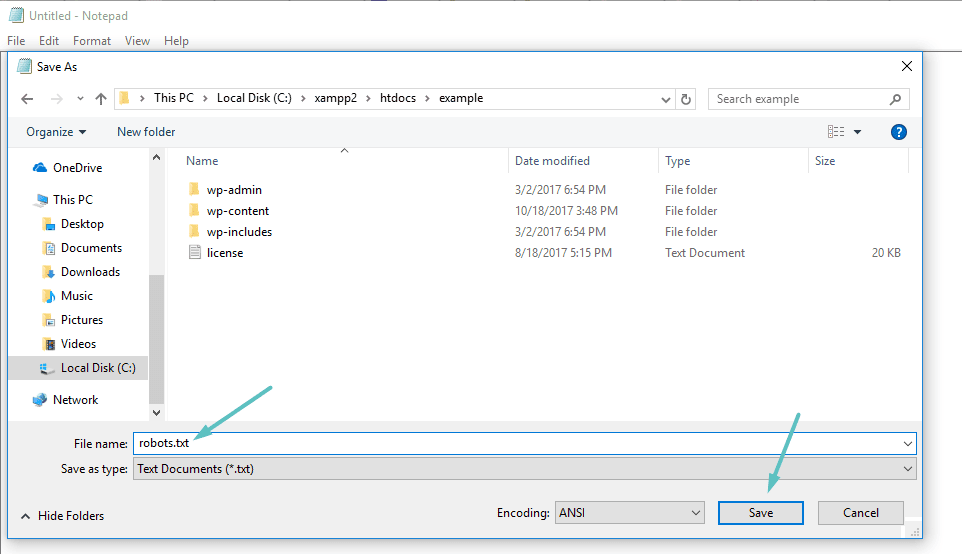

كيفية إنشاء وتحرير ملف Robots.txt عبر FTP

إذا كنت لا تستخدم إضافة SEO التي تُوفر إمكانية الوصول إلى ملف robots.txt ، فلا يزال بإمكانك إنشاء ملف robots.txt وإدارته عبر SFTP. أولاً ، استخدم أي محرر نصوص لإنشاء ملف فارغ باسم “robots.txt”:

بعد ذلك ، قم بالاتصال بموقعك عبر SFTP وتحميل هذا الملف إلى مجلد جذر موقعك على الويب. يُمكنك إجراء المزيد من التعديلات على ملف robots.txt الخاص بك عن طريق تحريره عبر SFTP أو تحميل إصدارات جديدة من الملف في كل مرة.

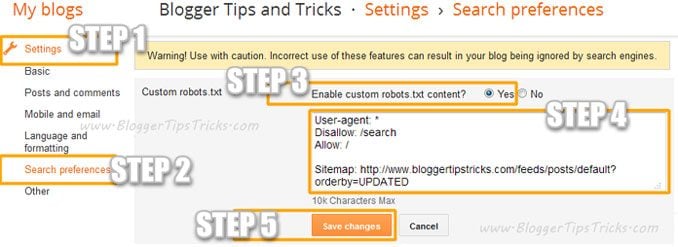

إضافة ملف Robots.Txt مخصص إلى Blogger

يُمكنك إضافة ملف robots.txt مُخصص إلى Blogger من خلال هذه الخطوات:

- انتقل إلى مدونتك.

- انتقل إلى

الإعدادات >> تفضيلات البحث ›› برامج الزحف والفهرسة ›› Custom robots.txt ›› تحرير ›› نعم - الآن قم بلصق كود ملف robots.txt الخاص بك في المربع.

- انقر على زر حفظ التغييرات.

ما الذي يتم عرضه في ملف Robots.txt؟

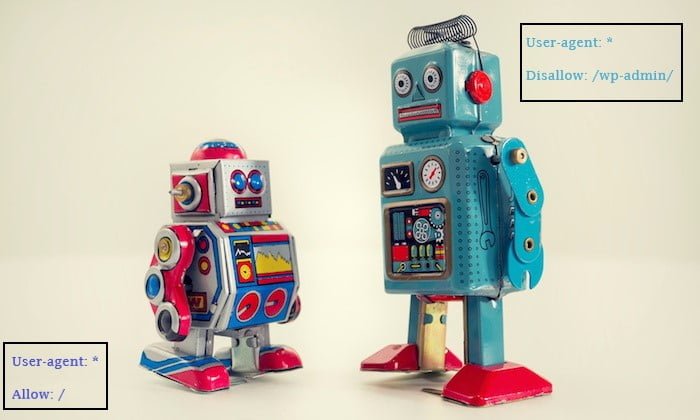

حسنًا ، لديك الآن ملف robots.txt فعلي على خادمك يُمكنك تعديله حسب الحاجة. ولكن ماذا تفعل في الواقع مع هذا الملف؟ حسنًا ، كما علمت في القسم الأول ، يتيح لك ملف robots.txt التحكم في كيفية تفاعل البوتات مع مختلف المحتوى المعروض على موقعك. يُمكنك القيام بذلك باستخدام أمرين أساسيين:

User-agent– يتيح لك هذا استهداف برامج زحف معينة. وكيل المستخدم هو ما يستخدمه الزاحف للتعريف بنفسه. باستخدامه ، يُمكنك ، على سبيل المثال ، إنشاء قاعدة تنطبق على الزاحف من Bing ، ولكن ليس على الزاحف من Google.Disallow– يتيح لك هذا إخبار برامج الزحف بعدم الوصول إلى مناطق معينة من موقعك.

هناك أيضًا أمر Allow ستستخدمه في المواقف المتخصصة. بشكل افتراضي ، يتم وضع علامة Allow على كل شيء على موقعك ، لذلك ليس من الضروري استخدام الأمر Allow في 99٪ من المواقف. ولكنه مُفيد عندما تُريد عدم السماح بوصول برامج الزحف إلى مجلد ومجلداته الفرعية ولكن السماح بالوصول إلى مجلد فرعي مُحدد.

يُمكنك إضافة قواعد من خلال تحديد وكيل المستخدم الذي يجب أن تنطبق عليه القاعدة أولاً ثم تحديد القواعد التي يجب تطبيقها باستخدام العلامتين Disallow و Allow. هناك أيضًا بعض الأوامر الأخرى مثل Crawl-delay و Sitemap ، ولكن هذه إما:

- يتم تجاهلها من قبل معظم برامج الزحف الرئيسية ، أو يتم تفسيرها بطرق مُختلفة تمامًا (في حالة

Crawl-delay). - أصبحت إضافية بسبب أدوات مثل Google Search Console (في حالة

Sitemap)

دعنا ننتقل إلى بعض حالات الاستخدام المحددة لنوضح لك كيف يُمكن استخدام كل هذه الأوامر معًا.

كيفية استخدام Robots.txt لمنع الوصول إلى موقعك بالكامل

لنفترض أنك تُريد منع جميع برامج الزحف من الوصول إلى موقعك. من غير المحتمل أن يحدث هذا على موقع قيد التشغيل ، ولكنه مفيد لموقع قيد التطوير. للقيام بذلك ، ستُضيف هذا الرمز إلى ملف robots.txt الخاص بك:

User-agent: * Disallow: /

ما الذي يحدث في هذا الرمز؟

العلامة النجمية * بجانب User-agent تعني “جميع وكلاء المستخدم“. العلامة النجمية هي حرف البدل ، مما يعني أن هذه الأوامر تنطبق على كل وكلاء المستخدم. يشير الخط المائل / الموجود بجوار Disallow إلى أنك تُريد عدم السماح بالوصول إلى جميع الصفحات التي تحتوي على “yourdomain.com/” (وهذا يعني جميع الصفحات على موقعك).

كيفية استخدام Robots.txt لمنع زاحف واحد من الوصول إلى موقعك

دعنا نغير الأمور. في هذا المثال ، سنتظاهر أنك لا تحب حقيقة أن محرك البحث Bing يزحف إلى صفحاتك. أنت من محبي مُحرك البحث من Google ولا تُريد حتى أن ينظر Bing إلى موقعك. لمنع Bing فقط من الزحف إلى موقعك ، يجب استبدال العلامة النجمية * بـ Bingbot:

User-agent: Bingbot Disallow: /

بشكل أساسي ، ينص الرمز أعلاه على تطبيق قاعدة Disallow فقط على برامج الزحف التي تقوم باستخدام وكيل المستخدم “Bingbot”. الآن ، من غير المحتمل أن ترغب في منع الوصول من Bing – ولكن هذا السيناريو يكون مفيدًا إذا كان هناك زاحف محدد لا تُريده أم يقوم بالوصول إلى موقعك. يحتوي هذا الموقع على قائمة جيدة لمعظم أسماء وكلاء المستخدم المعروفة.

كيفية استخدام Robots.txt لمنع الوصول إلى مجلد أو ملف معين

في هذا المثال ، لنفترض أنك تُريد فقط حظر الوصول إلى ملف أو مجلد معين (وجميع المجلدات الفرعية لهذا المجلد). لتطبيق هذا على موقعك ، لنفترض أنك تُريد حظر كل من:

- مجلد wp-admin بأكمله

- صفحة wp-login.php

يُمكنك استخدام الأوامر التالية:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-login.php

كيفية استخدام ملف Robots.txt للسماح بالوصول إلى ملف محدد في مجلد غير مسموح به

حسنًا ، لنفترض الآن أنك تُريد حظر مجلد كامل ، ولكنك ما زلت تُريد السماح بالوصول إلى ملف معين داخل هذا المجلد. هذا هو المكان الذي يكون فيه الأمر Allow مفيدًا. وهي في الواقع عملية قابلة للتطبيق على موقعك. في الواقع ، يُوضح ملف robots.txt الافتراضي في WordPress هذا بشكل مثالي:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

يمنع هذا الرمز الوصول إلى كامل مجلد /wp-admin/ باستثناء ملف /wp-admin/admin-ajax.php.

كيفية استخدام Robots.txt لوقف البوتات من الزحف إلى نتائج البحث في موقعك

أحد التعديلات الخاصة بموقعك والتي قد ترغب في إجرائها هي منع زاحف البحث من الوصول إلى صفحات نتائج البحث الخاصة بموقعك. بشكل افتراضي ، يستخدم WordPress معلمة الاستعلام “؟s =” لعرض نتائج البحث. لذلك لمنع الوصول ، كل ما عليك فعله هو إضافة القاعدة التالية:

User-agent: * Disallow: /?s= Disallow: /search/

يمكن أن تكون هذه طريقة فعالة لإيقاف أخطاء 404 إذا كنت تُواجه الكثير منها.

كيفية إنشاء قواعد مختلفة لبرامج الزحف المختلفة في ملف robots.txt

حتى الآن ، تعاملت جميع الأمثلة مع قاعدة واحدة في كل مرة. ولكن ماذا لو كنت تُريد تطبيق قواعد مختلفة على برامج الزحف المختلفة؟ تحتاج ببساطة إلى إضافة كل مجموعة من القواعد تحت تصريح وكيل المستخدم لكل زاحف. على سبيل المثال ، إذا كنت تُريد إنشاء قاعدة واحدة تنطبق على جميع برامج الزحف وقاعدة أخرى تنطبق على Bingbot فقط ، فيمكنك القيام بذلك على النحو التالي:

User-agent: * Disallow: /wp-admin/ User-agent: Bingbot Disallow: /

في هذا المثال، سيتم حظر جميع برامج الزحف من الوصول إلى /wp-admin ، ولكن سيتم منع Bingbot من الوصول إلى موقعك بالكامل.

قواعد robots.txt المفيدة

في ما يلي بعض قواعد robots.txt المفيدة والشائعة:

| مثال | القاعدة |

User-agent: * Disallow: / | منع الزحف إلى موقع الويب بأكمله. تجدر الإشارة إلى أنه في بعض الحالات من الممكن أن تستمر فهرسة عناوين URL من موقع الويب حتى لو لم يتم الزحف إليها. ملاحظة: لا تتطابق هذه القاعدة مع برامج زحف AdsBot المختلفة، التي ينبغي تعيينها بوضوح. |

User-agent: * Disallow: /calendar/ Disallow: /junk/ | منع الزحف إلى دليل ما ومحتوياته عن طريق إضافة شرطة مائلة للأمام بعد اسم الدليل. تجدر الإشارة إلى أنه يتعين عليك عدم استخدام ملف robots.txt لحظر الوصول إلى المحتوى الخاص وننصحك باستخدام مصادقة مناسبة بدلاً من ذلك. من الممكن أن تستمر فهرسة عناوين URL التي تم منعها بواسطة ملف robots.txt بدون أن يتم الزحف إليها ويمكن لأي شخص مشاهدة ملف robots.txt وهو ما قد يكشف موقع المحتوى الخاص الذي لا تريد أن يطّلع عليه أحد غيرك. |

User-agent: Googlebot-news Allow: / User-agent: * Disallow: / | السماح بوصول زاحف واحد |

User-agent: Unnecessarybot Disallow: / User-agent: * Allow: / | السماح بوصول جميع برامج الزحف باستثناء زاحف واحد |

User-agent: * Disallow: /private_file.html | منع الزحف إلى صفحة ويب واحدة عن طريق إدراج الصفحة بعد الشرطة المائلة |

User-agent: Googlebot-Image Disallow: /images/dogs.jpg | حظر صورة معيّنة من صور Google: |

User-agent: Googlebot-Image Disallow: / | حظر كل الصور على موقعك الإلكتروني من صور Google: |

User-agent: Googlebot Disallow: /*.gif$ | منع الزحف إلى ملفات من نوع معيّن (مثل .gif): |

User-agent: * Disallow: / User-agent: Mediapartners-Google Allow: / | منع الزحف إلى الموقع بأكمله، ولكن مع عرض إعلانات AdSense على تلك الصفحات، ومنع وصول جميع برامج زحف الويب الأخرى بخلاف Mediapartners-Google. ويؤدي هذا إلى إخفاء الصفحات من نتائج البحث، ولكن يظل بإمكان زاحف الويب Mediapartners-Google تحليل الصفحات لتحديد الإعلانات التي سيعرضها لزوّار موقعك الإلكتروني. |

User-agent: Googlebot Disallow: /*.xls$ | لمطابقة عناوين URL التي تنتهي بسلسلة معيّنة، يمكنك استخدام $. على سبيل المثال، يؤدي نموذج الرمز إلى حظر الوصول إلى أي عناوين URL تنتهي بالامتداد .xls: |

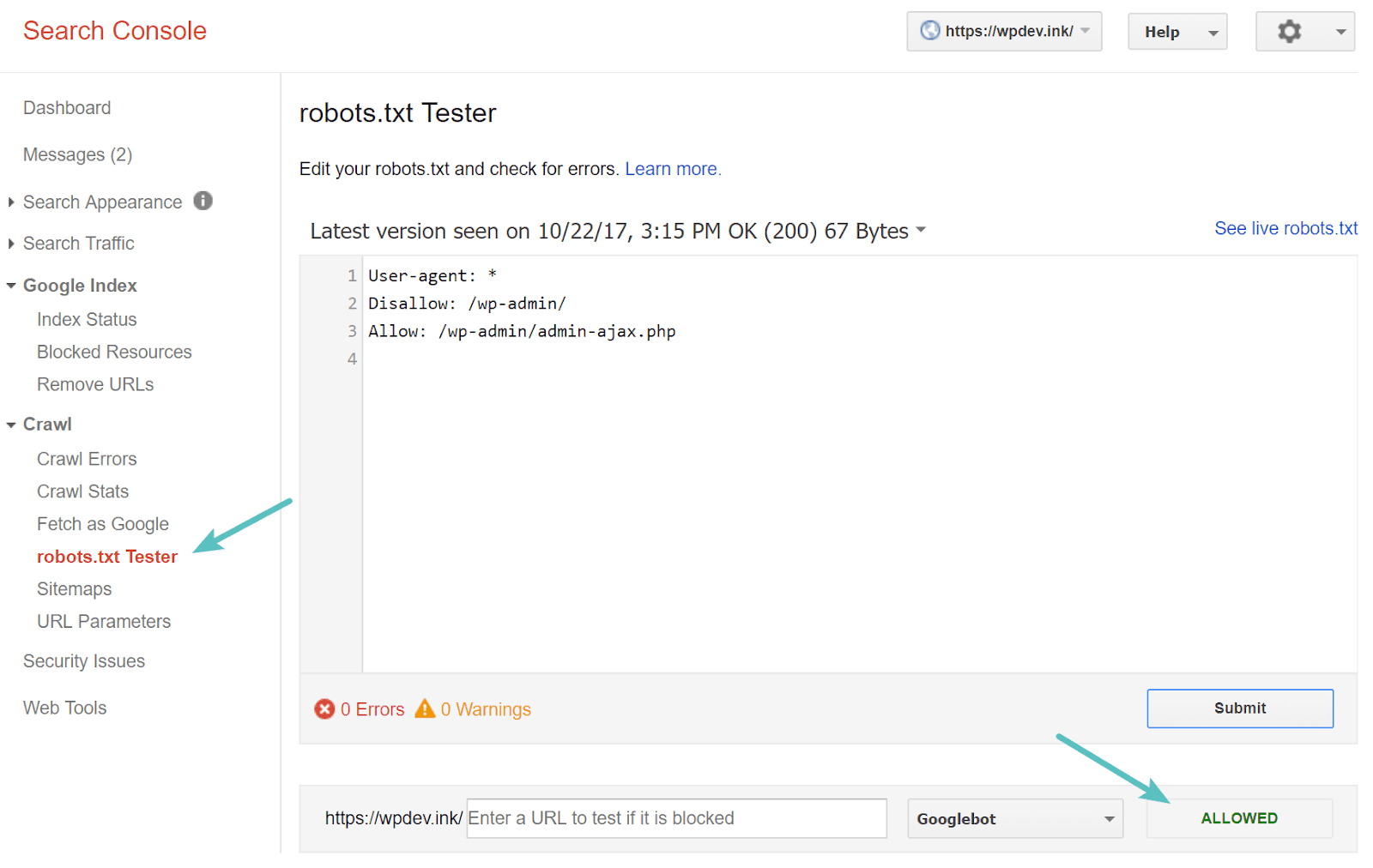

اختبار ملف Robots.txt الخاص بك

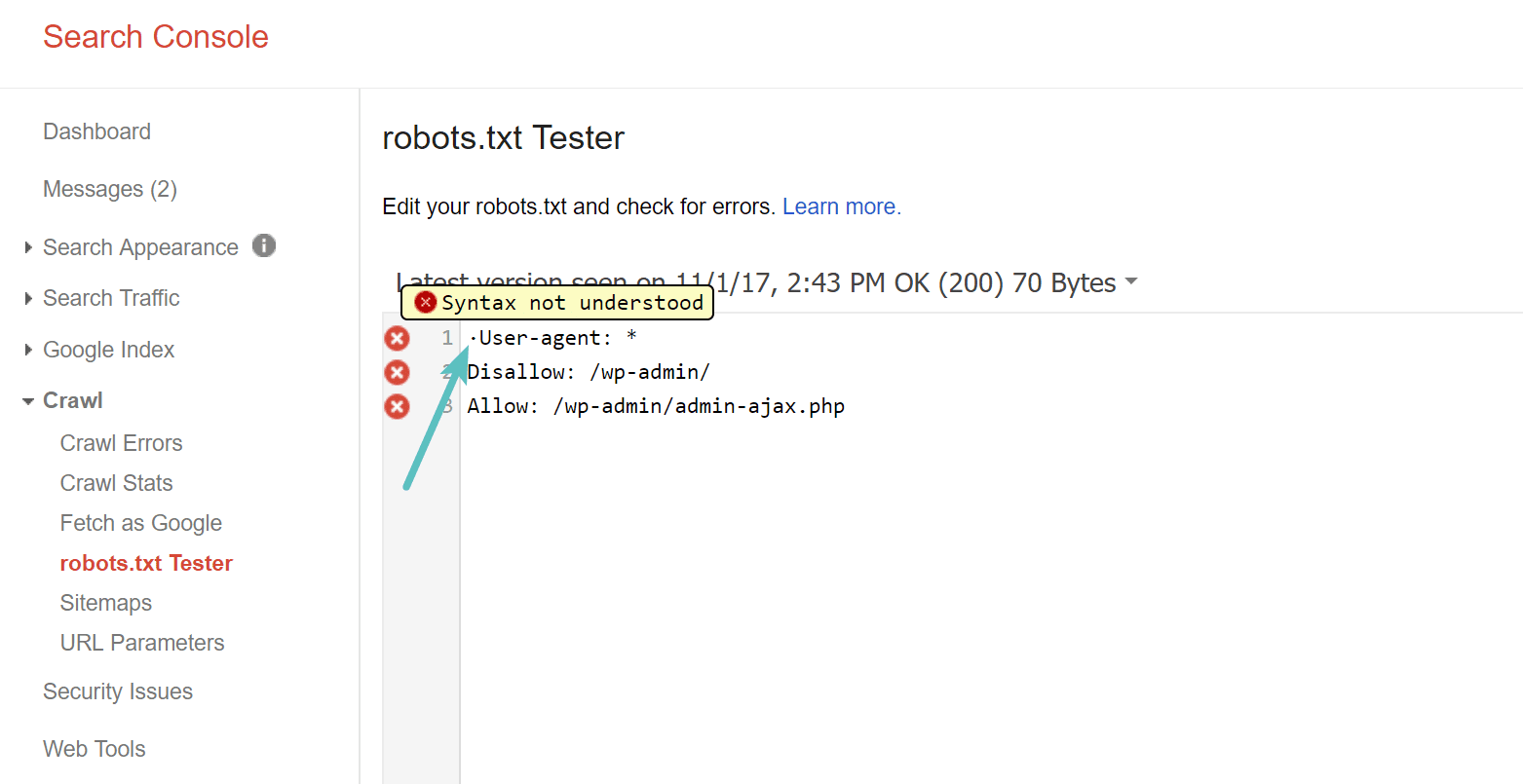

يُمكنك اختبار ملف robots.txt الخاص بك في Google Search Console للتأكد من إعداده بشكل صحيح. ما عليك سوى النقر على موقعك ، وضمن “الزحف” ، انقر على “robots.txt Tester“. يمكنك بعد ذلك اختبار إرسال أي عنوان URL ، بما في ذلك صفحتك الرئيسية. يجب أن ترى علامة خضراء تُشير إلى أنه تم السماح بالوصول إذا كان كل شيء قابلًا للزحف. يُمكنك أيضًا اختبار عناوين URL التي قمت بحظرها للتأكد من حظرها بالفعل ، أو عدم السماح بها.

احذر من UTF-8 BOM

BOM تعني علامة ترتيب البايتات وهي في الأساس حرف غير مرئي تتم إضافته في بعض الأحيان إلى الملفات بواسطة محرري النصوص القديمة وما شابه. إذا حدث ذلك لملف robots.txt ، فقد لا يقرأه Google أو محركات البحث الأخرى بشكل صحيح. هذا هو السبب في أنه من المهم التحقق من ملفك بحثًا عن أي أخطاء. على سبيل المثال ، كما هو موضح أدناه ، كان الملف الخاص بنا يحتوي على حرف غير مرئي مما أدى إلى عدم فهم بناء الجملة من طرف Google. وهذا يُبطل بشكل أساسي السطر الأول من ملف robots.txt تمامًا ، وهذا ليس جيدًا! يحتوي Glenn Gabe على مقالة ممتازة حول كيف يُمكن لـ UTF-8 Bom قتل SEO الخاص بك.

يقع Googlebot في الأساس في الولايات المتحدة

من المهم أيضًا عدم حظر Googlebot من الولايات المتحدة ، حتى إذا كنت تستهدف منطقة محلية خارج الولايات المتحدة. يقوم هذا البوت في بعض الأحيان بالزحف المحلي ، ولكن Googlebot يقع في الغالب في الولايات المتحدة.

ما هي المعلومات التي تقوم مواقع الويب الشائعة بإضافتها في ملف robots.txt

لتوفير بعض السياق للنقاط المذكورة أعلاه ، إليك كيفية استخدام بعض مواقع الويب الأكثر شيوعًا لملفات robots.txt الخاصة بها.

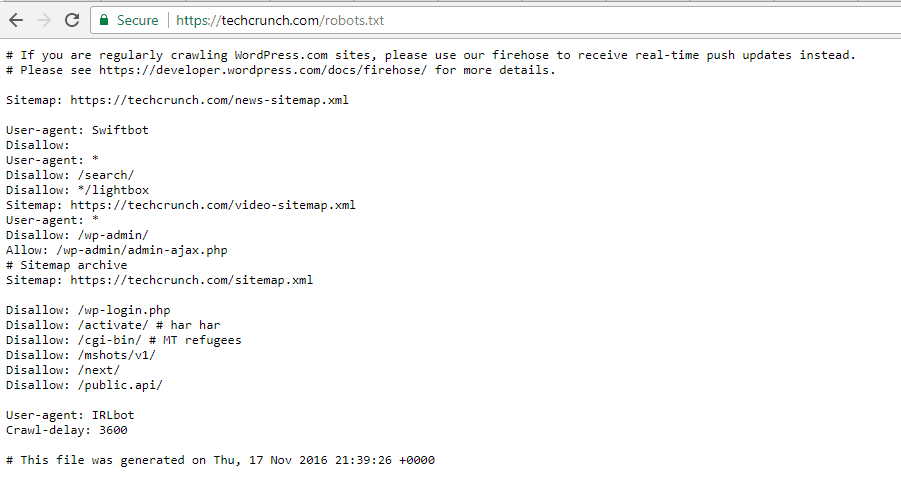

TechCrunch

بالإضافة إلى تقييد الوصول إلى عدد من الصفحات الفريدة، لا يسمح على وجه الخصوص الزحف إلى:

- /wp-admin/

- /wp-login.php

كما يتم وضع قيود خاصة على بعض من برامج الزحف:

- Swiftbot

- IRLbot

إذا كنت مهتمًا ، فإن IRLbot هو زاحف من مشروع بحثي بجامعة تكساس A&M. هذا غريب!

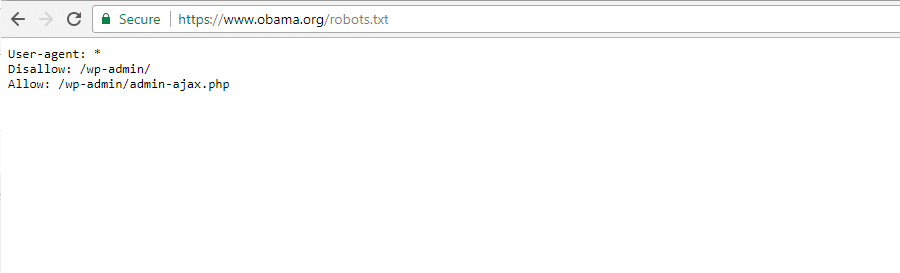

The Obama Foundation

لم يقم موقع The Obama Foundation بأي إضافات خاصة ، باختياره حصريًا تقييد الوصول إلى /wp-admin/.

Angry Birds

يحتوي Angry Birds على نفس الإعداد الافتراضي مثل The Obama Foundation. لا شيء خاص قد تم إضافته.

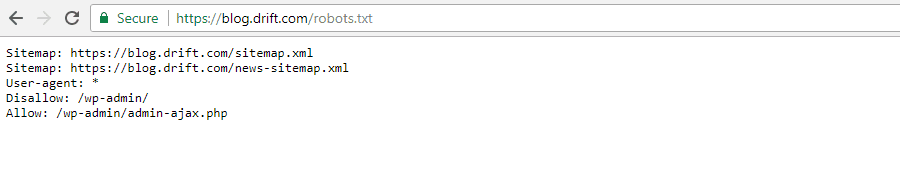

Drift

وأخيرا، اختار Drift تحديد ملفات خرائط الموقع الخاصة به في ملف Robots.txt ، ولكن بخلاف ذلك، ترك القيود الافتراضية نفسها مثل Angry Birds.

استخدام Robots.txt بالطريقة الصحيحة

بينما نختتم هذا الدليل ، نود تذكيرك مرة أخرى بأن استخدام أمر Disallow ليس مثل استخدام علامة noindex. يمنع ملف robots.txt الزحف ، ولكن ليس بالضرورة الفهرسة. يُمكنك استخدامه لإضافة قواعد محددة لتشكيل كيفية تفاعل محركات البحث وبرامج الزحف الأخرى مع موقعك ، ولكنه لن يتحكم بشكل صريح في ما إذا كان المحتوى الخاص بك قابلًا للفهرسة أم لا.

بالنسبة لمعظم مستخدمي WordPress العاديين ، ليست هناك حاجة ملحة لتعديل ملف robots.txt الافتراضي. ولكن إذا كنت تواجه مشكلات في برنامج زحف معين ، أو تريد تغيير كيفية تفاعل محركات البحث مع إضافة أو قالب معين تستخدمه ، فقد ترغب في إضافة قواعدك الخاصة.

نأمل أن تكون قد استمتعت بهذا الدليل وتأكد من ترك تعليق إذا كان لديك أي أسئلة أخرى حول استخدام ملف robots.txt الخاص بك على موقع الويب.