Tard dans la nuit, tes parents reçoivent un message vocal plein de panique de ta part, indiquant que tu as des ennuis et que tu as besoin d'aide, que ton portefeuille a été volé et que tu es coincé dans un endroit inconnu. L’argent doit vous être transféré immédiatement afin que vous puissiez rentrer chez vous.

La voix dans la lettre semble très réelle et est sans aucun doute la voix de son enfant, mais ce n'est pas le cas. C'est un clone de voix d'IA qui est devenu la cible d'une arnaque aussi sophistiquée qu'effroyablement efficace.

Ce type de fraude repose sur l’utilisation de techniques d’intelligence artificielle pour générer des voix qui semblent appartenir à des membres de la famille ou à des amis d’une manière très similaire aux voix réelles. S’ils ne sont pas détectés, ces faux votes peuvent créer de la confusion et de la désinformation, et entraîner de graves conséquences. Par conséquent, la détection de la fraude au clonage audio familial est essentielle pour maintenir l’intégrité et la sécurité. Vérifier Évaluation de l'utilisation de la technologie de reproduction sonore dans la création de contenu à grande échelle.

Comment fonctionne l’arnaque au clonage vocal de l’IA ?

Les technologies de clonage vocal peuvent créer des copies numériques incroyablement réalistes de la voix d'une personne. Cette technologie, communément appelée Deepfake audio, en utilisant des outils de clonage vocal IA comme ElevenLabs (voir l'exemple de clonage vocal IA ci-dessous). Combinée à l’IA générative et à la synthèse vocale, la voix clonée peut reproduire les émotions, les nuances, l’intonation et même la peur.

Pour référence, voici à quoi ressemble vraiment Christian Cowley, s'exprimant sur le podcast Really Practical.

Pour créer une transcription IA, seul un petit échantillon audio est nécessaire – souvent juste une minute ou moins. L’audio est souvent extrait de publications publiques sur les réseaux sociaux, ce qui rend les vloggers, les créateurs et les célébrités particulièrement vulnérables, car l’audio de leurs publications est de haute qualité et facilement disponible.

Une fois que l’escroc a cloné l’échantillon vocal, il utilise la synthèse vocale ou même la synthèse vocale en temps réel pour créer de faux appels et messages vocaux.

Après avoir accédé aux comptes de réseaux sociaux de la victime et collecté ses informations personnelles, l'escroc crée un scénario crédible. Cela peut être lié à une hospitalisation, une arrestation, un vol, un enlèvement ou tout ce qui crée de la peur et de la confusion. La voix clonée est ensuite utilisée pour manipuler le membre de la famille en lui faisant croire qu'un membre de la famille souffre d'un problème grave.

Le réalisme de la voix et des émotions, associé au choc et à l’urgence de la demande, peut vaincre le scepticisme, conduisant à des décisions hâtives de transfert d’argent ou de fourniture d’informations sensibles.

Pourquoi l’arnaque au clonage vocal de l’IA est-elle si efficace ?

Comme la plupart des escroqueries ciblant la famille et les amis, le clonage vocal IA est efficace car il exploite les connexions personnelles. La panique provoquée par la réception d’un appel de détresse d’un membre de la famille peut rapidement obscurcir le jugement, conduisant à des décisions irréfléchies. C'est la même tactique utilisée dans les escroqueries de troc, mais l'effet est accru lorsque vous entendez la voix d'un proche.

Les membres de la famille des personnes très présentes sur les réseaux sociaux ou de ceux qui voyagent sont particulièrement à risque, car leur situation fournit un contexte plausible au récit fabriqué par l'escroc. Les escrocs collectent et utilisent souvent à l'avance les données privées de leurs cibles provenant de leurs comptes publics de réseaux sociaux, ce qui rend les histoires plus convaincantes. Vérifier Comment faire face à la menace d’enlèvement virtuel et se protéger en ligne ? Reconnaître les menaces.

Principaux signes d'une arnaque au clonage vocal de l'IA

Malgré sa complexité, le clonage vocal de l’IA peut se révéler par des signes avant-coureurs spécifiques :

- Urgence: L’escroc tentera de vous convaincre que quelque chose de terrible va se produire si des mesures ne sont pas prises immédiatement.

- الحقائق : L'escroc ne connaît pas toujours toute l'histoire de votre relation avec la cible, alors faites attention aux incohérences.

- Demandes inhabituelles : Les demandes de transfert de fonds vers des comptes bancaires à l’étranger ou de paiement sur un portefeuille de cryptomonnaies sont des méthodes courantes.

Ces facteurs sont difficiles à prendre en considération face à un scénario désastreux, mais ils peuvent vous éviter de vous faire arnaquer.

Que faire si vous soupçonnez une arnaque au clonage vocal d'IA

Si vous recevez un appel ou un message vocal d’un proche en détresse, restez calme. L’escroc tentera de vous faire paniquer et de devenir émotif, car cela augmente la probabilité que vous soyez exposé à ses méthodes.

Si vous recevez un appel téléphonique

Si vous soupçonnez, ne serait-ce qu'une seconde, qu'un appel peut être une arnaque au clonage vocal, raccrochez immédiatement. Ne partagez aucune information et ne faites pas affaire avec des fraudeurs. Rappelez plutôt vos proches à un numéro connu pour confirmer l’authenticité de l’appel de détresse.

Avoir d'autres conversations avec l'escroc peut également risquer d'enregistrer et de cloner votre voix.

Si vous recevez un message vocal

Si l'escroc laisse un message vocal, enregistrez immédiatement l'audio sur votre téléphone ou votre ordinateur portable. Cet échantillon audio peut être utilisé dans un classificateur de parole IA pour déterminer s'il s'agit d'une voix humaine. Les classificateurs vocaux basés sur l'IA fonctionnent comme du matériel Détection de frappe par intelligence artificielle. Entrez simplement le fichier audio et le classificateur le marquera comme généré par l'homme ou généré par l'IA.

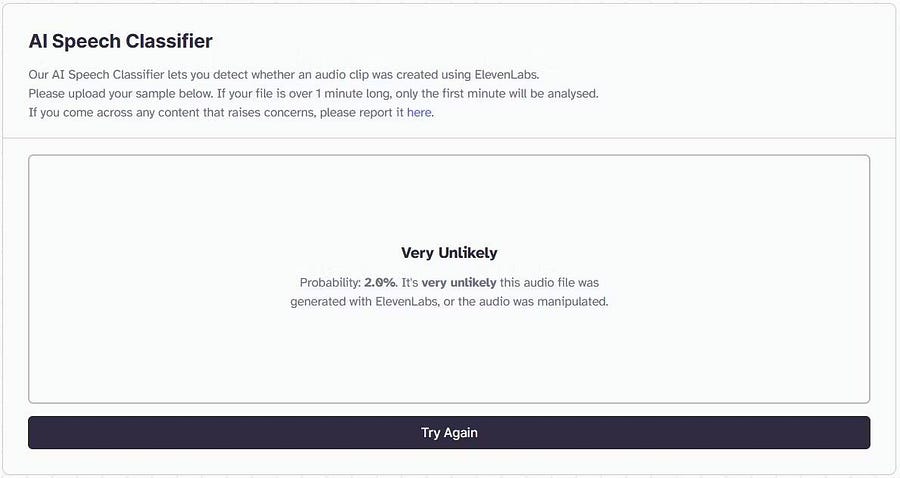

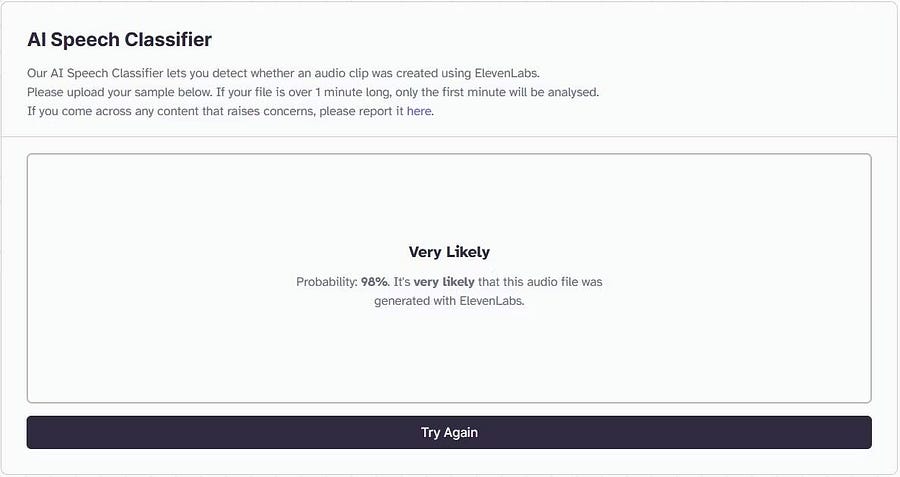

Un excellent outil pour effectuer cette vérification est ElevenLabs Speech Classifier. ElevenLabs alimente la plupart des plateformes de clonage de voix IA, c'est donc un outil idéal pour déterminer si une voix a été clonée. Voici comment l'utiliser pour identifier l'audio reproduit par l'IA :

- Aller à Classificateur de parole ElevenLabs.

- Téléchargez un exemple de message vocal et cliquez sur « Détecter la parole synthétisée ».

Dans l'exemple ci-dessous, un message de détresse a été enregistré par quelqu'un et téléchargé dans le classeur. Vous pouvez voir qu’il est signalé comme ayant 2 % de chances d’être falsifié.

Dans l’exemple suivant, le même message de détresse a été produit à l’aide d’un outil de clonage vocal d’IA. Pour l’oreille humaine, les sons sont indiscernables. Cependant, l’outil l’a évalué comme ayant 98 % de chances d’être généré par l’IA.

Bien que vous ne puissiez pas vous fier à 100 % à ce classeur, il peut confirmer vos soupçons concernant l'utilisation d'audio cloné. Vous devez également appeler votre proche sur un numéro connu pour confirmer. Vérifier Les capacités humaines ou l’intelligence artificielle sont-elles supérieures pour détecter les technologies deep fake ?.

La prévention est la meilleure défense contre les arnaques au clonage vocal de l’IA

Parfois, la meilleure défense contre les escroqueries liées à la haute technologie réside dans les solutions low-tech.

Créez un mot de passe hors ligne connu uniquement de vos proches, de votre famille et de vos amis. Si vous passez un appel dans des situations critiques, l'utilisation de ce mot de passe peut être un moyen infaillible de confirmer l'identité de l'appelant.

Enfin, garder vos informations privées hors des sites de médias sociaux est un grand pas en avant pour garantir que les fraudeurs ne puissent pas recueillir suffisamment d'informations pour construire une histoire. N'oubliez pas : si vous ne voulez pas que tout le monde le sache, il est préférable de ne pas le partager sur les réseaux sociaux. Vous pouvez voir maintenant Quelle est la valeur des données de vos comptes de réseaux sociaux sur le dark web ?