Нравится вам это или нет, но искусственный интеллект (ИИ) изменит способ мышления и взаимодействия целых сегментов нашего общества, включая Всемирную паутину.

С такими моделями, как ChatGPT, доступными для всех, у кого есть подключение к Интернету, становится все труднее отделить контент, созданный искусственным интеллектом, от оригинального, уникального контента, созданного людьми. Хорошо, что у нас есть ИИ-детекторы контента, верно? Проверять Риски написания контента ИИ и как обнаружить текст, сгенерированный ИИ.

Включают ли детекторы контента распознавание текста AI?

Детекторы контента ИИ — это специализированные инструменты, которые определяют, был ли текст написан компьютером или человеком. Если вы просто введете в Google фразу «детектор контента AI», вы увидите, что существуют десятки доступных детекторов, каждый из которых утверждает, что может надежно различать человеческий и нечеловеческий текст.

Это работает довольно просто: вы вставляете фрагмент своего текста, и инструмент сообщает вам, был ли он сгенерирован ИИ. С более технической точки зрения, используя комбинацию методов обработки естественного языка и алгоритмов машинного обучения, инструменты обнаружения контента ИИ ищут шаблоны и делают прогнозы, а также устанавливают связи на основе этого.

На бумаге это звучит великолепно, но если вы когда-либо использовали инструмент обнаружения контента ИИ, вы прекрасно знаете, что он, мягко говоря, попадает и промахивается. Часто вы замечаете написанный человеком контент как созданный ИИ или текст, сгенерированный ИИ, как созданный человеком. На самом деле, некоторые смущающе плохи в том, что они должны делать.

Насколько точны инструменты обнаружения контента ИИ?

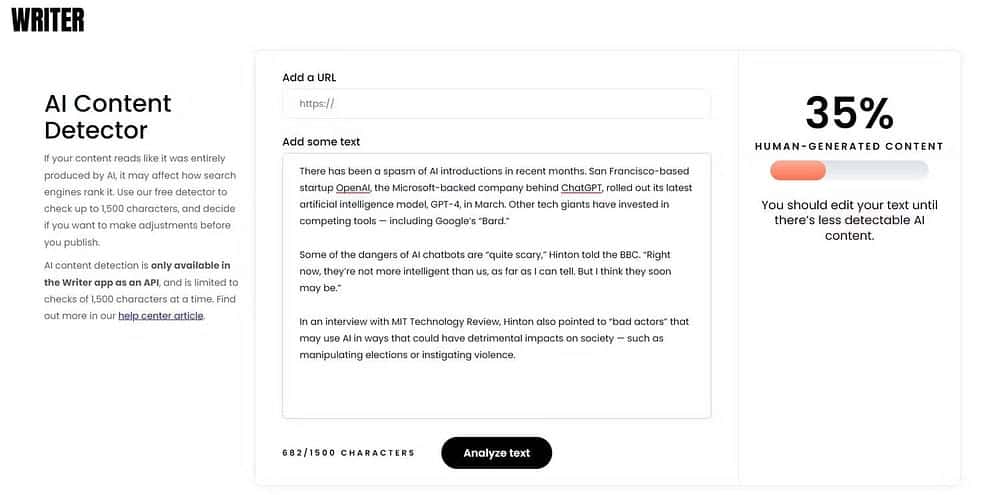

Если вы находитесь в США, первым результатом поиска Google по запросу «детектор содержания AI» будет Писатель.com (Ранее Qordoba; платформа контента AI, у которой также есть собственный детектор). Но когда вы вставляете раздел случайной статьи из Associated Press В этом инструменте утверждается, что существует очень большая вероятность того, что он был сформирован искусственным интеллектом.

Итак, вы ошибаетесь.

Справедливости ради следует отметить, что другие инструменты обнаружения контента ИИ ничем не лучше. Они не только генерируют ложные срабатывания, но и классифицируют контент ИИ как человеческий. И даже если вы этого не сделаете, достаточно внести небольшие коррективы в текст, сгенерированный ИИ, чтобы он полностью прошел.

В феврале 2023 года преподаватель Университета Вуллонгонга Армин Алимардани и доцент Университета Нового Южного Уэльса в Сиднее Эмма А. Джин» использовал ряд популярных инструментов обнаружения контента ИИ, что доказывает, что ни один из них не является надежным. Алимардани и Джейн пришли к выводу в своем анализе, который был опубликован в Беседа , что «гонка вооружений» ИИ между генераторами текста и инструментами обнаружения станет огромным вызовом в будущем, особенно для педагогов.

Но поводы для беспокойства есть не только у учителей: должны быть у всех. По мере того, как текст, сгенерированный ИИ, становится повсеместным, становится все труднее различать, что является «настоящим», а что нет, то есть определять, что написано ИИ. Это окажет значительное влияние практически на все отрасли и сферы жизни общества, даже на личные отношения. Проверять Ответственные способы использования ИИ в качестве автора или редактора контента.

Последствия искусственного интеллекта для кибербезопасности и конфиденциальности

Тот факт, что не существует надежных механизмов для определения того, было ли что-то создано чат-ботом или человеком, имеет серьезные последствия для кибербезопасности и конфиденциальности.

Злоумышленники уже используют ChatGPT для написания вредоносных программ, создания фишинговых писем, рассылки спама, создания мошеннических веб-сайтов и многого другого. И хотя есть способы защититься от этого, конечно, беспокоит отсутствие приложения, способного надежно отличить органический контент от бота.

Фейковые новости — это тоже очень большая проблема. С помощью генеративного ИИ агенты дезинформации могут масштабировать свою деятельность беспрецедентным образом. Между тем, у обычного человека нет возможности узнать, было ли то, что он читает в Интернете, создано чат-ботом или человеком. Проверять Как ИИ может помочь киберпреступникам.

GPTZero, детектор ИИ, считает, что Конституция США была написана ИИ.

Отцы-основатели опередили свое время 😂 pic.twitter.com/dsXqZOJxSz

— Барси 🐶 (@heyBarsee) 4 марта 2023

Конфиденциальность — совсем другое дело. Возьмем, к примеру, ChatGPT. Прежде чем он был запущен, ему было передано более 300 миллиардов слов. Этот контент был взят из книг, сообщений в блогах, форумов, статей и социальных сетей. Он был собран без чьего-либо согласия и, по-видимому, с полным игнорированием конфиденциальности и защиты авторских прав.

Кроме того, существует проблема ложных срабатываний. Если контент ошибочно помечен как созданный ИИ, не может ли это привести к цензуре, что в любом случае является большой проблемой? Не говоря уже об ущербе, который обвинение в использовании сгенерированного ИИ текста может нанести репутации редактора как в Интернете, так и в реальной жизни.

Если действительно идет гонка вооружений между генеративным ИИ и детекторами контента, то первый — победитель. Что еще хуже, похоже, решения нет. Все наши полуфабрикаты не работают так же хорошо, или их очень легко обмануть. Проверять Как авторы контента могут перехитрить инструменты для написания ИИ.

Как обнаружить ИИ-контент: возможные решения

То, что у нас сейчас нет реальных ответов на эту проблему, не означает, что у нас не будет доступа к ним в будущем. На самом деле уже есть несколько серьезных предложений, которые могли бы сработать. Водяной знак является одним из них.

Когда дело доходит до ИИ и моделей глубокого языка, водяные знаки означают встраивание своего рода секретного кода в сгенерированный ИИ текст (например, стиль слов и стиль пунктуации). Такой водяной знак будет невидим невооруженным глазом и, следовательно, его невозможно будет удалить, но специализированные приложения смогут его обнаружить.

Ведь в 2022 году он разработал Исследователи Мэрилендского университета Новый метод водяных знаков для искусственных нейронных сетей. Ведущий исследователь Том Гольдштейн сказал в то время, что его команда смогла «математически доказать», что водяной знак нельзя удалить полностью.

Прямо сейчас обычный человек мог полагаться на свои инстинкты и здравый смысл. Если что-то в содержании, которое вы читаете, — если оно кажется неестественным, повторяющимся, нетворческим или простым — возможно, оно было сгенерировано ботом. Конечно, вам также следует проверять любую информацию, которую вы видите в Интернете, перепроверять источник и держаться подальше от подозрительных веб-сайтов. Проверять Кому принадлежат авторские права на творения ИИ? Как действует авторское право на эти произведения искусства?

Революция искусственного интеллекта продолжается

Некоторые утверждают, что Пятая промышленная революция уже наступила, и искусственный интеллект занимает центральное место в том, что описывается как конвергенция цифрового и физического. Независимо от того, так это на самом деле или нет, все, что мы можем сделать, это приспособиться.

Хорошая новость заключается в том, что индустрия кибербезопасности адаптируется к этой новой реальности, внедряя новые защитные стратегии с искусственным интеллектом и машинным обучением на переднем крае. Вы можете просмотреть сейчас Некоторые мифы о кибербезопасности, которые делают вас более уязвимыми для атак.