Il ne fait aucun doute que NVIDIA continue de dominer l'espace informatique parallèle avec ses différentes séries de cartes graphiques populaires. Mais avec les accélérateurs Instinct AI d'AMD alimentant deux de ses derniers et plus grands supercalculateurs (Frontier et El Capitan) et le soutien croissant de la communauté pour la plate-forme open source ROCm, NVIDIA a peut-être trouvé son plus grand concurrent à ce jour.

Alors, que sont exactement les accélérateurs d'IA d'AMD Instinct ? Qu'est-ce qui le rend puissant et comment se compare-t-il aux GPU Tensor de NVIDIA ? Vérifier Quelle est la différence entre une carte mère AMD et un processeur Intel ?

Qu'est-ce qu'AMD Instinct ?

Les GPU AMD Instinct sont du matériel d'entreprise utilisé pour le calcul haute performance (HPC) et le traitement accéléré par l'IA. Contrairement aux GPU classiques grand public, les GPU Instinct sont dédiés à une meilleure gestion de l'apprentissage de l'IA, du traitement du Big Data et d'autres tâches hautes performances grâce à des innovations logicielles et matérielles.

La série Instinct d'AMD a été utilisée pour alimenter le premier supercalculateur à briser la barrière informatique Exascale, fonctionnant à 1.1 EFLOP en opérations de double précision par seconde. Des superordinateurs contenant des GPU Instinct sont actuellement utilisés pour rechercher des thérapies contre le cancer, l'énergie durable et le changement climatique.

Le calcul haute performance (HPC) est devenu un élément essentiel de notre monde moderne qui effectue des simulations et des calculs complexes nécessaires à la recherche scientifique, à l'ingénierie, à la sécurité et à d'autres domaines. Cependant, à mesure que la demande de HPC a augmenté, souvent dans les supercalculateurs et les grands centres de données, son impact environnemental s'inquiète également. Au cours des dernières années, l'accent a été mis sur la durabilité des centres de données compte tenu des implications pour le coût total de possession et les préoccupations climatiques.

Comment les GPU Instinct accélèrent l'intelligence et les technologies de calcul hautes performances

Pour que les serveurs principaux et supercalculateurs les plus puissants au monde puissent atteindre un traitement de niveau Exascale, les accélérateurs AMD Instinct devaient être équipés de nombreuses améliorations et innovations technologiques.

Discutons de certaines des technologies nouvelles et mises à jour utilisées dans les GPU AMD Instinct.

1. Architecture technologique (ADNC)

Les accélérateurs AMD Instinct modernes (à commencer par le MI100) ont utilisé l'architecture CDNA de l'entreprise.

CDNA se concentre principalement sur des fonctionnalités telles que le traitement parallèle, la hiérarchie de la mémoire et l'amélioration des performances de calcul grâce à sa technologie Matrix Core. Même le HPC et l'IA ou l'apprentissage automatique exécutés sur des serveurs individuels peuvent être pris en charge par CDNA, ainsi que par les supercalculateurs Exascale.

La technologie AMD Matrix Core accélère l'apprentissage de l'IA en prenant en charge les opérations de précision mixte. La capacité de calculer à différentes résolutions permet aux GPU Instinct de calculer efficacement les opérations matricielles en fonction du niveau de précision souhaité.

Les formats de résolution de calcul les plus populaires incluent FP64, FP32, FP16, BF16 et INT8. FP signifie Floating Point, BF signifie Brain Floating Point et INT signifie Integer. Plus le nombre correspondant au format est élevé, plus la précision du calcul est élevée. Le fonctionnement en 64 bits est connu sous le nom de double précision. Avec 32 bits, c'est de la simple précision, avec 16 bits, c'est de la demi-précision, etc.

Étant donné qu'une grande partie de la formation de modèles d'apprentissage en profondeur ne nécessite pas beaucoup de précision, la capacité de calculer des opérations matricielles avec la moitié ou même un quart de la précision de l'inférence réduit considérablement la charge de travail, accélérant ainsi l'apprentissage de l'IA. Vérifier Mon IA depuis Snapchat ou ChatGPT : laquelle utiliser ?

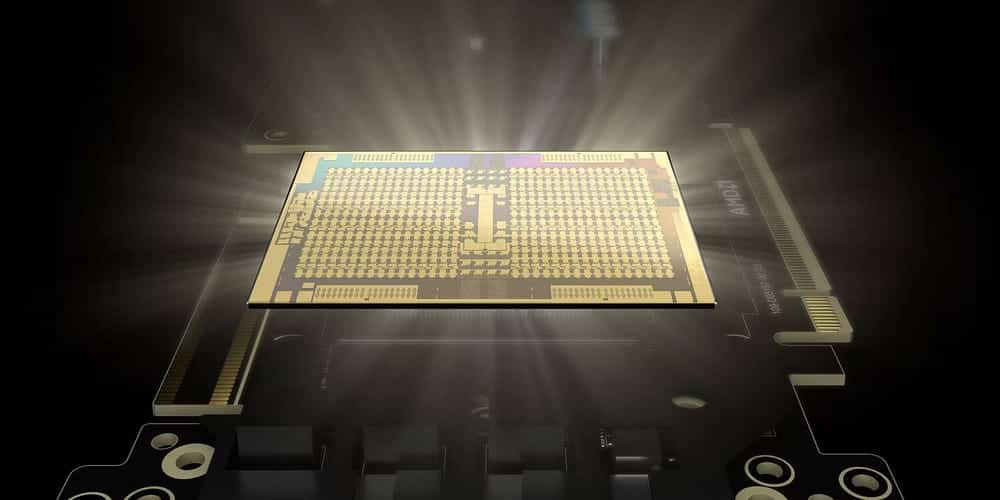

2. Mémoire à bande passante élevée (HBM)

Chaque accélérateur AMD Instinct est livré avec jusqu'à 880 cœurs Matrix. Avec les processeurs Matrix Core d'AMD capables de 383 TFLOP de calculs d'une demi-minute, une mémoire ultra-rapide est essentielle. La dernière offre Instinct d'AMD est livrée avec une mémoire à bande passante élevée (HBM) au lieu de la RAM DDR4 ou DDR5 habituelle.

Contrairement à la mémoire traditionnelle, HBM utilise ce que l'on appelle une architecture de pile 3D. Ce type d'architecture fait référence à l'approche de conception où les modules DRAM sont empilés verticalement les uns sur les autres. Cela permet aux modèles d'être empilés sur l'axe vertical et horizontal, d'où le terme d'empilement 3D.

Avec cette technologie d'empilement 3D, HBM peut avoir des capacités de mémoire physique de quelques centaines de gigaoctets par module, tandis que DRR5 ne peut faire que des dizaines de gigaoctets par module. Outre la capacité, HBM est également connu pour avoir des performances de débit plus élevées et une meilleure efficacité énergétique que la mémoire DDR normale.

3. Tissu infini

Une autre innovation intégrée aux GPU Instinct est la technologie Infinity Fabric d'AMD. Infinity Fabric est un type de système de threading qui connecte les CPU et les GPU de manière dynamique et intelligente. Cela permet aux composants de communiquer efficacement entre eux.

Avec Infinity Fabric, au lieu de connecter des composants à un bus ordinaire, les composants sont désormais connectés dans une configuration de type réseau où la bande passante peut atteindre plusieurs centaines de gigaoctets par seconde.

Outre l'interconnexion de type réseau, Infinity Fabric utilise également des capteurs intégrés dans chaque modèle pour contrôler dynamiquement la fréquence, les taux de transfert de données et d'autres comportements adaptatifs, améliorant ainsi les performances et réduisant la latence.

4. Plateforme de développement ROCm

CUDA (Unified Computing Machine Architecture) de NVIDIA est la plate-forme de développement la plus largement utilisée pour la formation de modèles d'IA. Le problème avec CUDA est qu'il ne fonctionne qu'avec les GPU NVIDIA. C'est l'une des principales raisons pour lesquelles NVIDIA détient la grande majorité des parts de marché des accélérateurs HPC et AI.

AMD souhaitant une plus grande part du marché du HPC et de l'IA, ils ont dû développer leur propre plate-forme, ROCm (Radeon Open Compute). ROCm est une plate-forme logicielle open source qui permet d'utiliser les GPU Instinct comme accélérateurs d'IA.

Bien qu'il ne fasse pas nécessairement partie du matériel Instinct, le ROCm est essentiel pour la survie de la gamme de GPU Instinct. Avec ROCm, les développeurs et les chercheurs disposent d'outils ROCm, du compilateur, de pilotes de noyau, d'un ensemble complet de bibliothèques et d'un accès à des frameworks tels que TensorFlow et PyTorch pour développer avec leur langage de programmation AI préféré.

Comment les accélérateurs d'IA d'AMD Instinct se comparent-ils à leurs homologues Radeon ?

AMD propose sa gamme Instinct de GPU d'entreprise et de GPU Radeon pour le grand public. Comme indiqué précédemment, le processeur Instinct utilise l'architecture CDNA d'AMD, HBM et Infinity Fabric pour l'interconnexion. À l'inverse, les processeurs Radeon utilisent l'architecture RDNA d'AMD, la mémoire DDR6 et Infinity Cache.

Bien que la série Radeon soit des accélérateurs d'IA moins performants, ils contiennent toujours un ou deux cœurs d'accélération d'IA par unité de calcul. Le dernier GPU Radeon RX7900 XT dispose de deux cœurs d'accélération AI par unité de calcul, permettant 103 TFLOP de demi-résolution maximale et 52 TFLOP de précision à un seul pic.

Alors que la série de GPU Instinct est mieux adaptée aux LLM et aux HPC, les accélérateurs Radeon AI peuvent être utilisés pour le réglage de modèle pré-formé, l'inférence et les tâches gourmandes en graphiques.

Comparaison entre AMD Instinct et NVIDIA Tensor

Selon un sondage TrendForce Nvida détient environ 80 % de la part de marché des GPU pour serveurs, tandis qu'AMD ne détient que les 20 % restants. Ce succès retentissant de NVIDIA est dû au fait qu'il s'agit d'une entreprise spécialisée dans la conception et l'assemblage d'unités de traitement graphique. Cela leur permet de créer des GPU plus performants que les autres offres.

Comparons l'Instinct MI205X d'AMD et le H100SXM5 de NVIDIA en utilisant les spécifications de Site officiel d'AMD et fiche technique NVIDIA Sa propre:

| Type de processeur graphique | FP64 (TFLOP) | FP32 (TFLOP) | FP16 (TFLOP) | INT8 (TFLOP) |

|---|---|---|---|---|

| AMD Instinct MI250X | 30.0 | 60.0 | 1000 | 2000 |

| NVIDIA H100SXMS | 47.9 | 95.7 | 383.2 | 383 |

Comme on peut le voir dans le tableau, le MI250X d'AMD est plus performant pour les calculs en double précision et en demi-précision, tandis que le H100SXMS de NVIDIA est bien meilleur pour les calculs matriciels en demi-précision et en quart de précision. Cela rend le MI250X d'AMD plus adapté au HPC, tandis que le H100SXMS de NVIDIA avec apprentissage et raisonnement de l'IA. Vérifier Comparaison des cartes graphiques AMD et NVIDIA sous Linux: que devez-vous utiliser?

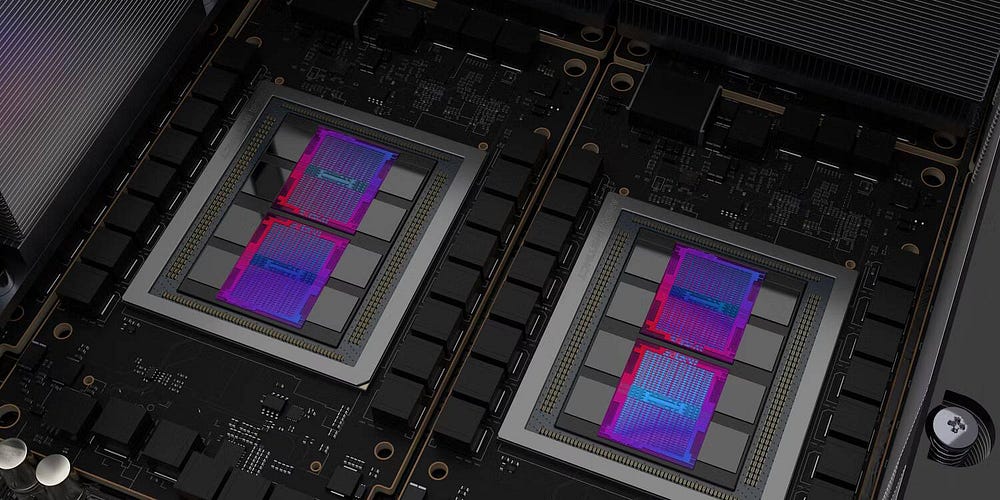

L'avenir des processeurs AMD Instinct

Bien que la dernière offre d'AMD, le MI250X, soit conçue pour le HPC, le prochain MI300 est davantage orienté vers la formation à l'IA. Cet accélérateur AI est déclaré être un APU, combinant GPU et CPU dans un seul package. Cela permet au GPU MI300 d'utiliser l'architecture APU de mémoire unifiée CNDA3, où le GPU et le CPU n'utiliseront qu'une seule mémoire, augmentant l'efficacité et réduisant le prix.

Bien qu'AMD ne concurrence pas NVIDIA sur le marché des accélérateurs d'IA aujourd'hui, une fois que le MI300 sera lancé et que le ROCm s'améliorera, la série Instinct d'AMD pourrait être assez bonne pour arracher une part importante du marché des accélérateurs d'IA à NVIDIA. Vous pouvez voir maintenant Quelle est la différence entre Nvidia GTX et Nvidia RTX ?