No hay duda de que NVIDIA continúa dominando el espacio de la computación paralela con su popular y diversa serie de tarjetas gráficas. Pero con los aceleradores Instinct AI de AMD que impulsan dos de sus últimas y mejores supercomputadoras (Frontier y El Capitan) y el creciente apoyo de la comunidad para la plataforma ROCm de código abierto, es posible que NVIDIA haya encontrado su mayor competidor hasta el momento.

Entonces, ¿qué son exactamente los aceleradores de IA de AMD Instinct? ¿Qué lo hace poderoso y cómo se compara con las GPU Tensor de NVIDIA? Verificar ¿Cuál es la diferencia entre una placa base AMD y un procesador Intel?

¿Qué es el instinto de AMD?

Las GPU AMD Instinct son hardware empresarial que se utiliza para la informática de alto rendimiento (HPC) y el procesamiento acelerado por IA. A diferencia de las GPU regulares de nivel de consumidor, las GPU Instinct están dedicadas a manejar mejor el aprendizaje de IA, el procesamiento de big data y otras tareas de alto rendimiento a través de innovaciones de software y hardware.

La serie Instinct de AMD se utilizó para impulsar la primera supercomputadora que rompió la barrera informática de Exascale, funcionando a 1.1 EFLOP en operaciones de doble precisión por segundo. Las supercomputadoras que contienen GPU Instinct se utilizan actualmente para investigar terapias contra el cáncer, energía sostenible y cambio climático.

La informática de alto rendimiento (HPC) se ha convertido en una parte esencial de nuestro mundo moderno que realiza simulaciones y cálculos complejos necesarios para la investigación científica, la ingeniería, la seguridad y otros campos. Sin embargo, a medida que aumenta la demanda de HPC, a menudo en supercomputadoras y grandes centros de datos, también aumenta la preocupación por su impacto ambiental. En los últimos años, ha habido un mayor enfoque en la sostenibilidad del centro de datos dadas las implicaciones para el costo total de propiedad y las preocupaciones climáticas.

Cómo las GPU Instinct aceleran la inteligencia y las tecnologías informáticas de alto rendimiento

Para que los servidores principales y las supercomputadoras más poderosos del mundo lograran un procesamiento de nivel Exascale, los aceleradores AMD Instinct tuvieron que estar equipados con muchas mejoras e innovaciones tecnológicas.

Analicemos algunas de las tecnologías nuevas y actualizadas que se utilizan en las GPU AMD Instinct.

1. Arquitectura tecnológica (CDNA)

Los aceleradores AMD Instinct modernos (empezando por el MI100) han utilizado la arquitectura CDNA de la empresa.

CDNA se enfoca principalmente en funciones como procesamiento paralelo, jerarquía de memoria y rendimiento computacional mejorado a través de su tecnología Matrix Core. Incluso la HPC y la IA o el aprendizaje automático que se ejecutan en servidores individuales pueden ser compatibles con CDNA, así como con las supercomputadoras Exascale.

La tecnología AMD Matrix Core acelera el aprendizaje de IA al admitir operaciones de precisión mixta. La capacidad de computar a diferentes resoluciones permite que las GPU Instinct calculen de manera eficiente las operaciones matriciales en función del nivel de precisión deseado.

Los formatos de resolución de cómputo más populares incluyen FP64, FP32, FP16, BF16 e INT8. FP significa punto flotante, BF significa punto flotante cerebral e INT significa entero. Cuanto mayor sea el número correspondiente al formato, mayor será la precisión del cálculo. La operación a 64 bits se conoce como doble precisión. Con 32 bits es de precisión simple, con 16 bits es de precisión media, y así sucesivamente.

Dado que una gran parte del entrenamiento de modelos de aprendizaje profundo no requiere mucha precisión, tener la capacidad de calcular operaciones matriciales con la mitad o incluso una cuarta parte de la precisión de la inferencia reduce en gran medida la carga de trabajo, lo que acelera el aprendizaje de la IA. Verificar Mi IA de Snapchat o ChatGPT: ¿Cuál debería usar?

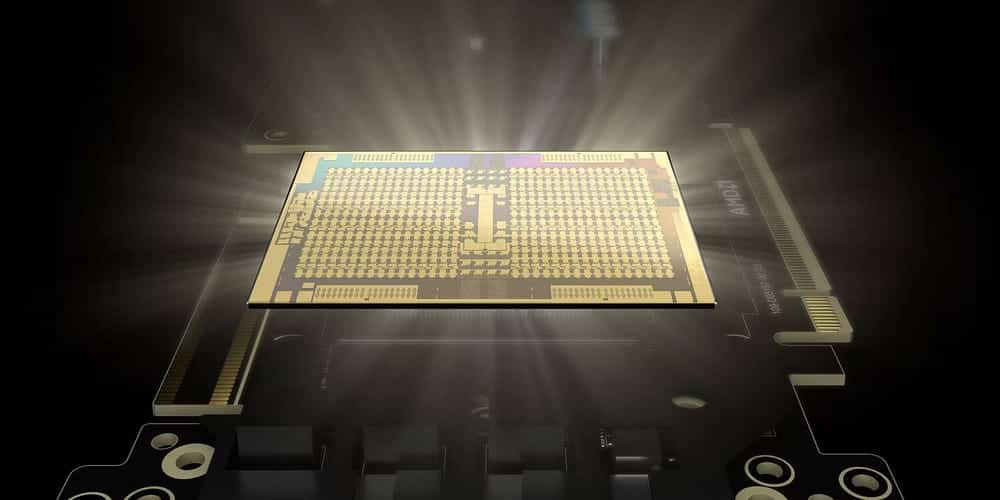

2. Memoria de alto ancho de banda (HBM)

Cada acelerador AMD Instinct viene con hasta 880 Matrix Cores. Con los procesadores Matrix Core de AMD capaces de 383 TFLOP de cálculos de medio minuto, la memoria ultrarrápida es esencial. La última oferta Instinct de AMD viene con memoria de alto ancho de banda (HBM) en lugar de la memoria RAM DDR4 o DDR5 habitual.

A diferencia de la memoria tradicional, HBM utiliza lo que se conoce como arquitectura de pila 3D. Este tipo de arquitectura se refiere al enfoque de diseño en el que los módulos DRAM se apilan verticalmente uno encima del otro. Esto permite que los modelos se apilen tanto en el eje vertical como en el horizontal, de ahí el término apilamiento 3D.

Con esta tecnología de apilamiento 3D, HBM puede tener capacidades de memoria física de unos pocos cientos de gigabytes por módulo, mientras que DRR5 solo puede hacer hasta decenas de gigabytes por módulo. Aparte de la capacidad, también se sabe que HBM tiene un mayor rendimiento y una mejor eficiencia energética que la memoria DDR normal.

3. Tela infinita

Otra innovación integrada en las GPU Instinct es la tecnología Infinity Fabric de AMD. Infinity Fabric es un tipo de sistema de subprocesos que conecta CPU y GPU de forma dinámica e inteligente. Esto permite que los componentes se comuniquen de manera eficiente entre sí.

Con Infinity Fabric, en lugar de conectar componentes a un bus regular, los componentes ahora están conectados en una configuración similar a una red donde el ancho de banda puede alcanzar varios cientos de gigabytes por segundo.

Además de la interconexión similar a una red, Infinity Fabric también utiliza sensores integrados en cada modelo para controlar dinámicamente la frecuencia, las tasas de transferencia de datos y otros comportamientos adaptativos, mejorando el rendimiento y reduciendo la latencia.

4. Plataforma de desarrollo ROCm

CUDA (Arquitectura de máquina de computación unificada) de NVIDIA es la plataforma de desarrollo más utilizada para entrenar modelos de IA. El problema con CUDA es que solo funciona con GPU NVIDIA. Esta es una de las principales razones por las que NVIDIA tiene la gran mayoría de las cuotas de mercado de aceleradores de IA y HPC.

Dado que AMD deseaba una porción más grande del mercado de HPC e IA, tuvo que desarrollar su propia plataforma, ROCm (Radeon Open Compute). ROCm es una plataforma de software de código abierto que permite que las GPU Instinct se utilicen como aceleradores de IA.

Aunque no es necesariamente parte del hardware Instinct, ROCm es clave cuando se trata de la supervivencia de la línea de GPU Instinct. Con ROCm, los desarrolladores e investigadores obtienen herramientas de ROCm, el compilador, controladores de kernel, un conjunto completo de bibliotecas y acceso a marcos como TensorFlow y PyTorch para desarrollar con su lenguaje de programación de IA favorito.

¿Cómo se comparan los aceleradores de IA de AMD Instinct con sus homólogos de Radeon?

AMD ofrece su línea Instinct de GPU empresariales y GPU Radeon para el consumidor general. Como se mencionó anteriormente, el procesador Instinct utiliza la arquitectura CDNA de AMD, HBM e Infinity Fabric para la interconexión. Por el contrario, los procesadores Radeon utilizan la arquitectura RDNA de AMD, la memoria DDR6 e Infinity Cache.

Aunque la serie Radeon son aceleradores de IA con menos capacidad, aún incluyen uno o dos núcleos de aceleración de IA por unidad de cómputo. La última GPU Radeon RX7900 XT tiene dos núcleos de aceleración de IA por unidad de cómputo, lo que permite 103 TFLOP de la mitad de la resolución máxima y 52 TFLOP de precisión de pico único.

Si bien la serie de GPU Instinct es más adecuada para LLM y HPC, los aceleradores de IA de Radeon se pueden usar para el ajuste de modelos preentrenados, la inferencia y las tareas con uso intensivo de gráficos.

Comparación de AMD Instinct y NVIDIA Tensor

Según una encuesta TrendForce Nvida tiene alrededor del 80 % de la cuota de mercado de las GPU para servidores, mientras que AMD tiene solo el 20 % restante. Este éxito arrollador de NVIDIA se debe a que es una empresa que se especializa en diseñar y ensamblar unidades de procesamiento de gráficos. Esto les permite construir GPU de mejor rendimiento que otras ofertas.

Comparemos el Instinct MI205X de AMD y el H100SXM5 de NVIDIA utilizando las especificaciones de Sitio web oficial de AMD y hoja de datos de NVIDIA Su propio:

| tipo de GPU | FP64 (TFLOP) | FP32 (TFLOP) | FP16 (TFLOP) | INT8 (TFLOP) |

|---|---|---|---|---|

| AMD instinto MI250X | 30.0 | 60.0 | 1000 | 2000 |

| NVIDIA H100SXMS | 47.9 | 95.7 | 383.2 | 383 |

Como se puede ver en la tabla, el MI250X de AMD se desempeña mejor en cálculos de precisión doble y media precisión, mientras que el H100SXMS de NVIDIA es mucho mejor en cálculos matriciales de precisión media y cuarta. Esto hace que el MI250X de AMD sea más adecuado para HPC, mientras que el H100SXMS de NVIDIA con aprendizaje y razonamiento de IA. Verificar Comparación de tarjetas gráficas AMD vs NVIDIA en Linux: ¿Cuál debería usar?

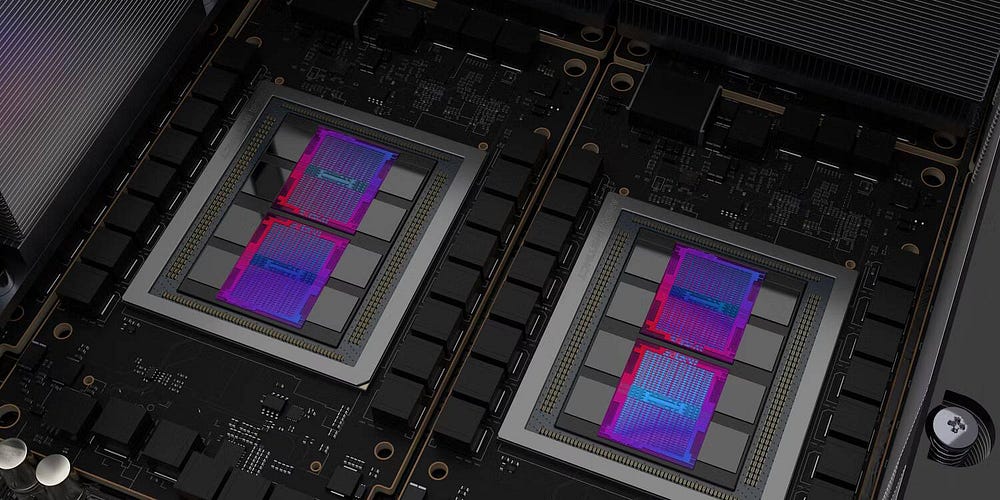

El futuro de los procesadores AMD Instinct

Aunque la última oferta de AMD, el MI250X, está diseñado para HPC, el próximo MI300 está más orientado al entrenamiento de IA. Se declara que este acelerador de IA es una APU, que combina GPU y CPU en un solo paquete. Esto permite que la GPU MI300 use la arquitectura APU de memoria unificada CNDA3, donde la GPU y la CPU usarán solo una memoria, lo que aumenta la eficiencia y reduce el precio.

Aunque AMD no competirá con NVIDIA en el mercado de aceleradores de IA hoy, una vez que se lance MI300 y mejore ROCm, la serie Instinct de AMD puede ser lo suficientemente buena como para arrebatarle una parte significativa del mercado de aceleradores de IA a NVIDIA. Puedes ver ahora ¿Cuál es la diferencia entre Nvidia GTX y Nvidia RTX?