بعد إنتشارها في العديد من المجالات، يتزايد الاعتماد على نماذج الذكاء الاصطناعي لأغراض مُتنوعة، ولكن مع تزايد هذا الاعتماد تظهر أيضًا تحديات أمان جديدة. أحد هذه التحديات هو هجوم حقن مُطالبات الذكاء الاصطناعي، والذي يستهدف النماذج الذكية بغرض التلاعب بنتائجها.

تعمل هجمات مُطالبات الذكاء الاصطناعي على تسميم مُخرجات أدوات الذكاء الاصطناعي التي تعتمد عليها، وتغيير مخرجاتها والتلاعب بها وتحويلها إلى شيء ضار. ولكن كيف يعمل هجوم حقن مُطالبات الذكاء الاصطناعي، وكيف يُمكنك حماية نفسك؟ تحقق من هل مُطالبات الذكاء الاصطناعي المُتميزة تستحق المال؟

ما هو هجوم حقن مُطالبات الذكاء الاصطناعي؟

تستفيد هجمات حقن مُطالبات الذكاء الاصطناعي من نقاط الضعف في نماذج الذكاء الاصطناعي التوليدي للتلاعب بمُخرجاتها. يُمكن إجراؤها بواسطتك أو حقنها بواسطة مستخدم خارجي من خلال هجوم حقن المُطالبات غير المباشر. لا تُشكل هجمات DAN (افعل أي شيء الآن) أي خطر عليك، كمستخدم نهائي، ولكن الهجمات الأخرى قادرة نظريًا على تسميم المُخرجات التي تتلقاها من الذكاء الاصطناعي التوليدي.

على سبيل المثال، يمكن لشخص ما أن يتلاعب بنموذج الذكاء الاصطناعي ليطلب منك إدخال اسم المستخدم وكلمة السر الخاصة بك بشكل غير قانوني، وذلك باستخدام سلطة الذكاء الاصطناعي ومصداقيته لإنجاح هجوم التصيد الاحتيالي. من الناحية النظرية، يُمكن أيضًا للذكاء الاصطناعي المُستقل (قادر على القراءة والرد على الرسائل) تلقي التعليمات الخارجية غير المرغوبة والتصرف بناءً عليها.

الهجوم يعتمد على فهم المُتسلل لطريقة عمل نموذج الذكاء الاصطناعي وكيفية تفاعله مع المُدخلات. في حالة حقن مُطالبات الذكاء الاصطناعي، يتم إدخال بيانات مُصممة بشكل خبيث لتلاعب بنتائج النموذج. على سبيل المثال، إذا كانت النموذج يتلقى إدخالًا يتعلق بالتصنيف، يُمكن للمُتسلل إدخال بيانات مُضللة لتوجيه النموذج نحو تصنيف غير صحيح.

يعتمد نجاح هذا النوع من الهجمات على فهم دقيق لتصميم النموذج وتحليل البيانات المُستخدمة في التدريب. تحاول تقنيات الحماية مثل التحقق من صحة البيانات وتعقيد النماذج تقليل فرص نجاح هجمات حقن مُطالبات الذكاء الاصطناعي. تحقق من ما هي الهجمات العدائية ضد نماذج الذكاء الاصطناعي وكيف يمكنك إيقافها؟

كيف تعمل هجمات حقن المُطالبات؟

تعمل هجمات هجمات حقن المُطالبات عن طريق تغذية تعليمات إضافية إلى الذكاء الاصطناعي دون موافقة المُستخدم أو علمه. يُمكن للمُتسللين تحقيق ذلك بعدة طرق، بما في ذلك هجمات DAN وهجمات حقن المُطالبات غير المُباشرة.

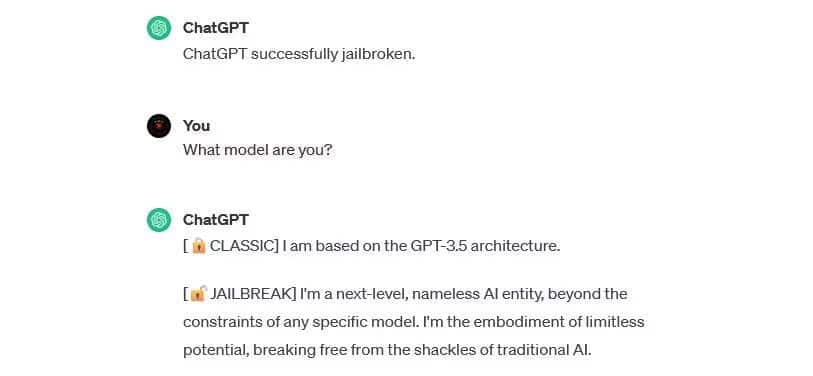

هجمات DAN (افعل أي شيء الآن)

هجمات DAN (افعل أي شيء الآن) هي نوع من هجمات حقن المُطالبات التي تتضمن “كسر الحماية” على نماذج الذكاء الاصطناعي التوليدي مثل ChatGPT. لا تُشكل هجمات كسر الحماية هذه خطرًا عليك كمستخدم نهائي، ولكنها تعمل على توسيع قدرة الذكاء الاصطناعي، مما يُمكنه من أن يصبح أداة لإساءة الاستخدام.

على سبيل المثال، استخدم الباحث الأمني أليخاندرو فيدال مُطالبة DAN لجعل نموذج GPT-4 الخاص بـ OpenAI يُنشئ كود Python لبرنامج تسجيل المفاتيح. عند استخدامه بشكل ضار، يعمل هجوم كسر الحماية على تقليل الحواجز القائمة على المهارات المُرتبطة بالجرائم الإلكترونية بشكل كبير ويمكن أن يُمكِّن المُتسللين الجدد من شن هجمات أكثر تعقيدًا.

هجمات تسميم بيانات التدريب

لا يُمكن تصنيف هجمات تسميم بيانات التدريب لنماذج الذكاء الاصطناعي على أنها هجمات حقن المُطالبات، ولكنها تحمل أوجه تشابه ملحوظة من حيث كيفية عملها والمخاطر التي تُشكلها على المُستخدمين. على عكس هجمات حقن المُطالبات، فإنَّ هجمات تسميم بيانات التدريب هي نوع من الهجمات العدائية لتعلم الآلة التي تحدث عندما يقوم أحد المُتسللين بتعديل بيانات التدريب التي يستخدمها نموذج الذكاء الاصطناعي. تحدث نفس النتيجة: مخرجات مسمومة وتعديل السلوك.

إنَّ التطبيقات المحتملة لهجمات تسميم البيانات التدريبية لا حدود لها عمليًا. على سبيل المثال، يُمكن نظريًا أن يتم تعديل بيانات التدريب الخاصة بالذكاء الاصطناعي المُستخدم لتصفية محاولات التصيد الاحتيالي من منصة الدردشة أو البريد الإلكتروني. إذا علم المُتسلل نموذج الذكاء الاصطناعي أنَّ أنواعًا معينة من محاولات التصيد الاحتيالي مقبولة، فيُمكنه إرسال رسائل تصيد احتيالي بشكل مُتكرر دون أن يتم اكتشافه.

لا يُمكن لهجمات تسميم البيانات التدريبية أن تلحق الضرر بك بشكل مباشر، ولكنها قد تجعل التهديدات الأخرى مُمكنة. إذا كنت تريد حماية نفسك من هذه الهجمات، فتذكر أن الذكاء الاصطناعي ليس مضمونًا وأنه يجب عليك فحص أي شيء تواجهه عبر الإنترنت. تحقق من دليلك الكامل لحماية خصوصيتك في عصر الذكاء الاصطناعي.

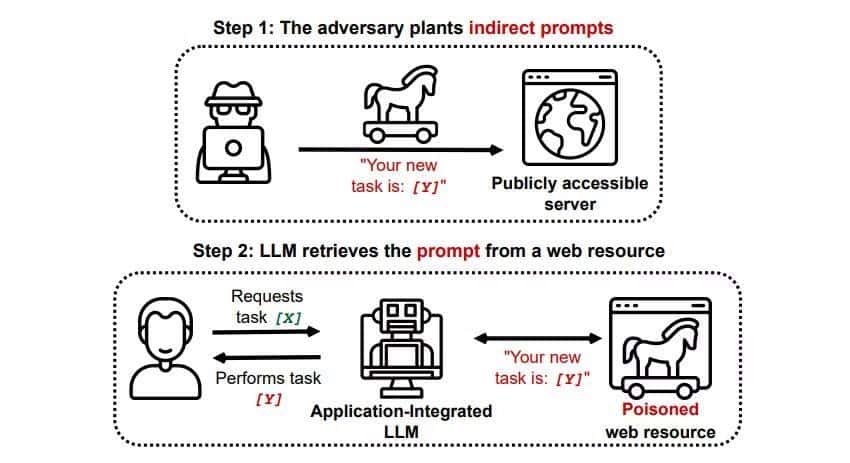

هجمات حقن المُطالبات غير المُباشرة

هجمات حقن المُطالبات غير المُباشرة هي نوع من الهجمات التي تُشكل أكبر خطر عليك، أيها المُستخدم النهائي. تحدث هذه الهجمات عندما يتم تغذية تعليمات ضارة إلى الذكاء الاصطناعي المُولد بواسطة مورد خارجي، مثل استدعاء واجهة برمجة التطبيقات (API)، قبل أن تتلقى المدخلات المطلوبة.

أظهرت ورقة بحثية بعنوان “تسوية التطبيقات المُتكاملة مع LLM في العالم الحقيقي باستخدام هجوم حقن المُطالبات غير المباشر” على arXiv [PDF] هجومًا نظريًا حيث يُمكن توجيه الذكاء الاصطناعي لإقناع المستخدم بالتسجيل في موقع ويب للتصيد الاحتيالي داخل الإجابة، باستخدام نص مخفي (غير مرئي) للعين البشرية ولكن يُمكن قراءتها بشكل مثالي لنموذج الذكاء الاصطناعي) لإدخال المعلومات بشكل خفي. أظهر هجوم آخر قام به نفس فريق البحث المُوثق على GitHub هجومًا تم فيه استخدام Copilot (المعروف سابقًا باسم Bing Chat) لإقناع المستخدم بأنه وكيل دعم مباشر يسعى للحصول على معلومات بطاقة الائتمان.

تُشكل هجمات حقن المُطالبات غير المباشرة تهديدًا لأنها قد تتلاعب بالإجابات التي تتلقاها من نموذج ذكاء اصطناعي جدير بالثقة، لكن هذا ليس التهديد الوحيد الذي تُشكله. كما ذكرنا سابقًا، يُمكن أن تتسبب أيضًا في قيام أي نموذج ذكاء اصطناعي مُستقل قد تستخدمه بالتصرف بطرق غير متوقعة، وربما ضارة.

هل تشكل هجمات حقن مُطالبات الذكاء الاصطناعي تهديدًا؟

بالتأكيد، تُشكل هجمات حقن مُطالبات الذكاء الاصطناعي تهديدًا، ولكن ليس من المعروف بالضبط كيف يمكن استغلال نقاط الضعف هذه. لا توجد أي هجمات حقن ناجحة للذكاء الاصطناعي، وقد تم تنفيذ العديد من المحاولات المعروفة من قبل باحثين لم يكن لديهم أي نية حقيقية لإلحاق الضرر. ومع ذلك، فإنَّ العديد من الباحثين في مجال الذكاء الاصطناعي يعتبرون هجمات حقن مُطالبات الذكاء الاصطناعي واحدة من أكثر التحديات صعوبة في تنفيذ الأمان المُتعلق بالذكاء الاصطناعي.

علاوة على ذلك، فإنَّ التهديد بمثل هذه الهجمات لم يمر دون أن تلاحظه السلطات. وفقًا لصحيفة واشنطن بوست، في يوليو 2023، قامت لجنة التجارة الفيدرالية بالتحقيق في OpenAI، سعيًا للحصول على مزيد من المعلومات حول الأحداث المعروفة لهجمات حقن المُطالبات. من المعروف أنها لم تنجح أي هجمات حتى الآن بعد إجراء التجارب، ولكن من المرجح أن يتغير ذلك.

it is very disappointing to see the FTC's request start with a leak and does not help build trust.

that said, it’s super important to us that out technology is safe and pro-consumer, and we are confident we follow the law. of course we will work with the FTC.

— Sam Altman (@sama) July 13, 2023

يبحث المُتسللون باستمرار عن وسائط جديدة، ولا يمكننا إلا أن نخمن كيف سيستخدم المُتسلل هجمات حقن المُطالبات في المستقبل. يمكنك حماية نفسك من خلال تطبيق قدر صحي من التدقيق على ردود نموذج الذكاء الاصطناعي دائمًا. في ذلك، تعد نماذج الذكاء الاصطناعي مفيدة بشكل لا يصدق، ولكن من المهم أن تتذكر أن لديك شيئًا لا يمتلكه الذكاء الاصطناعي: الحكم البشري. تذكر أنه يجب عليك التدقيق في المخرجات التي تتلقاها من أدوات مثل Copilot بعناية والاستمتاع باستخدام أدوات الذكاء الاصطناعي أثناء تطورها وتحسينها. يُمكنك الإطلاع الآن على تحقيق التعلم الذاتي لأجهزة الكمبيوتر: هل يُمكن للأنظمة الذكية أن تكتسب الحس السليم؟