Подготовить Файл robots.txt. Один из самых простых файлов на веб-сайте, но также способный вызвать много хаоса. Одна неуместная буква может сделать много SEO проблемы У вас есть и вы будете запрещать поисковым системам доступ к важному контенту на вашем сайте.

Вы когда-нибудь слышали о термине Robots.txt и задавались вопросом, как использовать его на веб-сайте? На большинстве веб-сайтов есть собственный файл Robots.txt, но это не значит, что большинство вебмастерам Они понимают, как с этим бороться.

В этой теме мы надеемся изменить это, предоставив подробное руководство по файлу Robots.txt, а также о том, как вы можете контролировать и ограничивать доступ поисковых систем к вашему сайту.

К концу этой статьи вы сможете ответить на такие вопросы, как:

- Что такое файл Robots.txt?

- Как файл Robots.txt помогает моему сайту?

- Как мне добавить Robots.txt в WordPress?

- Какие типы правил я могу добавить в Robots.txt?

- Как я могу протестировать файл robots.txt?

- Как большие сайты WordPress реализуют файл Robots.txt?

Есть много деталей, которые нужно осветить, так что приступим!

Что такое файл Robots.txt?

Прежде чем мы поговорим о файле Robots.txt как таковом, важно определить, что означают роботы в данном случае. Роботы - это любыеКраулерыкоторый посещает веб-сайты. Самый распространенный пример - поисковые роботы. Этот механизм перемещается по сети, чтобы помочь поисковым системам, таким как Google, индексировать и ранжировать миллиарды страниц в Интернете.

Итак, боты в целом полезны для Интернета ... или, по крайней мере, необходимы. Но это не обязательно означает, что вы или любой другой веб-мастер хотите, чтобы эти боты работали без каких-либо ограничений.

Желание контролировать взаимодействие поисковых роботов с веб-сайтами привело к созданию стандарта исключения ботов в середине XNUMX-х годов. Файл Robots.txt - это практичный выбор для этого стандарта - он позволяет вам контролировать, как участвующие боты взаимодействуют с вашим сайтом. Вы можете полностью заблокировать поискового робота, ограничить его доступ к определенным областям вашего сайта и т. Д.

Тем не менее, «участие» очень важно. Файл robots.txt не может заставить бота следовать его указаниям. А вредоносные боты могут игнорировать файл robots.txt. Кроме того, авторитетные организации игнорируют некоторые команды, которые они могут добавить в файл Robots.txt. Например, Google проигнорирует любые правила, которые вы добавляете в свой файл robots.txt о Количество раз посещается ползучими ботами. Если вы сталкиваетесь с множеством проблем с ботами, решение безопасности может быть похоже на Cloudflare или же Sucuri полезный.

Зачем вам нужен файл robots.txt?

Для большинства Вебмастерам Преимущества хорошо организованного файла robots.txt делятся на две категории:

- Оптимизируйте ресурсы сканирования для поисковых систем, сказав им не тратить время на страницы, которые вы не хотите индексировать. Это помогает гарантировать, что поисковые системы сосредоточатся на сканировании страниц, которые вас больше всего интересуют.

- Оптимизируйте использование вашего сервера, блокируя ботов, которые тратят ресурсы.

Файл Robots.txt не предназначен для управления тем, какие страницы индексируются поисковыми системами.

Файл Robots.txt не является надежным способом контролировать, какие страницы индексируются поисковыми системами. Если ваша основная цель - предотвратить включение определенных страниц в результаты поисковой системы, правильным подходом будет использование мета-элемент NOINDEX Или другой аналогичный прямой метод.

Это связано с тем, что ваш файл Robots.txt напрямую не говорит поисковым системам не индексировать контент - он просто просит их не сканировать его. Хотя Google не будет сканировать области, отмеченные как не просканированные с вашего сайта, сам Google говорится, что Если внешний сайт ссылается на страницу, которую вы исключили с помощью файла Robots.txt, Google все равно может проиндексировать эту страницу.

Директивы robots.txt могут быть совместимы не со всеми поисковыми системами.

Инструкции в файлах robots.txt не могут принудить сканера к определенному поведению на веб-сайте, потому что именно сканер решает, следовать этим инструкциям или нет. Хотя робот Googlebot и другие известные поисковые роботы следуют правилам robots.txt, другие поисковые роботы могут этого не делать. Поэтому, если вы хотите защитить информацию от веб-сканеров, лучше использовать другие методы блокировки, такие как защита паролем личных файлов на сервере.

Как создать и отредактировать файл Robots.txt

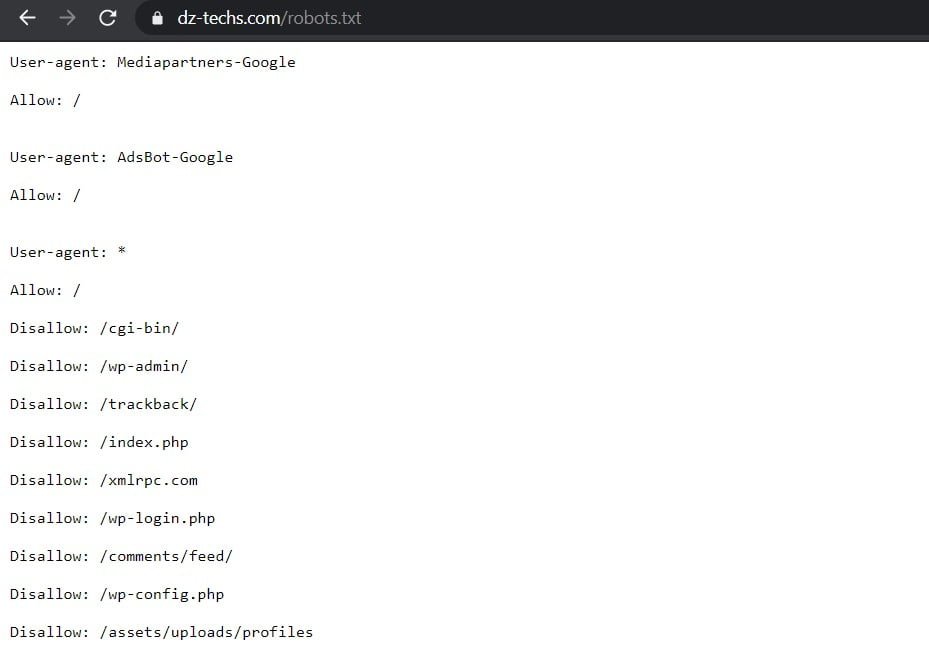

По умолчанию WordPress автоматически создает файл robots.txt по умолчанию для вашего сайта. Поэтому, даже если вы ничего не делаете, на вашем сайте уже должен быть файл robots.txt по умолчанию. Вы можете проверить, так ли это, добавив «/роботы.txtв конце вашего доменного имени. Например, отображается «https://www.dz-techs.com/robots.txtФайл robots.txt, который мы используем здесь, в Dz Techs:

Что касается файла по умолчанию, вы не можете изменить его напрямую. Если вы хотите изменить файл robots.txt, вам действительно нужно будет создать на своем сервере специальный файл, который вы можете изменять по мере необходимости. Вот три простых способа сделать это ...

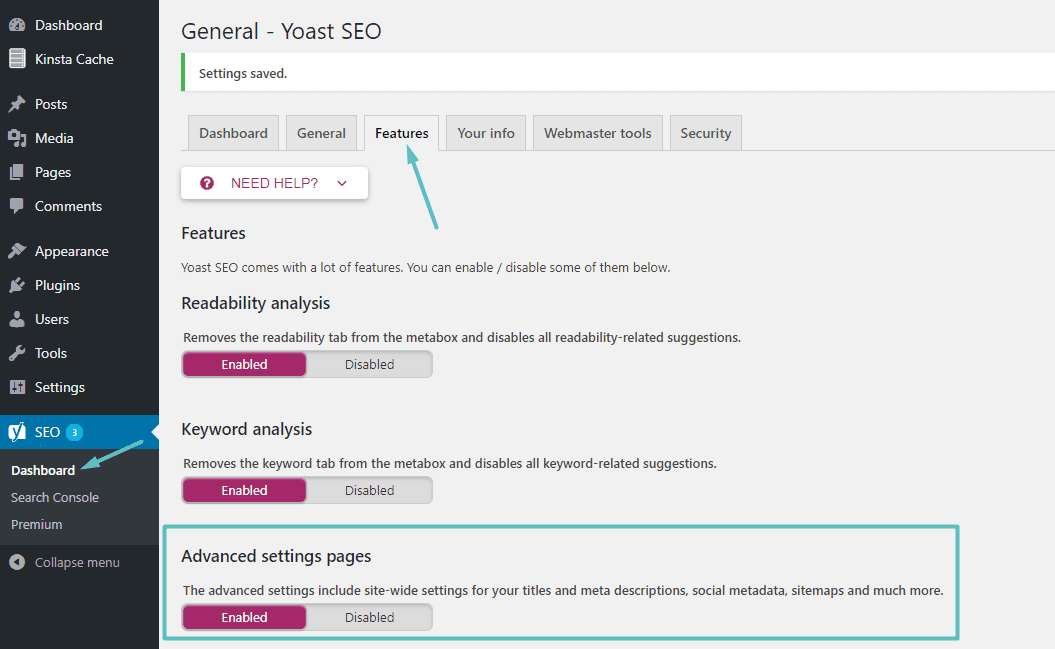

Как создать и отредактировать файл Robots.txt с помощью Yoast SEO

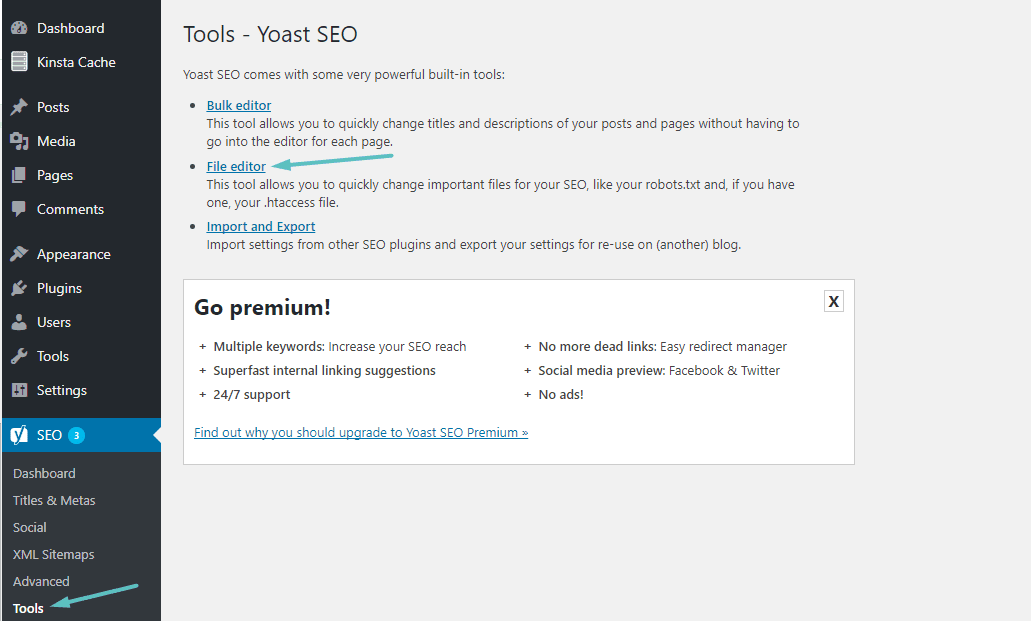

Если вы используете Знаменитое дополнение Yoast SEO, вы можете создать (и отредактировать позже) файл robots.txt прямо из интерфейса Yoast. Прежде чем вы сможете получить доступ к этой опции, вам необходимо включить Расширенные возможности Yoast SEO Перейдя в SEO → Личный кабинет → Возможности и включите ползунок рядом с Страницы расширенных настроек:

После включения вы можете перейти к SEO → Инструменты И нажав на Редактор файлов:

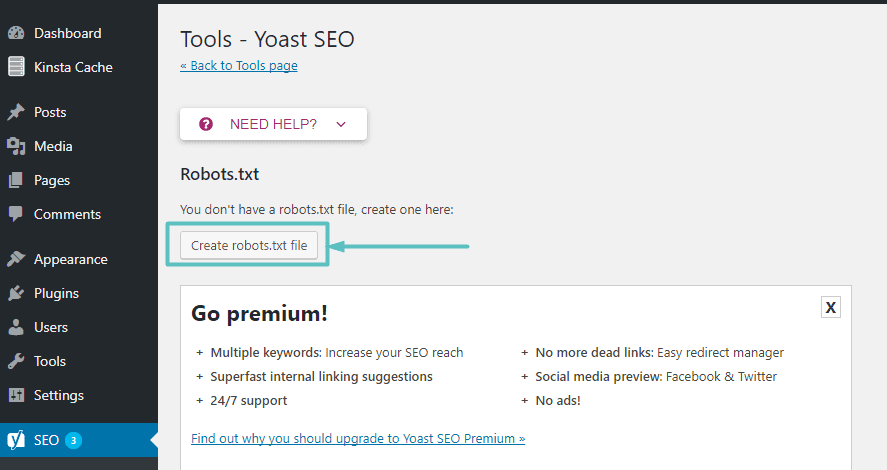

Предполагая, что на веб-сайте на самом деле нет файла Robots.txt, Yoast предложит вам вариант Создайте файл robots.txt:

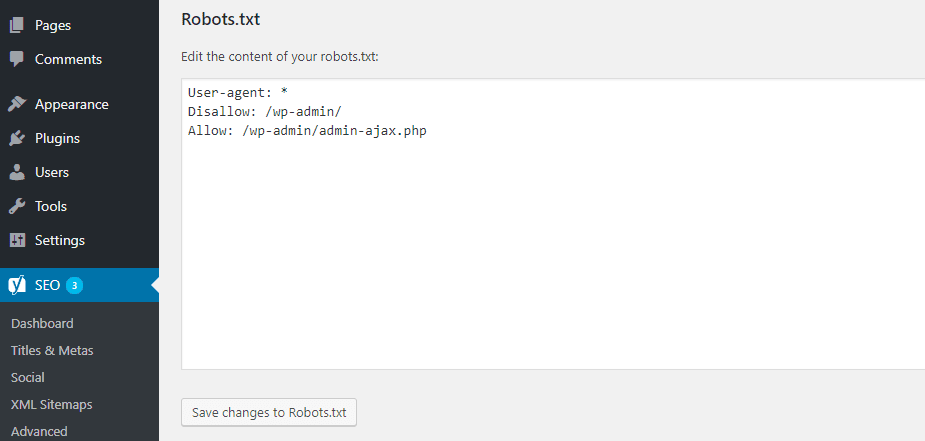

После того, как вы нажмете эту кнопку, вы сможете редактировать содержимое файла Robots.txt прямо из того же интерфейса:

По мере того, как вы будете читать дальше, мы рассмотрим типы руководящих указаний, которые вы можете добавить в свой файл robots.txt на веб-сайте.

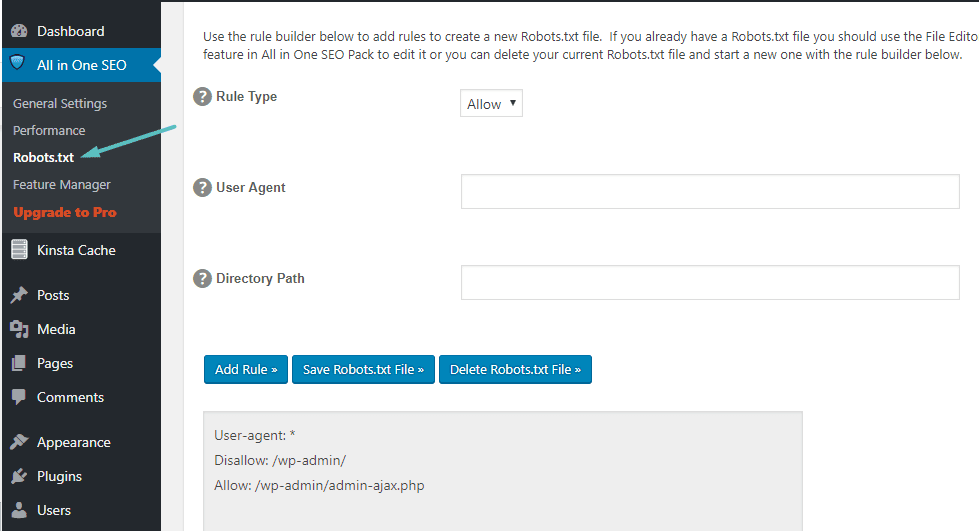

Как создать и отредактировать файл Robots.txt с помощью All In One SEO

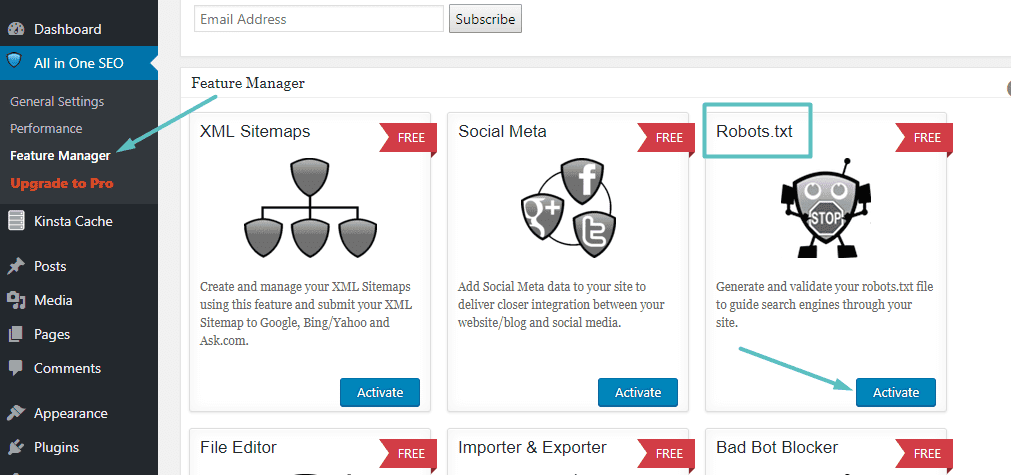

Если вы используете Другие популярные дополнения Что чем-то похоже на Yoast: Все в одном SEO обновления Вы также можете создавать и изменять файл robots.txt прямо из интерфейса расширения. Все, что вам нужно сделать, это перейти к Все в одном SEO → Менеджер функций Активируйте функцию Robots.txt:

После этого вы сможете управлять файлом Robots.txt, перейдя в Все в одном SEO → Robots.txt:

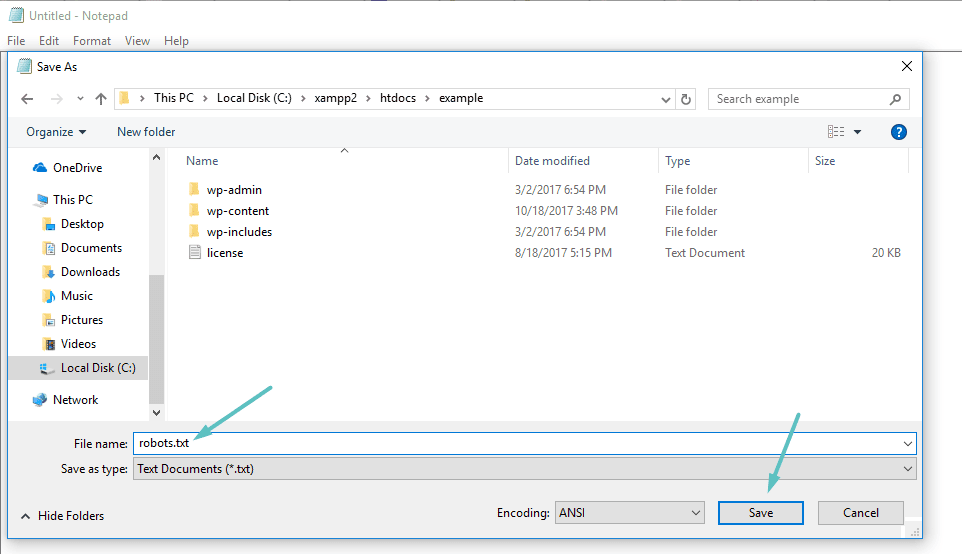

Как создать и отредактировать файл Robots.txt через FTP

Если вы не используете расширение SEO, которое предоставляет доступ к файлу robots.txt, вы все равно можете создавать файл robots.txt и управлять им через SFTP. Сначала с помощью любого текстового редактора создайте пустой файл с именем «robots.txt»:

Затем подключитесь к своему сайту через SFTP Загрузите этот файл в корневую папку вашего сайта. В дальнейшем вы можете редактировать файл robots.txt, редактируя его через SFTP или каждый раз загружая новые версии файла.

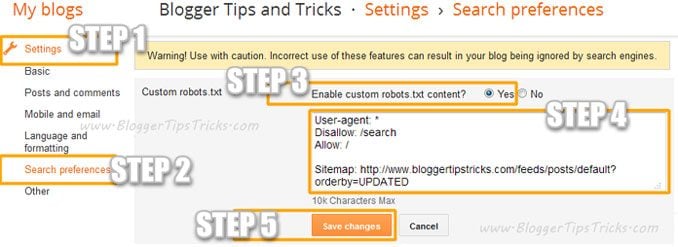

Добавьте в Blogger собственный файл Robots.Txt

Вы можете добавить собственный файл robots.txt в Blogger, выполнив следующие действия:

- Зайдите в свой блог.

- Перейти к Настройки >> Настройки поиска ›› Сканеры и индексирование ›› Пользовательский файл robots.txt ›› Редактировать ›› Да

- Теперь вставьте свой код robots.txt в это поле.

- Нажмите на кнопку Сохранение изменений.

Что отображается в файле Robots.txt?

Что ж, теперь у вас есть настоящий файл robots.txt на вашем сервере, который вы можете изменять по мере необходимости. Но что вы на самом деле делаете с этим файлом? Как вы узнали из первого раздела, файл robots.txt позволяет вам контролировать, как боты взаимодействуют с различным контентом, отображаемым на вашем сайте. Вы можете сделать это двумя основными способами:

- Агент пользователя Это позволяет настраивать таргетинг на определенных поисковых роботов. пользовательский агент Это то, что сканер использует для самоидентификации. С его помощью вы можете, например, создать правило, которое применяется к поисковому роботу Bing, но не к роботу Google.

- запрещать Это позволяет вам запретить поисковым роботам доступ к определенным областям вашего сайта.

Также есть заказ Разрешить Вы будете использовать его в особых ситуациях. По умолчанию отмечен Разрешить на всем на вашем сайте, поэтому нет необходимости использовать команду Разрешить В 99% позиций. Но это полезно, когда вы хотите запретить поисковым роботам доступ к папке и ее подпапкам, но разрешить доступ к определенной подпапке.

Вы можете добавить правила, сначала выбрав пользовательский агент, к которому должно применяться правило, а затем указать, какие правила должны применяться, используя два тега запрещать و Разрешить. Есть также некоторые другие команды, например Задержка сканирования و Карта сайта , но это либо:

- Он игнорируется большинством основных поисковых роботов или интерпретируется совершенно по-разному (в случае Задержка сканирования).

- Они стали дополнительными благодаря таким инструментам, как Google Search Console (на случай, если Карта сайта)

Давайте рассмотрим некоторые конкретные варианты использования, чтобы показать вам, как все эти команды могут использоваться вместе.

Как использовать Robots.txt для блокировки доступа ко всему сайту

Допустим, вы хотите запретить всем сканерам доступ к вашему сайту. Это маловероятно на работающем сайте, но полезно для сайта в разработке. Для этого вы добавите этот код в свой файл robots.txt:

User-agent: * Disallow: /

Что происходит в этом коде?

звездочка * Рядом с Агент пользователя Средства "Все пользовательские агенты. Звездочка - это подстановочный знак, означающий, что эти команды применяются ко всем пользовательским агентам. Косая черта указывает / расположен рядом с запрещать указывает, что вы хотите запретить доступ ко всем страницам, содержащим "вашдомен.com/(Это означает все страницы вашего сайта).

Как использовать Robots.txt, чтобы предотвратить доступ одного сканера к вашему сайту

Давайте изменим ситуацию. В этом примере мы сделаем вид, что вам не нравится тот факт, что Bing сканирует ваши страницы. Вы поклонник поисковой системы Google и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы предотвратить сканирование вашего сайта только Bing, необходимо заменить звездочку * б Бингбот:

User-agent: Bingbot Disallow: /

По сути, в приведенном выше коде говорится о применении правила запрещать Только на сканерах, использующих пользовательский агент. «Бинбот». Теперь вы вряд ли захотите блокировать доступ из Bing, но этот сценарий пригодится, если конкретный поисковый робот, который вам не нужен, обращается к вашему сайту. На этом сайте есть хороший список большинства имен Пользовательские агенты известный.

Как использовать Robots.txt для блокировки доступа к определенной папке или файлу

В этом примере предположим, что вы хотите заблокировать доступ только к определенному файлу или папке (и всем подпапкам этой папки). Чтобы применить это к своему сайту, допустим, вы хотите заблокировать оба:

- Вся папка wp-admin

- wp-login.php حة страницу

Вы можете использовать следующие команды:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-login.php

Как использовать файл Robots.txt, чтобы разрешить доступ к определенному файлу в запрещенной папке

Что ж, теперь предположим, что вы хотите заблокировать всю папку, но все же хотите разрешить доступ к определенному файлу внутри этой папки. Вот где это входит Разрешить полезный. На самом деле это жизнеспособный процесс на вашем сайте. Фактически, файл robots.txt по умолчанию показан в WordPress В идеале это:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Этот код предотвращает доступ ко всей папке / Wp-админ / кроме файла /wp-admin/admin-ajax.php.

Как использовать Robots.txt, чтобы запретить ботам сканировать результаты поиска вашего сайта

Одна из модификаций вашего сайта, которую вы можете захотеть сделать, - это запретить поисковому роботу доступ к страницам результатов поиска вашего сайта. По умолчанию WordPress использует «параметр запроса».? s =Отображает результаты поиска. Итак, чтобы предотвратить доступ, все, что вам нужно сделать, это добавить следующее правило:

User-agent: * Disallow: /?s= Disallow: /search/

Это может быть эффективным способом устранения ошибок 404, если вы сталкиваетесь с их большим количеством.

Как создать разные правила для разных поисковых роботов в файле robots.txt

До сих пор все примеры обрабатывали одно правило за раз. Но что, если вы хотите применить разные правила к разным сканерам? Вам просто нужно добавить каждый набор правил под объявление агента пользователя каждого сканера. Например, если вы хотите создать одно правило, которое применяется ко всем сканерам, а другое правило, которое применяется к Bingbot Просто вы можете сделать это так:

User-agent: * Disallow: /wp-admin/ User-agent: Bingbot Disallow: /

В этом примере всем сканерам будет заблокирован доступ / Wp-администратора , но Bingbot будет заблокирован для доступа ко всему вашему сайту.

Полезные правила robots.txt

Вот несколько полезных и распространенных правил robots.txt:

| пример | Аль-Каида |

User-agent: * Disallow: / | Предотвратить сканирование всего веб-сайта. Обратите внимание, что в некоторых случаях URL-адреса веб-сайта все равно можно проиндексировать, даже если они не сканировались. Примечание. Это правило не подходит для разных поисковых роботов AdsBot, которые должны быть установлены явно. |

User-agent: * Disallow: /calendar/ Disallow: /junk/ | Предотвратите сканирование каталога и его содержимого, добавив косую черту после имени каталога. Обратите внимание, что вам не следует использовать файл robots.txt для блокировки доступа к личному контенту, и мы рекомендуем вместо этого использовать правильную аутентификацию. URL-адреса, которые были заблокированы файлом robots.txt, по-прежнему можно индексировать без сканирования, и любой может просмотреть файл robots.txt, который может раскрыть местоположение частного содержания, которое вы не хотите, чтобы другие видели. |

User-agent: Googlebot-news Allow: / User-agent: * Disallow: / | Разрешить доступ одному сканеру |

User-agent: Unnecessarybot Disallow: / User-agent: * Allow: / | Разрешить доступ всем сканерам, кроме одного |

User-agent: * Disallow: /private_file.html | Предотвратить сканирование отдельной веб-страницы, вставив страницу после косой черты |

User-agent: Googlebot-Image Disallow: /images/dogs.jpg | Заблокируйте определенное изображение из Google Фото: |

User-agent: Googlebot-Image Disallow: / | Заблокируйте все изображения на своем веб-сайте из Google Фото: |

User-agent: Googlebot Disallow: /*.gif$ | Запретить сканирование файлов определенного типа (например, .gif): |

User-agent: * Disallow: / User-agent: Mediapartners-Google Allow: / | Предотвращает сканирование всего сайта, но отображает рекламу AdSense на этих страницах и блокирует доступ для всех поисковых роботов, кроме Mediapartners-Google. Это скрывает страницы из результатов поиска, но поисковый робот Mediapartners-Google по-прежнему может анализировать страницы, чтобы определить, какие объявления показывать посетителям вашего веб-сайта. |

User-agent: Googlebot Disallow: /*.xls$ | Чтобы сопоставить URL-адреса, заканчивающиеся определенной строкой, вы можете использовать $. Например, в примере кода доступ к любым URL-адресам, заканчивающимся на .xls, блокируется: |

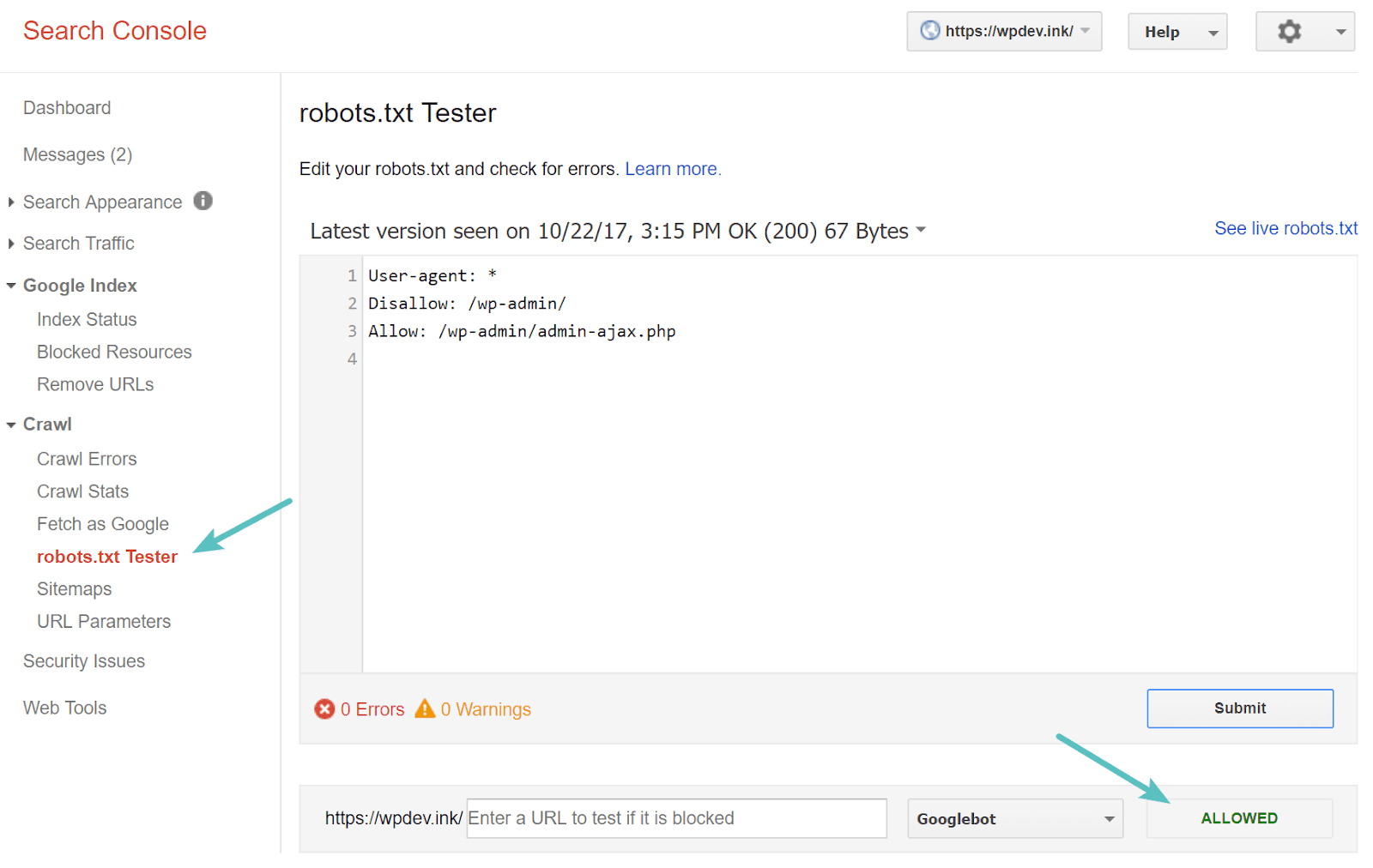

Проверьте свой файл Robots.txt

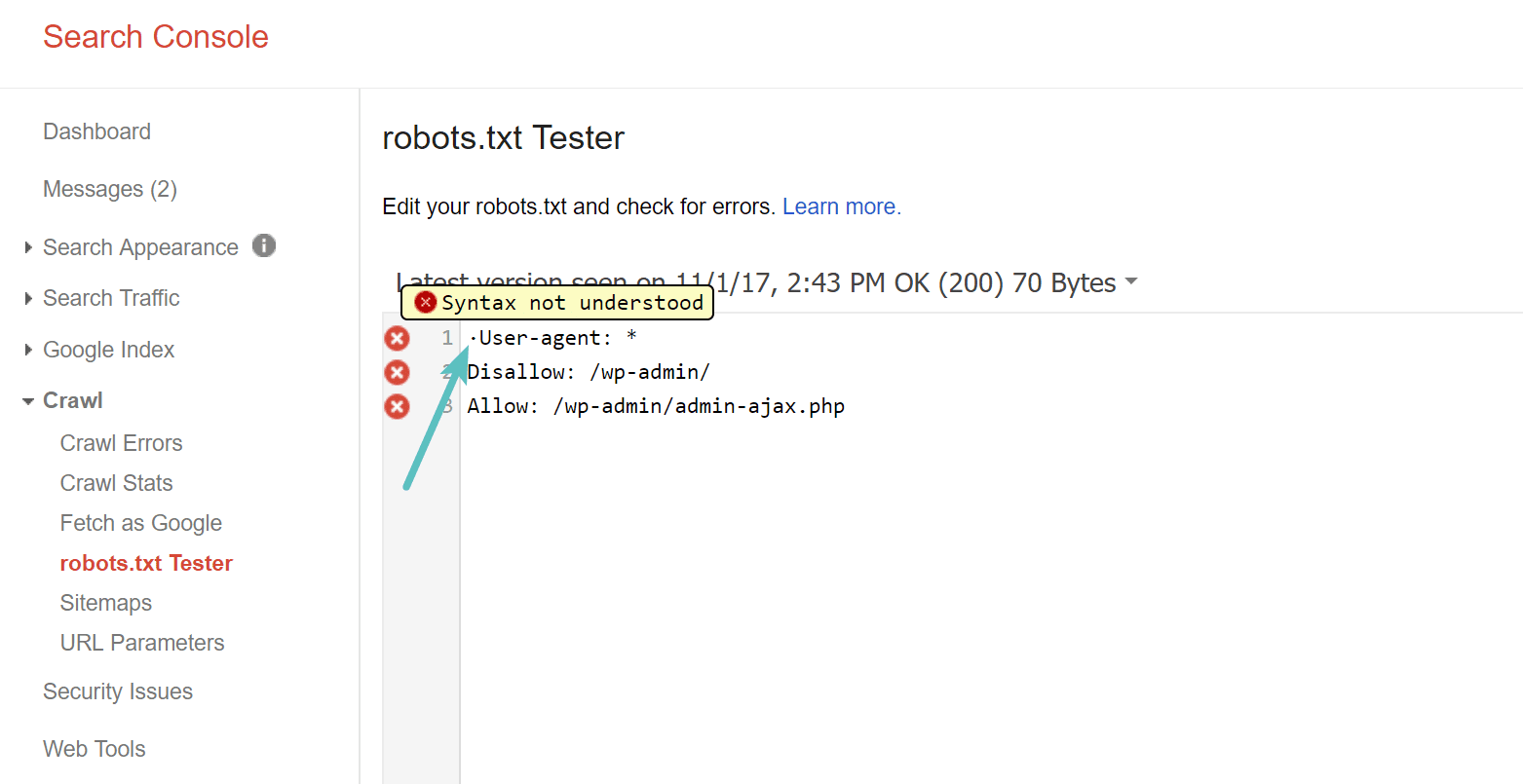

Вы можете проверить свой файл robots.txt в Google Search Console Чтобы убедиться, что он настроен правильно. Просто нажмите на свой сайт и в "ползти" , нажать на "robots.txt Тестер. Затем вы можете протестировать отправку любого URL, включая вашу домашнюю страницу. Вы должны увидеть зеленую галочку, означающую, что доступ разрешен, если все можно сканировать. Вы также можете проверить заблокированные URL-адреса, чтобы убедиться, что они уже заблокированы или не разрешены.

Остерегайтесь спецификации UTF-8

BOM обозначает знак порядка байтов и в основном является невидимым символом, который иногда добавляется к файлам старыми текстовыми редакторами и т.п. Если это происходит с файлом robots.txt, он может быть неправильно прочитан Google или другими поисковыми системами. Вот почему так важно проверить файл на наличие ошибок. Например, как показано ниже, в нашем файле был невидимый символ, что привело к неправильному пониманию синтаксиса Google. Это в основном делает недействительной первую строку файла robots.txt, что нехорошо! Гленн Гейб содержит Отличная статья О том, как UTF-8 Bom Убейте SEO.

Googlebot в основном находится в США.

Также важно не блокировать доступ робота Googlebot из США, даже если вы нацеливаетесь на территорию за пределами США. Этот бот иногда выполняет локальное сканирование, но Googlebot в основном находится в США.

Какую информацию популярные веб-сайты добавляют в свой файл robots.txt

Чтобы пояснить изложенное выше, вот как некоторые из самых популярных веб-сайтов используют свои файлы robots.txt.

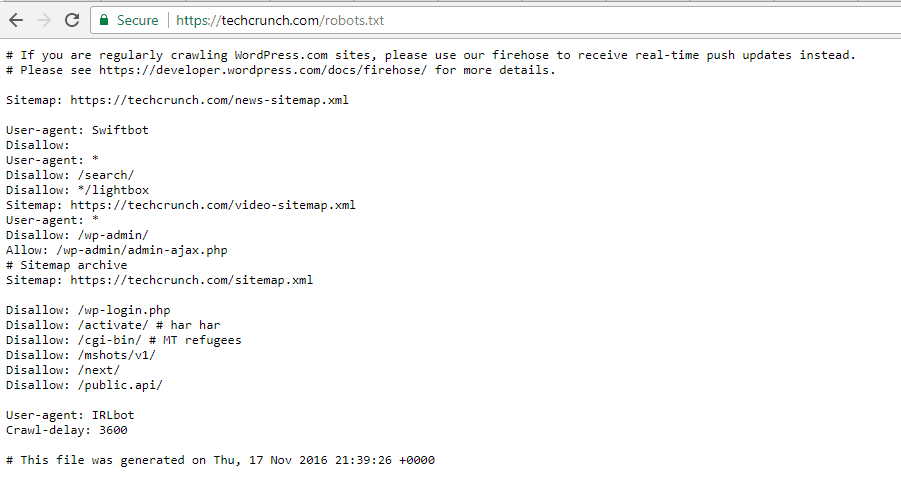

TechCrunch

Помимо ограничения доступа к ряду уникальных страниц, сканирование:

- / Wp-админ /

- /wp-login.php

Некоторые сканеры также имеют особые ограничения:

- Свифтбот

- ИРЛбот

Если вам интересно, IRLbot - сканер из исследовательского проекта. Техасский университет A&M. Это странно!

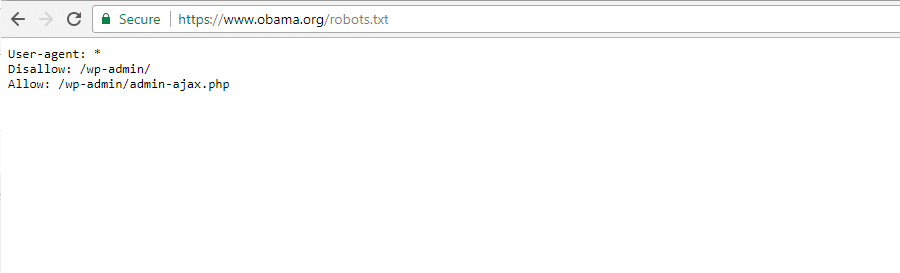

Фонд Обамы

Фонд Обамы не сделал никаких особых дополнений, решив исключительно ограничить доступ к / Wp-админ /.

Angry Birds

Angry Birds имеет те же настройки по умолчанию, что и The Obama Foundation. Ничего особенного не добавлено.

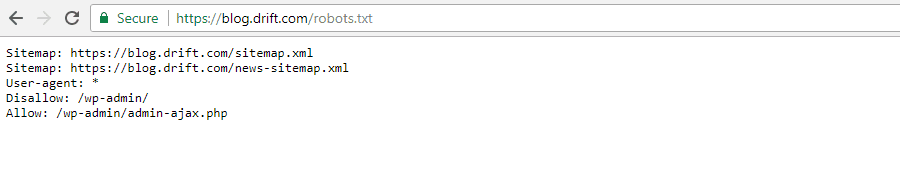

Drift

Наконец, Drift выбрал Select Files Его карты сайта в файле Robots.txt, но оставьте те же ограничения по умолчанию, что и Angry Birds.

Правильное использование Robots.txt

Завершая это руководство, мы хотели бы еще раз напомнить вам, что использование команды. запрещать Не нравится использовать знак NOINDEX. Файл robots.txt предотвращает сканирование, но не обязательно индексацию. Вы можете использовать его для добавления конкретных правил, определяющих, как взаимодействие с поисковой системой и другие поисковые роботы с вашим сайтом, но он не будет явно контролировать, индексируется ли ваш контент.

Для большинства Пользователи WordPress Обычно нет необходимости срочно изменять файл robots.txt по умолчанию. Но если у вас возникли проблемы с конкретным сканером или вы хотите изменить способ взаимодействия поисковых систем с конкретным плагином или шаблоном, который вы используете, вы можете добавить свои собственные правила.

Мы надеемся, что вам понравилось это руководство, и не забудьте оставить комментарий, если у вас есть другие вопросы об использовании файла robots.txt, на странице Веб-сайт.