Não há dúvida de que a NVIDIA continua a dominar o espaço da computação paralela com suas várias séries de placas gráficas populares. Mas com os aceleradores Instinct AI da AMD alimentando dois de seus maiores e mais recentes supercomputadores (Frontier e El Capitan) e o crescente suporte da comunidade para a plataforma ROCm de código aberto, a NVIDIA pode ter encontrado seu maior concorrente até agora.

Então, o que exatamente são os aceleradores de IA do AMD Instinct? O que o torna poderoso e como ele se compara às GPUs Tensor da NVIDIA? Verificar Qual é a diferença entre uma placa-mãe AMD e um processador Intel?

O que é AMD Instinct?

As GPUs AMD Instinct são hardware empresarial usado para computação de alto desempenho (HPC) e processamento acelerado por IA. Ao contrário das GPUs normais de nível de consumidor, as GPUs Instinct são dedicadas a lidar melhor com o aprendizado de IA, processamento de big data e outras tarefas de alto desempenho por meio de inovações de software e hardware.

A série Instinct da AMD foi usada para alimentar o primeiro supercomputador a quebrar a barreira da computação Exascale, rodando a 1.1 EFLOPs em operações de precisão dupla por segundo. Atualmente, supercomputadores contendo GPUs Instinct estão sendo usados para pesquisar terapias contra o câncer, energia sustentável e mudanças climáticas.

A computação de alto desempenho (HPC) tornou-se uma parte essencial do nosso mundo moderno, que realiza simulações e cálculos complexos necessários para pesquisa científica, engenharia, segurança e outros campos. No entanto, como a demanda por HPC aumentou, geralmente em supercomputadores e grandes centros de dados, também aumentou a preocupação com seu impacto ambiental. Nos últimos anos, tem havido um foco maior na sustentabilidade do data center, dadas as implicações para o custo total de propriedade e as preocupações climáticas.

Como as GPUs Instinct aceleram a inteligência e as tecnologias de computação de alto desempenho

Para que os servidores principais e supercomputadores mais poderosos do mundo alcançassem o nível de processamento Exascale, os aceleradores AMD Instinct precisavam ser equipados com muitas melhorias e inovações tecnológicas.

Vamos discutir algumas das tecnologias novas e atualizadas usadas nas GPUs AMD Instinct.

1. Arquitetura de Tecnologia (CDNA)

Os modernos aceleradores AMD Instinct (começando com o MI100) usaram a arquitetura CDNA da empresa.

O CDNA concentra-se principalmente em recursos como processamento paralelo, hierarquia de memória e desempenho computacional aprimorado por meio de sua tecnologia Matrix Core. Mesmo HPC e AI ou aprendizado de máquina em execução em servidores individuais podem ser suportados por CDNA, bem como supercomputadores Exascale.

A tecnologia AMD Matrix Core acelera o aprendizado de IA ao oferecer suporte a operações de precisão mista. A capacidade de calcular em diferentes resoluções permite que as GPUs Instinct calculem operações de matriz com eficiência com base no nível de precisão desejado.

Os formatos de resolução de computação mais populares incluem FP64, FP32, FP16, BF16 e INT8. FP significa Floating Point, BF significa Brain Floating Point e INT significa Integer. Quanto maior o número correspondente ao formato, maior a precisão do cálculo. A operação em 64 bits é conhecida como precisão dupla. Com 32 bits é precisão simples, com 16 bits é meia precisão e assim por diante.

Como grande parte dos modelos de aprendizado profundo de treinamento não requer muita precisão, ter a capacidade de calcular operações de matriz com metade ou até um quarto da precisão da inferência reduz muito a carga de trabalho, acelerando o aprendizado de IA. Verificar Minha IA do Snapchat ou ChatGPT: qual você deve usar?

2. Memória de alta largura de banda (HBM)

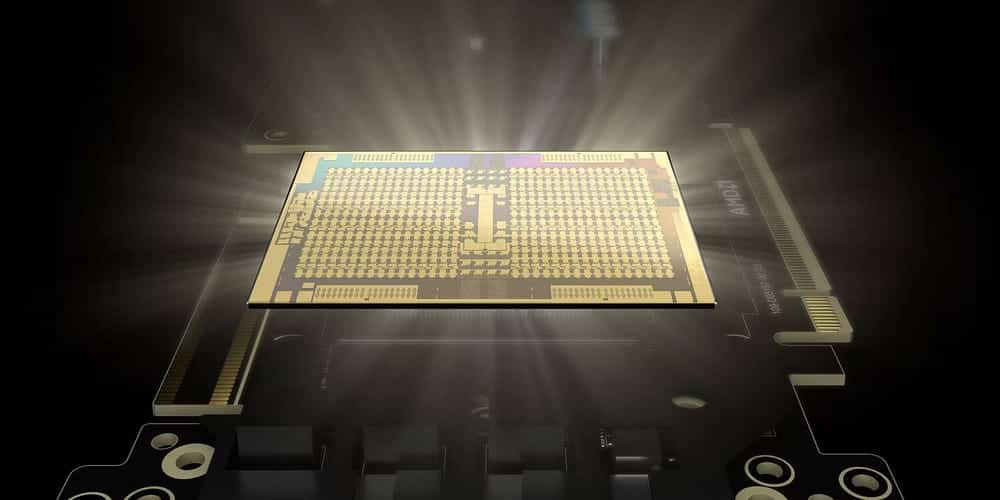

Cada acelerador AMD Instinct vem com até 880 núcleos de matriz. Com os processadores Matrix Core da AMD capazes de 383 TFLOPs de cálculos de meio minuto, a memória ultrarrápida é essencial. A mais recente oferta Instinct da AMD vem com High Bandwidth Memory (HBM) em vez da habitual RAM DDR4 ou DDR5.

Ao contrário da memória tradicional, a HBM usa o que é conhecido como arquitetura de pilha 3D. Esse tipo de arquitetura refere-se à abordagem de design em que os módulos DRAM são empilhados verticalmente uns sobre os outros. Isso permite que os modelos sejam empilhados nos eixos vertical e horizontal, daí o termo empilhamento 3D.

Com essa tecnologia de empilhamento 3D, o HBM pode ter capacidades de memória física de algumas centenas de gigabytes por módulo, enquanto o DRR5 só pode fazer até dezenas de gigabytes por módulo. Além da capacidade, o HBM também é conhecido por ter maior desempenho de throughput e melhor eficiência de energia do que a memória DDR normal.

3. Tecido Infinito

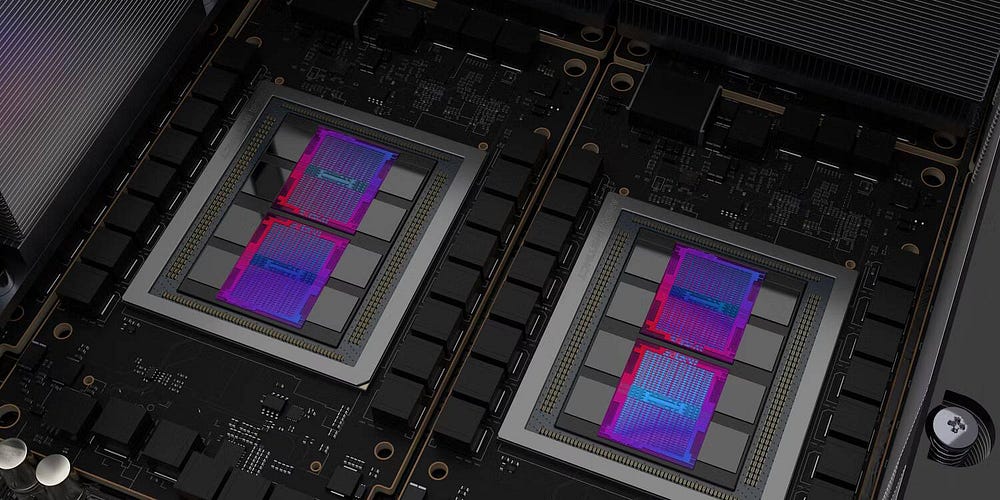

Outra inovação incorporada às GPUs Instinct é a tecnologia Infinity Fabric da AMD. O Infinity Fabric é um tipo de sistema de threading que conecta CPUs e GPUs de maneira dinâmica e inteligente. Isso permite que os componentes se comuniquem eficientemente uns com os outros.

Com o Infinity Fabric, em vez de conectar componentes a um barramento comum, os componentes agora são conectados em uma configuração semelhante a uma rede, na qual a largura de banda pode atingir várias centenas de gigabytes por segundo.

Além da interconexão semelhante à rede, o Infinity Fabric também usa sensores incorporados em cada modelo para controlar dinamicamente a frequência, as taxas de transferência de dados e outros comportamentos adaptativos, melhorando o desempenho e reduzindo a latência.

4. Plataforma de desenvolvimento ROCM

A CUDA (Unified Computing Machine Architecture) da NVIDIA é a plataforma de desenvolvimento mais amplamente usada para treinar modelos de IA. O problema com o CUDA é que ele só funciona com GPUs NVIDIA. Esse é um dos principais motivos pelos quais a NVIDIA detém a grande maioria das participações no mercado de aceleradores de HPC e IA.

Com a AMD querendo uma porção maior do mercado de HPC e IA, eles tiveram que desenvolver sua própria plataforma, ROCm (Radeon Open Compute). O ROCm é uma plataforma de software de código aberto que permite que as GPUs Instinct sejam usadas como aceleradores de IA.

Embora não necessariamente faça parte do hardware Instinct, o ROCm é fundamental quando se trata da sobrevivência da linha Instinct de GPUs. Com o ROCm, desenvolvedores e pesquisadores obtêm ferramentas ROCm, o compilador, drivers de kernel, um conjunto completo de bibliotecas e acesso a estruturas como TensorFlow e PyTorch para desenvolver com sua linguagem de programação AI favorita.

Como os aceleradores de IA do AMD Instinct se comparam aos seus equivalentes da Radeon?

A AMD oferece sua linha Instinct de GPUs corporativas e GPUs Radeon para o consumidor comum. Conforme discutido anteriormente, o processador Instinct usa a arquitetura CDNA da AMD, HBM e Infinity Fabric para interconexão. Por outro lado, os processadores Radeon usam a arquitetura RDNA da AMD, memória DDR6 e Infinity Cache.

Embora a série Radeon seja de aceleradores de IA menos capazes, eles ainda contêm um ou dois núcleos de aceleração de IA por unidade de computação. A mais recente GPU Radeon RX7900 XT possui dois núcleos de aceleração AI por unidade de computação, permitindo 103 TFLOPs de metade da resolução máxima e 52 TFLOPs de precisão de pico único.

Embora a série Instinct de GPUs seja mais adequada para LLMs e HPCs, os aceleradores Radeon AI podem ser usados para ajuste de modelo pré-treinado, inferência e tarefas com uso intensivo de gráficos.

Comparação entre AMD Instinct e NVIDIA Tensor

De acordo com uma pesquisa TrendForce A Nvida detém cerca de 80% do mercado de GPUs para servidores, enquanto a AMD detém apenas os 20% restantes. Este grande sucesso da NVIDIA se deve ao fato de ser uma empresa especializada em projetar e montar unidades de processamento gráfico. Isso permite que eles criem GPUs de melhor desempenho do que outras ofertas.

Vamos comparar o Instinct MI205X da AMD e o H100SXM5 da NVIDIA usando especificações de Site oficial da AMD e folha de dados da NVIDIA dela própria:

| tipo de GPU | FP64 (TFLOP) | FP32 (TFLOP) | FP16 (TFLOP) | INT8 (TFLOPs) |

|---|---|---|---|---|

| AMD Instinto MI250X | 30.0 | 60.0 | 1000 | 2000 |

| NVIDIA H100SXMS | 47.9 | 95.7 | 383.2 | 383 |

Como pode ser visto na tabela, o AMD MI250X tem melhor desempenho em cálculos de precisão dupla e meia precisão, enquanto o H100SXMS da NVIDIA é muito melhor em cálculos de matriz de precisão média e um quarto. Isso torna o MI250X da AMD mais adequado para HPC, enquanto o H100SXMS da NVIDIA com aprendizado e raciocínio de IA. Verificar Comparação das placas de vídeo AMD e NVIDIA no Linux: qual você deve usar?

O futuro dos processadores AMD Instinct

Embora a oferta mais recente da AMD, o MI250X, seja projetada para HPC, o próximo MI300 é mais voltado para o treinamento de IA. Este acelerador AI é declarado como um APU, combinando GPU e CPU em um único pacote. Isso permite que a GPU MI300 use a arquitetura APU de memória unificada CNDA3, onde a GPU e a CPU usarão apenas uma memória, aumentando a eficiência e reduzindo o preço.

Embora a AMD não vá competir com a NVIDIA no mercado de aceleradores de IA hoje, assim que o MI300 for lançado e o ROCm melhorar, a série Instinct da AMD pode ser boa o suficiente para arrancar uma parte significativa do mercado de aceleradores de IA da NVIDIA. Você pode ver agora Qual é a diferença entre Nvidia GTX e Nvidia RTX?