Het lijdt geen twijfel dat NVIDIA de parallelle computerruimte blijft domineren met zijn verschillende series populaire grafische kaarten. Maar met AMD's Instinct AI-versnellers die twee van zijn nieuwste en beste supercomputers aandrijven (Frontier en El Capitan) en groeiende gemeenschapsondersteuning voor het open source ROCm-platform, heeft NVIDIA misschien zijn grootste concurrent tot nu toe gevonden.

Dus wat zijn precies de AI-versnellers van AMD Instinct? Wat maakt het krachtig en hoe verhoudt het zich tot NVIDIA's Tensor GPU's? Verifiëren Wat is het verschil tussen een AMD-moederbord en een Intel-processor?

Wat is AMD-instinct?

AMD Instinct GPU's zijn bedrijfshardware die wordt gebruikt voor high-performance computing (HPC) en AI-versnelde verwerking. In tegenstelling tot reguliere GPU's op consumentenniveau, zijn Instinct GPU's toegewijd aan het beter afhandelen van AI-leren, big data-verwerking en andere hoogwaardige taken door middel van software- en hardware-innovaties.

AMD's Instinct-serie werd gebruikt om de eerste supercomputer aan te drijven die de Exascale computing-barrière doorbrak, met een snelheid van 1.1 EFLOP's in bewerkingen met dubbele precisie per seconde. Supercomputers met Instinct GPU's worden momenteel gebruikt voor onderzoek naar kankertherapieën, duurzame energie en klimaatverandering.

High-performance computing (HPC) is een essentieel onderdeel geworden van onze moderne wereld die complexe simulaties en berekeningen uitvoert die nodig zijn voor wetenschappelijk onderzoek, engineering, beveiliging en andere gebieden. Naarmate de vraag naar HPC echter is toegenomen, vaak in supercomputers en grote datacenters, neemt ook de bezorgdheid over de impact op het milieu toe. De afgelopen jaren is er meer aandacht gekomen voor de duurzaamheid van datacenters, gezien de implicaties voor de totale eigendomskosten en klimaatproblemen.

Hoe Instinct GPU's intelligentie en krachtige computertechnologieën versnellen

Om de krachtigste hoofdservers en supercomputers ter wereld verwerking op Exascale-niveau te laten bereiken, moesten AMD Instinct-versnellers worden uitgerust met veel technologische verbeteringen en innovaties.

Laten we enkele van de nieuwe en bijgewerkte technologieën bespreken die worden gebruikt in AMD Instinct GPU's.

1. Technologie-architectuur (CDNA)

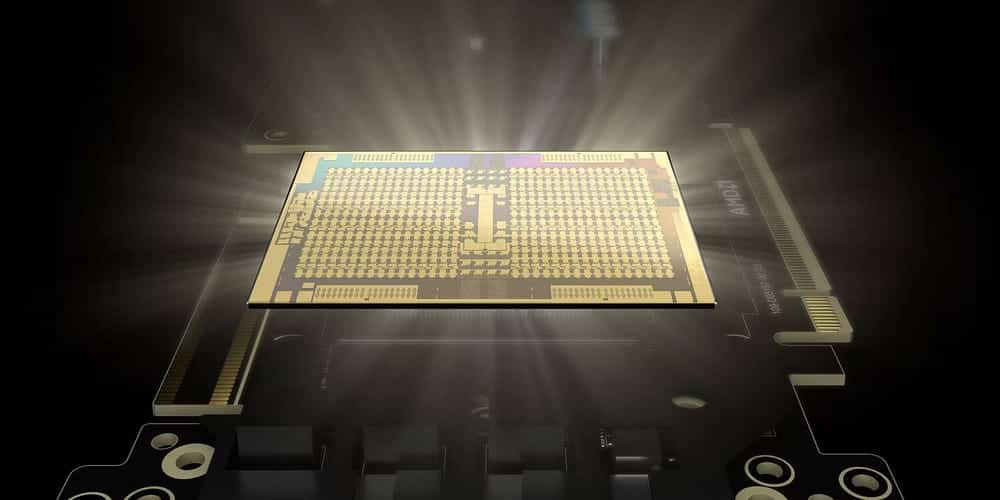

Moderne AMD Instinct-versnellers (te beginnen met de MI100) hebben de CDNA-architectuur van het bedrijf gebruikt.

CDNA richt zich voornamelijk op functies zoals parallelle verwerking, geheugenhiërarchie en verbeterde rekenprestaties via de Matrix Core-technologie. Zelfs HPC en AI of machine learning die op individuele servers draaien, kunnen worden ondersteund door CDNA, evenals Exascale-supercomputers.

AMD Matrix Core-technologie versnelt AI-leren door bewerkingen met gemengde precisie te ondersteunen. De mogelijkheid om met verschillende resoluties te berekenen, stelt Instinct GPU's in staat om matrixbewerkingen efficiënt te berekenen op basis van het gewenste precisieniveau.

De meest populaire formaten voor rekenresolutie zijn FP64, FP32, FP16, BF16 en INT8. FP staat voor Floating Point, BF staat voor Brain Floating Point en INT staat voor Integer. Hoe hoger het getal dat overeenkomt met het formaat, hoe hoger de nauwkeurigheid van de berekening. Werking op 64-bits staat bekend als dubbele precisie. Met 32-bits is het enkele precisie, met 16-bits is het halve precisie, enzovoort.

Aangezien een groot deel van het trainen van deep learning-modellen niet veel precisie vereist, vermindert de mogelijkheid om matrixbewerkingen te berekenen met de helft of zelfs een kwart van de nauwkeurigheid van inferentie de werklast aanzienlijk, waardoor AI-leren wordt versneld. Verifiëren Mijn AI van Snapchat of ChatGPT: welke moet je gebruiken?

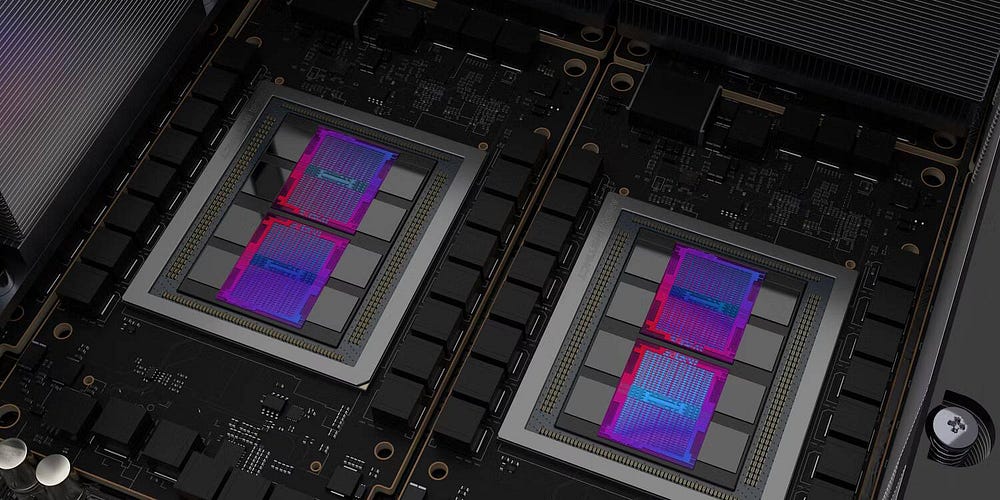

2. Geheugen met hoge bandbreedte (HBM)

Elke AMD Instinct-versneller wordt geleverd met maximaal 880 Matrix Cores. Met AMD's Matrix Core-processors die in staat zijn tot 383 TFLOP's van berekeningen van een halve minuut, is ultrasnel geheugen essentieel. AMD's nieuwste Instinct-aanbod wordt geleverd met High Bandwidth Memory (HBM) in plaats van de gebruikelijke DDR4 of DDR5 RAM.

In tegenstelling tot traditioneel geheugen gebruikt HBM een zogenaamde 3D-stackarchitectuur. Dit type architectuur verwijst naar de ontwerpbenadering waarbij DRAM-modules verticaal op elkaar worden gestapeld. Hierdoor kunnen modellen op zowel de verticale als de horizontale as worden gestapeld, vandaar de term 3D-stapeling.

Met deze 3D-stapeltechnologie kan HBM fysieke geheugencapaciteiten hebben van enkele honderden gigabytes per module, terwijl DRR5 slechts tot tientallen gigabytes per module kan. Afgezien van de capaciteit, is het ook bekend dat HBM hogere doorvoerprestaties en een betere energie-efficiëntie heeft dan normaal DDR-geheugen.

3. Infinity-stof

Een andere innovatie die in Instinct GPU's is ingebouwd, is AMD's Infinity Fabric-technologie. Infinity Fabric is een soort threading-systeem dat CPU's en GPU's op een dynamische, intelligente manier met elkaar verbindt. Hierdoor kunnen de componenten efficiënt met elkaar communiceren.

Met Infinity Fabric worden componenten nu niet meer op een gewone bus aangesloten, maar in een netwerkachtige configuratie met een bandbreedte van enkele honderden gigabytes per seconde.

Afgezien van de netwerkachtige onderlinge verbinding, gebruikt Infinity Fabric ook sensoren die in elk model zijn ingebed om de frequentie, gegevensoverdrachtsnelheden en ander adaptief gedrag dynamisch te regelen, waardoor de prestaties worden verbeterd en de latentie wordt verminderd.

4. ROCm-ontwikkelplatform

NVIDIA's CUDA (Unified Computing Machine Architecture) is het meest gebruikte ontwikkelplatform voor het trainen van AI-modellen. Het probleem met CUDA is dat het alleen werkt met NVIDIA GPU's. Dit is een van de belangrijkste redenen waarom NVIDIA de overgrote meerderheid van de marktaandelen voor HPC- en AI-versnellers heeft.

Omdat AMD een groter deel van de HPC- en AI-markt wilde, moesten ze hun eigen platform ontwikkelen, ROCm (Radeon Open Compute). ROCm is een open source softwareplatform waarmee Instinct GPU's kunnen worden gebruikt als AI-versnellers.

Hoewel het niet noodzakelijkerwijs deel uitmaakt van de Instinct-hardware, is ROCm de sleutel als het gaat om het voortbestaan van de Instinct-lijn van GPU's. Met ROCm krijgen ontwikkelaars en onderzoekers ROCm-tools, de compiler, kernelstuurprogramma's, een volledige set bibliotheken en toegang tot frameworks zoals TensorFlow en PyTorch om te ontwikkelen met hun favoriete AI-programmeertaal.

Hoe verhouden de AI-versnellers van AMD Instinct zich tot hun Radeon-tegenhangers?

AMD biedt zijn Instinct-assortiment van zakelijke GPU's en Radeon GPU's aan voor de reguliere consument. Zoals eerder besproken, gebruikt de Instinct-processor de CDNA-architectuur van AMD, HBM en Infinity Fabric voor onderlinge verbinding. Omgekeerd gebruiken Radeon-processors AMD's RDNA-architectuur, DDR6-geheugen en Infinity Cache.

Hoewel de Radeon-serie minder capabele AI-versnellers zijn, bevatten ze nog steeds een of twee AI-versnellingskernen per rekeneenheid. De nieuwste Radeon RX7900 XT GPU heeft twee AI-versnellingskernen per rekeneenheid, waardoor 103 TFLOP's met halve maximale resolutie en 52 TFLOP's met enkele piekprecisie mogelijk zijn.

Hoewel de Instinct-serie GPU's beter geschikt is voor LLM's en HPC's, kunnen Radeon AI-versnellers worden gebruikt voor vooraf getrainde modelafstemming, inferentie en grafisch-intensieve taken.

Vergelijking van AMD Instinct en NVIDIA Tensor

Volgens een onderzoek TrendForce Nvida heeft ongeveer 80% van het marktaandeel voor server-GPU's, terwijl AMD slechts ongeveer de resterende 20% heeft. Dit overweldigende succes van NVIDIA is te danken aan het feit dat het een bedrijf is dat gespecialiseerd is in het ontwerpen en assembleren van grafische verwerkingseenheden. Hierdoor kunnen ze beter presterende GPU's bouwen dan andere aanbiedingen.

Laten we de Instinct MI205X van AMD en de H100SXM5 van NVIDIA vergelijken met specificaties van AMD officiële website en NVIDIA-gegevensblad Haar eigen:

| GPU-type | FP64 (TFLOP's) | FP32 (TFLOP's) | FP16 (TFLOP's) | INT8 (TFLOP's) |

|---|---|---|---|---|

| AMD Instinct MI250X | 30.0 | 60.0 | 1000 | 2000 |

| NVIDIA H100SXMS | 47.9 | 95.7 | 383.2 | 383 |

Zoals te zien is in de tabel, presteert AMD's MI250X beter bij dubbel-precisie en half-precisie berekeningen, terwijl NVIDIA's H100SXMS veel beter is bij half- en kwart-precisie matrixberekeningen. Dit maakt AMD's MI250X meer geschikt voor HPC terwijl NVIDIA's H100SXMS met AI leren en redeneren. Verifiëren AMD vs NVIDIA grafische kaarten Vergelijking op Linux: welke moet u gebruiken?

De toekomst van AMD Instinct-processors

Hoewel het nieuwste aanbod van AMD, de MI250X, is ontworpen voor HPC, is de komende MI300 meer gericht op AI-training. Deze AI-versneller wordt aangemerkt als een APU, waarbij GPU en CPU in één pakket worden gecombineerd. Hierdoor kan de MI300 GPU de CNDA3 Unified Memory APU-architectuur gebruiken, waarbij de GPU en CPU slechts één geheugen gebruiken, wat de efficiëntie verhoogt en de prijs verlaagt.

Hoewel AMD vandaag niet zal concurreren met NVIDIA op de AI-acceleratormarkt, kan AMD's Instinct-serie, zodra MI300 wordt gelanceerd en ROCm verbetert, goed genoeg zijn om een aanzienlijk deel van de AI-acceleratormarkt van NVIDIA af te pakken. U kunt nu bekijken Wat is het verschil tussen Nvidia GTX en Nvidia RTX?