Préparer Fichier Robots.txt L'un des fichiers les plus simples d'un site Web, mais c'est aussi l'un des fichiers qui peut causer beaucoup d'encombrement. Une seule lettre en dehors de la bonne position peut faire beaucoup de Problèmes de référencement Vous avez et empêcherez les moteurs de recherche d'accéder à du contenu important sur votre site.

Avez-vous déjà entendu parler du terme Robots.txt et vous êtes-vous demandé comment l'utiliser sur le site Web? La plupart des sites Web ont un fichier Robots.txt personnalisé, mais cela ne signifie pas que la plupart Webmasters Ils comprennent comment y faire face.

Sur ce sujet, nous espérons changer cela en fournissant un guide détaillé sur Robots.txt, ainsi que la façon de contrôler et de limiter l'accès des moteurs de recherche à votre site Web.

À la fin de cet article, vous serez en mesure de répondre à des questions telles que:

- Qu'est-ce que le fichier Robots.txt?

- Comment le fichier Robots.txt aide-t-il mon site Web?

- Comment puis-je ajouter un fichier Robots.txt à WordPress?

- Quels types de règles puis-je placer dans Robots.txt?

- Comment tester mon fichier robots.txt?

- Comment les grands sites WordPress implémentent-ils Robots.txt?

Il y a tellement de détails à couvrir, alors commençons!

Qu'est-ce que le fichier Robots.txt?

Avant de parler du fichier Robots.txt lui-même, il est important de déterminer ce que signifie Robots dans ce cas. Les robots sont ce genre de "Programmes d'exploration«Visiter des sites Web. L'exemple le plus courant est celui des robots des moteurs de recherche. Ce mécanisme parcourt le Web pour aider les moteurs de recherche comme Google à indexer et à classer des milliards de pages sur Internet.

Ainsi, les bots sont, en général, une bonne chose pour Internet ... ou du moins une chose nécessaire. Mais cela ne signifie pas nécessairement que vous ou tout autre webmaster souhaitez que ces bots soient diffusés sans aucune restriction.

Le désir de contrôler la façon dont le robot d'exploration du Web interagit avec les sites Web a créé la norme d'exclusion des bots au milieu des années XNUMX. Robots.txt est le choix pratique pour cette norme - il vous permet de contrôler la façon dont les bots participants interagissent avec votre site. Vous pouvez bloquer complètement notre robot d'exploration, restreindre son accès à certaines zones de votre site, et plus encore.

La partie "partage" est cependant importante. Robots.txt ne peut pas forcer le bot à suivre ses instructions. Les robots malveillants peuvent ignorer le fichier robots.txt. En outre, les organisations réputées ignorent certaines commandes qu'elles peuvent ajouter au fichier Robots.txt. Par exemple, Google ignorera toutes les règles que vous ajoutez à votre fichier robots.txt concernant le nombre de fois Visité par les robots d'exploration. Si vous avez beaucoup de problèmes avec les bots, la solution de sécurité pourrait être comme Cloudflare ou Sucuri Utile.

Pourquoi devriez-vous vous soucier de votre fichier robots.txt?

Pour la plupart Webmasters , Les avantages d'un fichier robots.txt bien organisé se répartissent en deux catégories:

- Améliorez les ressources d'exploration des moteurs de recherche en leur disant de ne pas perdre de temps sur les pages que vous ne souhaitez pas indexer. Cela permet de garantir que les moteurs de recherche se concentrent sur l'exploration des pages qui comptent le plus pour vous.

- Améliorez l'utilisation de votre serveur en bloquant les bots qui gaspillent les ressources.

Le fichier Robots.txt n'est pas lié au contrôle sur la détermination des pages indexées par les moteurs de recherche

Robots.txt n'est pas un moyen garanti de contrôler les pages indexées par les moteurs de recherche. Si votre objectif principal est d'empêcher que des pages spécifiques soient incluses dans les résultats de votre moteur de recherche, la bonne façon est d'utiliser Composant d'identification noindex Ou une autre méthode directe similaire.

En effet, votre fichier Robots.txt ne demande pas directement aux moteurs de recherche de ne pas indexer le contenu - il leur demande simplement de ne pas l'explorer. Bien que Google n'explore pas les zones qui ont été marquées comme n'étant pas explorées depuis votre site, Google lui-même Il est dit Si un site externe établit un lien vers une page que vous excluez via votre fichier Robots.txt, Google peut continuer à indexer cette page.

Les directives du fichier robots.txt peuvent ne pas être compatibles avec tous les moteurs de recherche

Les instructions dans les fichiers robots.txt ne peuvent pas forcer un comportement spécifique sur notre site Web au robot, car le robot décide de suivre ou non ces instructions. Bien que Googlebot et d'autres robots d'indexation réputés suivent les instructions du fichier robots.txt, d'autres robots peuvent ne pas les suivre. Donc, si vous souhaitez protéger les informations des robots d'indexation Web, il est préférable d'utiliser d'autres méthodes de blocage comme la protection des fichiers privés sur le serveur avec un mot de passe.

Comment créer et modifier un fichier Robots.txt

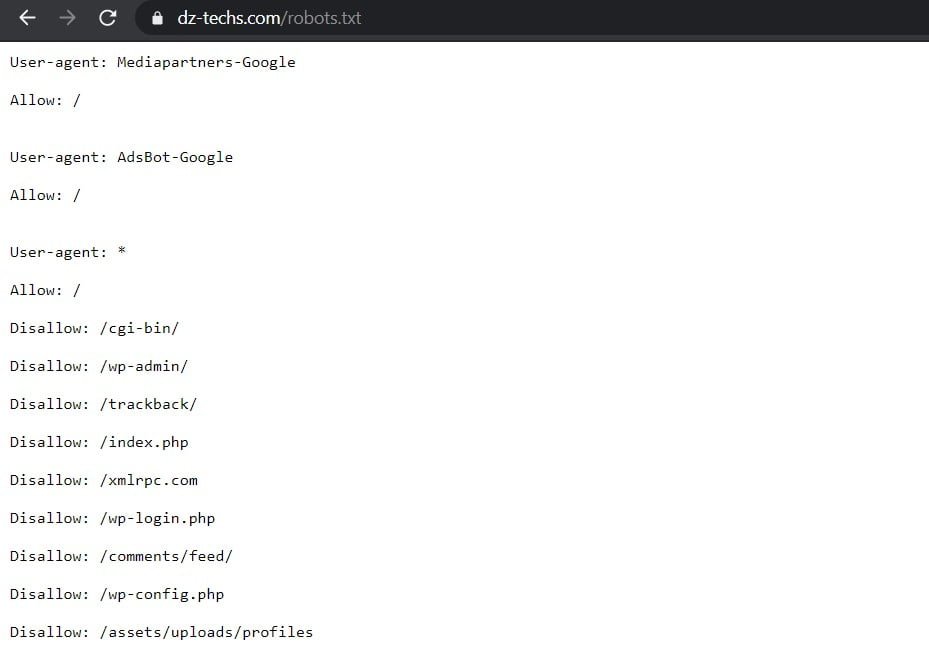

Par défaut, WordPress crée automatiquement un fichier robots.txt par défaut pour votre site. Donc, même si vous ne faites rien, votre site devrait déjà avoir le fichier robots.txt par défaut. Vous pouvez tester si c'est le cas en ajoutant '/robots.txtÀ la fin de votre nom de domaine. Par exemple, il affiche "https://www.dz-techs.com/robots.txt"Le fichier robots.txt que nous utilisons ici chez Dz Techs:

Pour le fichier par défaut, vous ne pouvez pas le modifier directement. Si vous souhaitez modifier votre fichier robots.txt, vous devrez en fait créer un fichier personnalisé sur votre serveur que vous pourrez modifier selon vos besoins. Voici trois façons simples de le faire ...

Comment créer et modifier un fichier Robots.txt à l'aide de Yoast SEO

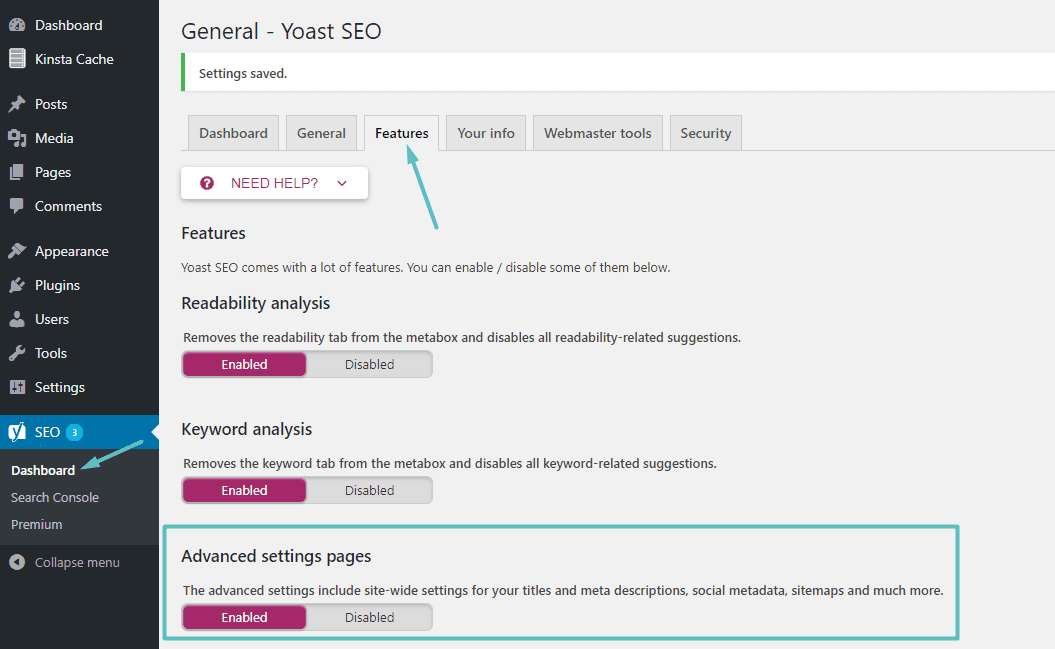

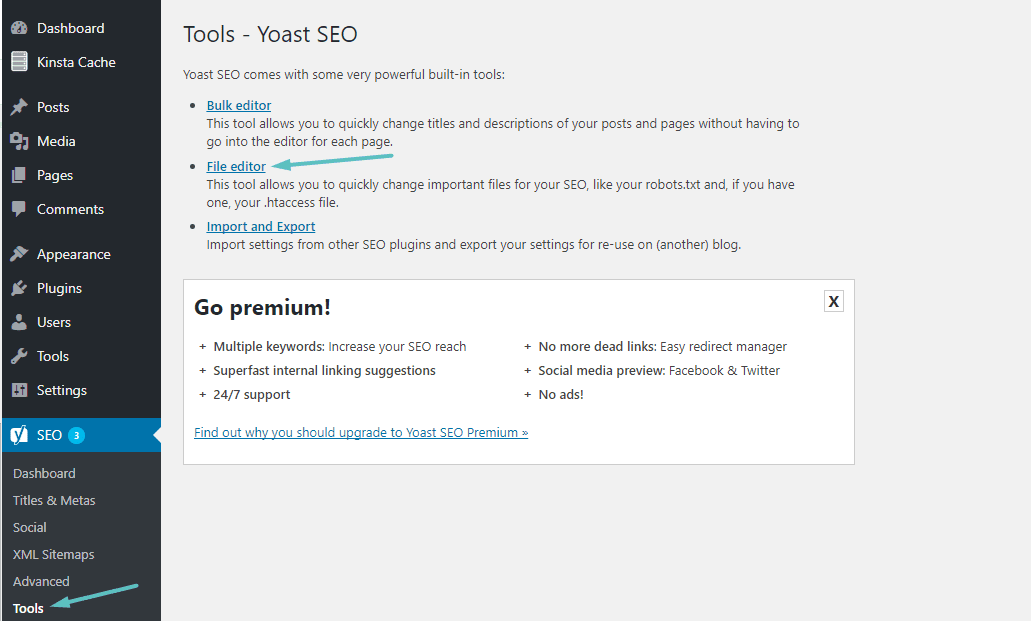

Si vous utilisez L'ajout populaire Yoast SEO, vous pouvez créer (et éditer plus tard) robots.txt directement depuis l'interface de Yoast. Avant de pouvoir accéder à cette option, vous devez activer Fonctionnalités avancées de Yoast SEO En allant à SEO → Tableau de bord → Fonctionnalités Et activez le curseur à côté de Pages de paramètres avancés:

Une fois activé, vous pouvez passer à SEO → Outils Et en cliquant sur Editeur de fichiers:

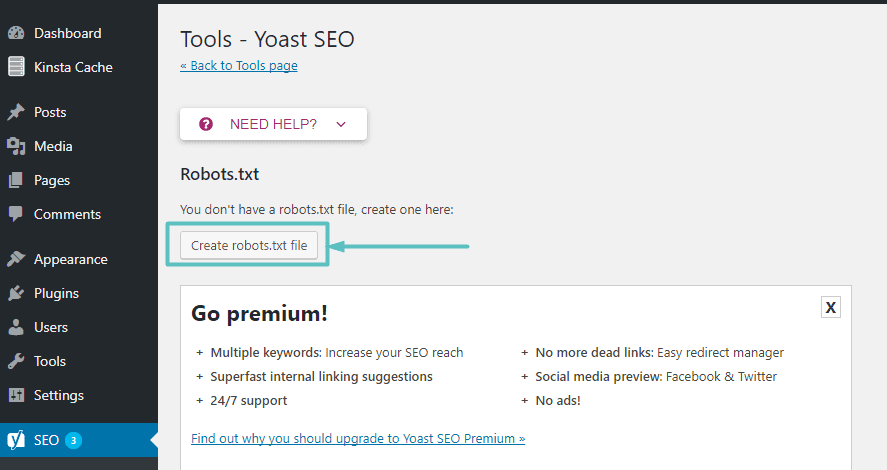

En supposant que le site Web ne contient pas réellement un fichier Robots.txt, Yoast vous donnera une option Pour créer un fichier robots.txt:

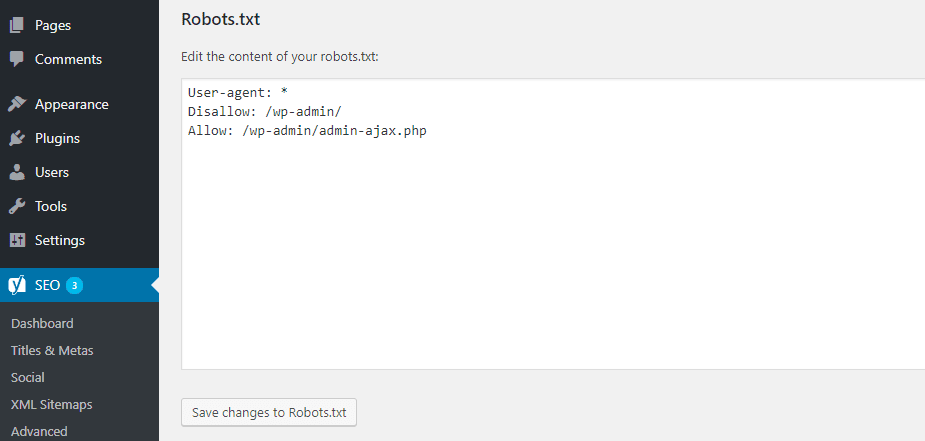

Une fois que vous aurez cliqué sur ce bouton, vous pourrez modifier le contenu du fichier Robots.txt directement à partir de la même interface:

En poursuivant votre lecture, nous examinerons de plus près les types de directives pédagogiques que vous pouvez ajouter dans votre fichier robots.txt sur le site Web.

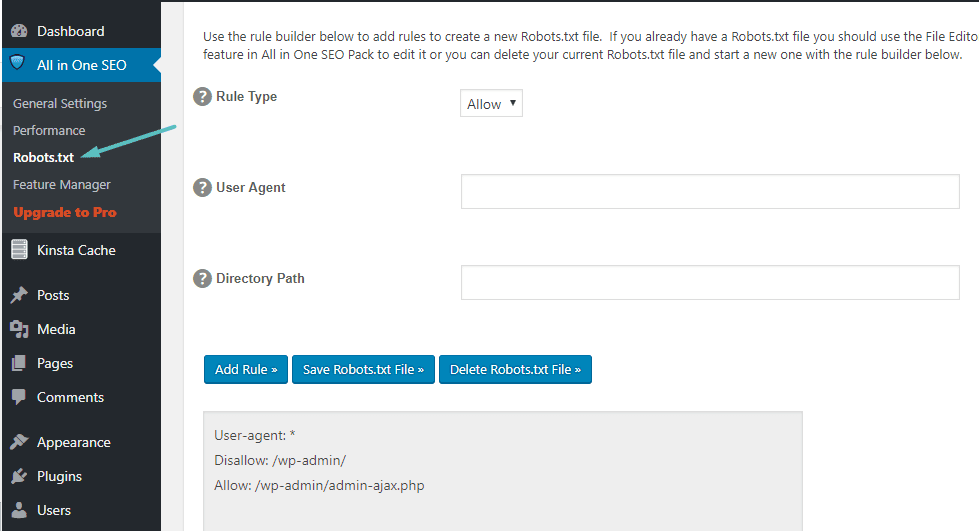

Comment créer et éditer le fichier Robots.txt en utilisant All In One SEO

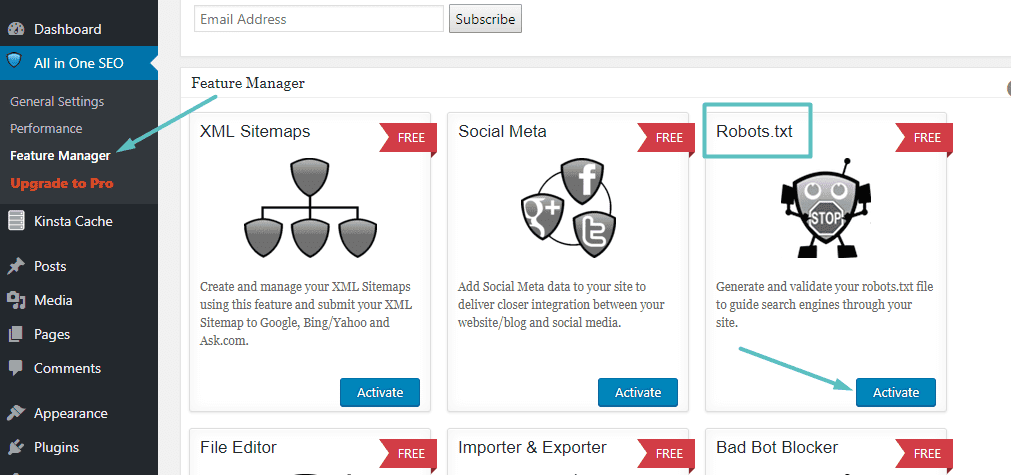

Si vous utilisez Autre bonus populaire Un peu similaire à Yoast: All in One SEO Pack de , Vous pouvez également créer et éditer robots.txt directement à partir de l'interface du plugin. Tout ce que vous avez à faire est de passer à SEO tout en un → Feature Manager Activez Robots.txt:

Ensuite, vous pourrez gérer votre fichier Robots.txt en allant sur SEO tout en un → Robots.txt:

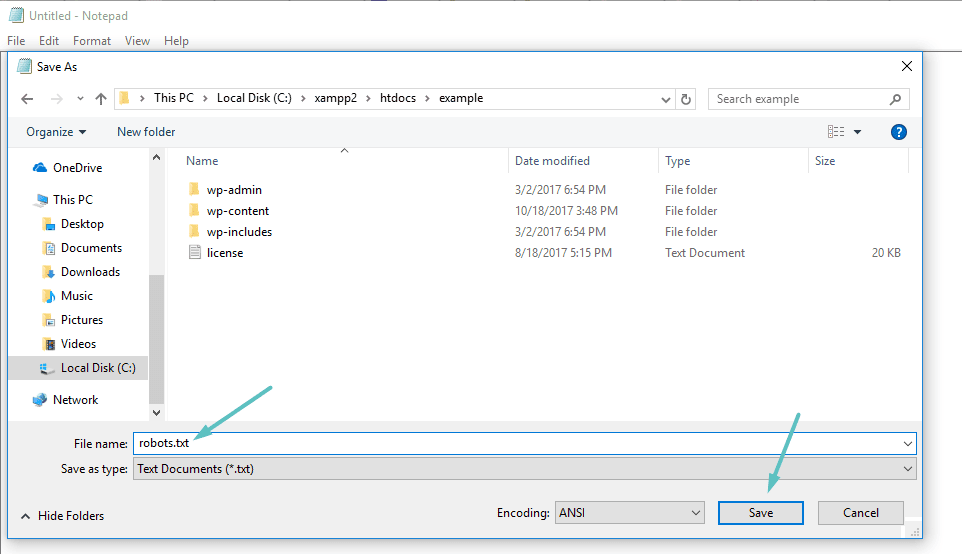

Comment créer et éditer un fichier Robots.txt via FTP

Si vous n'utilisez pas l'extension SEO qui donne accès à un fichier robots.txt, vous pouvez toujours créer et gérer un fichier robots.txt via SFTP. Tout d'abord, utilisez n'importe quel éditeur de texte pour créer un fichier vide nommé "robots.txt":

Après cela, connectez-vous à votre site via SFTP Téléchargez ce fichier dans le dossier racine de votre site Web. Vous pouvez modifier davantage votre fichier robots.txt en le modifiant via SFTP ou en téléchargeant à chaque fois de nouvelles versions du fichier.

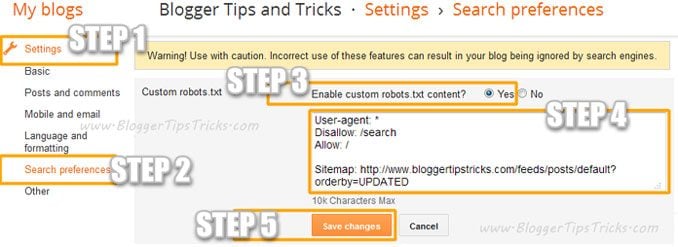

Ajouter un fichier Robots.Txt personnalisé à Blogger

Vous pouvez ajouter un fichier robots.txt personnalisé à Blogger en procédant comme suit:

- Accédez à votre blog.

- Aller à Paramètres >> Préférences de recherche ›Parcourir les robots d'exploration et indexation› Custom Robots.txt ›Modifier› Modifier ›Oui '

- Collez maintenant votre code de fichier robots.txt dans la boîte.

- Cliquez sur le bouton Enregistrer les modifications.

Que montre le fichier Robots.txt?

Eh bien, vous avez maintenant un fichier robots.txt physique sur votre serveur que vous pouvez modifier au besoin. Mais que faites-vous réellement avec ce fichier? Eh bien, comme je l'ai appris dans la première section, le fichier robots.txt vous permet de contrôler la façon dont les robots interagissent avec les différents contenus affichés sur votre site. Vous pouvez le faire en utilisant deux choses de base:

- User-agent Cela vous permet de cibler des robots spécifiques. Agent utilisateur C'est ce que les robots utilisent pour se présenter. Avec lui, vous pouvez créer, par exemple, une règle qui s'applique à notre robot d'exploration de Bing, mais pas au robot d'exploration de Google.

- Disallow - Cela vous permet de dire aux robots d'exploration de ne pas atteindre des zones spécifiques de votre site.

Il y a aussi une commande Autoriser Vous l'utiliserez dans des situations spécialisées. Par défaut, il est marqué Autoriser Sur tout sur votre site, il n'est donc pas nécessaire d'utiliser la commande Autoriser Dans 99% des postes. Mais il est utile lorsque vous ne souhaitez pas autoriser les robots d'exploration à accéder à un dossier et à ses sous-dossiers, mais pour autoriser l'accès à un sous-dossier spécifique.

Vous pouvez ajouter des règles en spécifiant l'agent utilisateur auquel la règle doit s'appliquer en premier, puis en définissant les règles à appliquer à l'aide des deux balises Disallow et Autoriser. Il existe également d'autres commandes comme Retard d'exploration et Plan du site , Mais ce sont soit:

- Ils sont ignorés par la plupart des robots principaux, ou interprétés de manières complètement différentes (au cas où Retard d'exploration).

- Il est devenu supplémentaire en raison d'outils comme Google Search Console (au cas où Plan du site)

Passons à quelques cas d'utilisation spécifiques pour vous montrer comment toutes ces commandes peuvent être utilisées ensemble.

Comment utiliser Robots.txt pour bloquer l'accès à l'ensemble de votre site Web

Supposons que vous souhaitiez empêcher tous les robots d'exploration d'accéder à votre site. Cela ne se produira probablement pas sur un site en cours d'exécution, mais est utile pour un site en cours de développement. Pour ce faire, vous allez ajouter ce code à votre fichier robots.txt:

User-agent: * Disallow: /

Que se passe-t-il avec ce symbole?

L'astérisque * a coté User-agent Veux dire "Tous les agents utilisateurs". L'astérisque est le caractère générique, ce qui signifie que ces commandes s'appliquent à tous les agents utilisateurs. La barre oblique indique / Situé à côté de Disallow Vous souhaitez interdire l'accès à toutes les pages contenant "votredomaine.com/(Cela signifie toutes les pages de votre site).

Comment utiliser Robots.txt pour empêcher un seul robot d'accéder à votre site

Changeons les choses. Dans cet exemple, nous prétendons que vous n'aimez pas le fait que Bing explore vos pages. Vous êtes un fan du moteur de recherche Google et vous ne voulez même pas que Bing regarde votre site. Pour empêcher Bing de simplement explorer votre site, l'astérisque doit être remplacé * B Bingbot :

User-agent: Bingbot Disallow: /

Essentiellement, le code ci-dessus prévoit l'application d'une règle Disallow Uniquement sur les robots qui utilisent l'agent utilisateur "Bingbot." Maintenant, il est peu probable que vous souhaitiez bloquer l'accès à Bing - mais ce scénario est utile s'il existe une analyse spécifique que vous ne souhaitez pas ou accède à votre site. Ce site contient une bonne liste de la plupart des noms Agents utilisateurs Connu.

Comment utiliser Robots.txt pour bloquer l'accès à un dossier ou un fichier spécifique

Dans cet exemple, supposons que vous souhaitez uniquement bloquer l'accès à un fichier ou un dossier spécifique (et à tous les sous-dossiers de ce dossier). Pour implémenter cela sur votre site, disons que vous souhaitez bloquer:

- L'ensemble du dossier wp-admin

- Page Wp-login.php

Vous pouvez utiliser les commandes suivantes:

User-agent: * Disallow: /wp-admin/ Disallow: /wp-login.php

Comment utiliser un fichier Robots.txt pour autoriser l'accès à un fichier spécifique dans un dossier non autorisé

Eh bien, disons maintenant que vous voulez bloquer un dossier entier, mais vous voulez toujours autoriser l'accès à un fichier spécifique dans ce dossier. C'est là que ça vient Autoriser Utile. Il s'agit en fait d'un processus applicable à votre site. En fait, le fichier robots.txt par défaut est affiché dans Outils de gestion C'est idéalement:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Cette icône bloque l'accès complet au dossier / Wp-admin / Sauf pour un fichier /wp-admin/admin-ajax.php.

Comment utiliser Robots.txt pour empêcher les robots d'explorer les résultats de recherche sur votre site

L'une des modifications que vous souhaiterez peut-être apporter à votre site consiste à empêcher le moteur de recherche d'accéder aux pages de résultats de recherche de votre site. Par défaut, WordPress utilise le «paramètre»? S =”Pour afficher les résultats de la recherche. Donc, pour empêcher l'accès, il vous suffit d'ajouter la règle suivante:

User-agent: * Disallow: /?s= Disallow: /search/

Cela peut être un moyen puissant d'arrêter les erreurs 404 si vous en rencontrez plusieurs.

Comment créer des règles différentes pour différents robots dans robots.txt

Jusqu'à présent, tous les exemples ont traité une règle à la fois. Mais que se passe-t-il si vous souhaitez appliquer des règles différentes à différents robots? Vous devez simplement ajouter chaque ensemble de règles sous l'autorisation user-agent de chaque robot. Par exemple, si vous souhaitez créer une règle qui s'applique à tous les robots et une autre règle qui s'applique à Bingbot Seulement, vous pouvez le faire comme suit:

User-agent: * Disallow: /wp-admin/ User-agent: Bingbot Disallow: /

Dans cet exemple, tous les robots d'exploration ne pourront pas accéder à / wp-admin , Mais Bingbot ne pourra pas accéder à l'intégralité de votre site Web.

Règles utiles de robots.txt

Voici quelques règles utiles et courantes de robots.txt:

| Exemple | Règle |

User-agent: * Disallow: / | Bloquer l'exploration de l'ensemble du site Web. Notez que dans certains cas, les URL du site Web peuvent toujours être indexées même si elles ne sont pas explorées. Remarque: Cette règle ne correspond pas à différents robots d'exploration AdsBot, qui doivent être définis explicitement. |

User-agent: * Disallow: /calendar/ Disallow: /junk/ | Empêchez l'analyse d'un répertoire et de son contenu en ajoutant une barre oblique après le nom du répertoire. Notez que vous ne devez pas utiliser robots.txt pour bloquer l'accès au contenu privé et vous conseiller d'utiliser à la place l'authentification appropriée. Les URL bloquées par robots.txt peuvent continuer à être indexées sans être explorées et tout le monde peut afficher le fichier robots.txt qui peut révéler le site de contenu privé que vous souhaitez uniquement voir. |

User-agent: Googlebot-news Allow: / User-agent: * Disallow: / | Autoriser une arrivée effrayante |

User-agent: Unnecessarybot Disallow: / User-agent: * Allow: / | Autoriser tous les robots d'exploration à accéder à une seule analyse |

User-agent: * Disallow: /private_file.html | Empêcher l'exploration d'une page Web en insérant la page après la barre oblique |

User-agent: Googlebot-Image Disallow: /images/dogs.jpg | Bloquer une photo spécifique de Google Images: |

User-agent: Googlebot-Image Disallow: / | Bloquer toutes les images de votre site Web à partir de Google Photos: |

User-agent: Googlebot Disallow: /*.gif$ | Empêcher l'analyse de fichiers d'un certain type (tel que .gif): |

User-agent: * Disallow: / User-agent: Mediapartners-Google Allow: / | Exploration bloquée de l'ensemble du site, mais avec des annonces AdSense diffusées sur ces pages, bloquant l'accès à tous les robots d'indexation Web non Mediapartners-Google. Cela masque les pages des résultats de recherche, mais le robot d'exploration Web Mediapartners-Google peut toujours analyser les pages pour déterminer les annonces à diffuser aux visiteurs de votre site Web. |

User-agent: Googlebot Disallow: /*.xls$ | Pour faire correspondre les URL se terminant par une série spécifique, vous pouvez utiliser $. Par exemple, le modèle de code bloque l'accès à toutes les URL se terminant par .xls: |

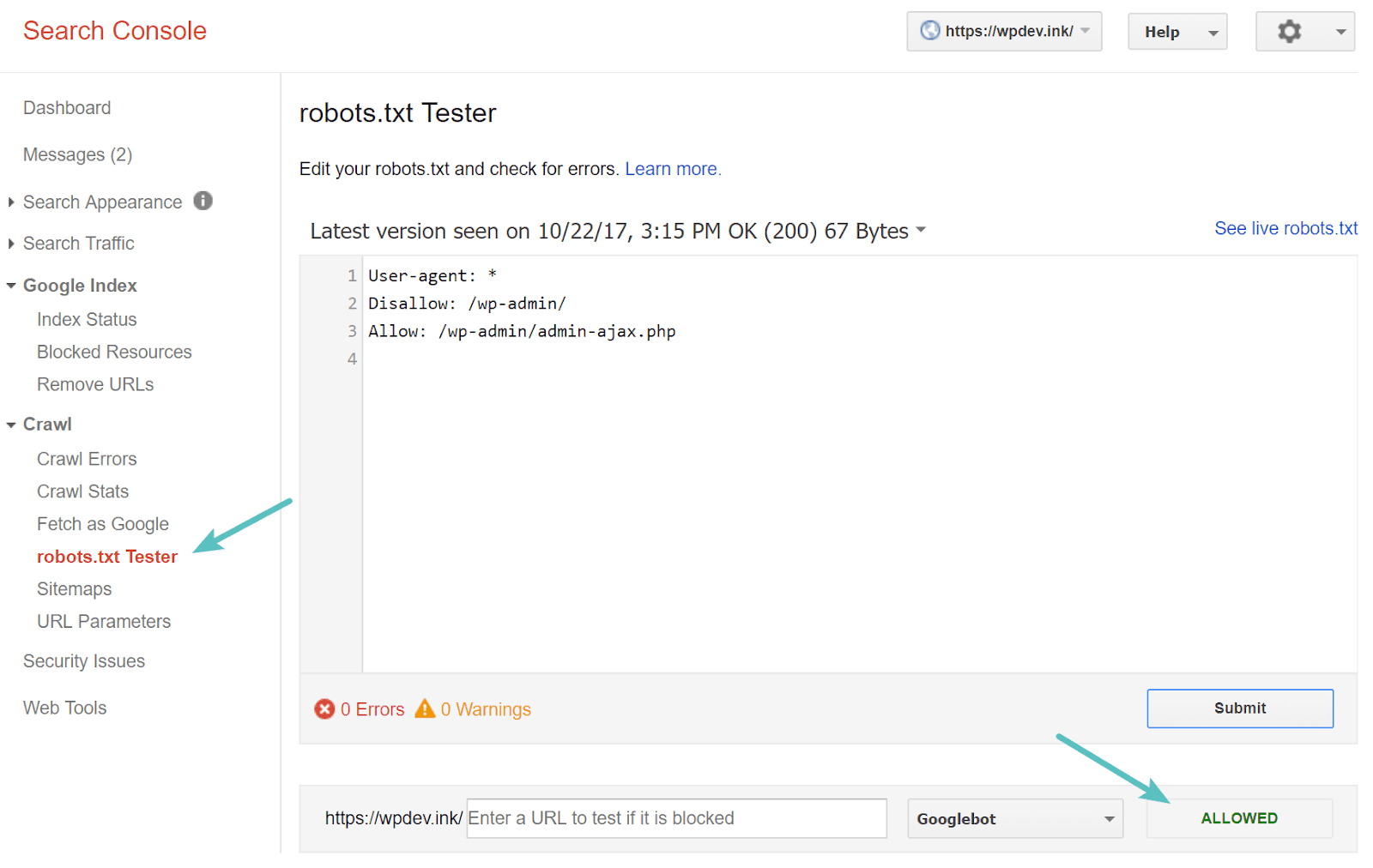

Testez votre fichier Robots.txt

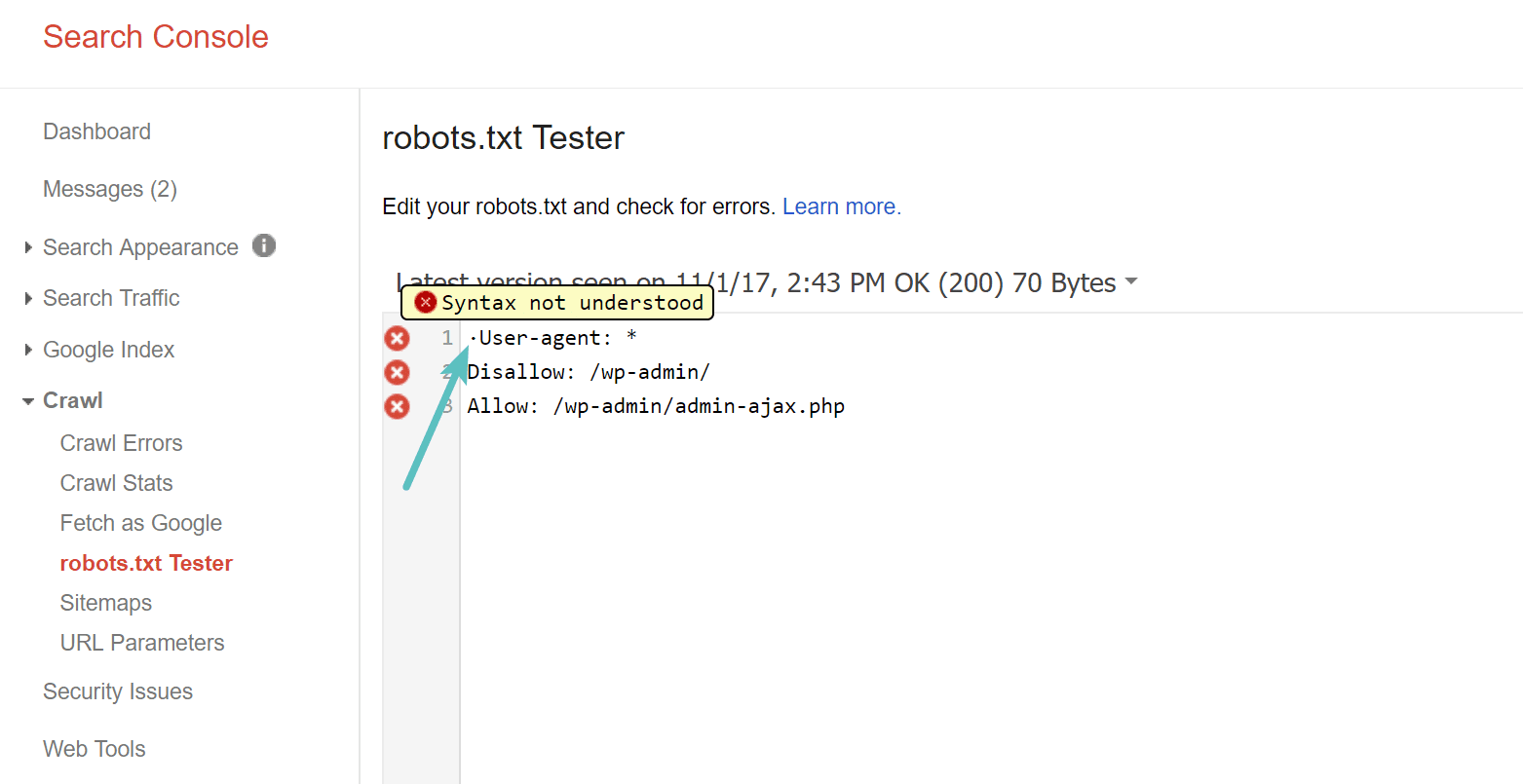

Vous pouvez tester votre fichier robots.txt dans Google Search Console Pour vous assurer qu'il est correctement configuré. Cliquez simplement sur votre site, et sous "Crawl" , Cliquez “Testeur robots.txt". Vous pouvez ensuite tester la soumission de n'importe quelle URL, y compris votre page d'accueil. Vous devriez voir un panneau vert indiquant que l'accès est autorisé si tout est explorable. Vous pouvez également tester les URL que vous avez bloquées pour vous assurer qu'elles sont réellement bloquées ou non autorisées.

Méfiez-vous de la nomenclature UTF-8

BOM signifie la marque d'ordre des octets et est essentiellement un caractère invisible parfois ajouté aux fichiers par d'anciens éditeurs de texte et similaires. Si cela arrive à robots.txt, Google ou d'autres moteurs de recherche peuvent ne pas le lire correctement. C'est pourquoi il est si important de rechercher des erreurs dans votre fichier. Par exemple, comme indiqué ci-dessous, notre fichier contient un caractère invisible qui a entraîné un manque de compréhension de la syntaxe par Google. Cela annule complètement la première ligne du fichier robots.txt, et ce n'est pas bon! Glenn Gabe contient Excellent article Qu'en est-il de l'UTF-8 Bom? Tuez votre seo.

Googlebot est principalement situé aux États-Unis

Il est également important de ne pas bloquer Googlebot des États-Unis, même si vous ciblez une zone locale en dehors des États-Unis. Ce bot rampe parfois localement, mais Googlebot se trouve principalement aux États-Unis.

Quelles informations les sites Web populaires ajoutent-ils à robots.txt

Pour fournir un contexte aux points ci-dessus, voici comment certains des sites Web les plus populaires utilisent leurs fichiers robots.txt.

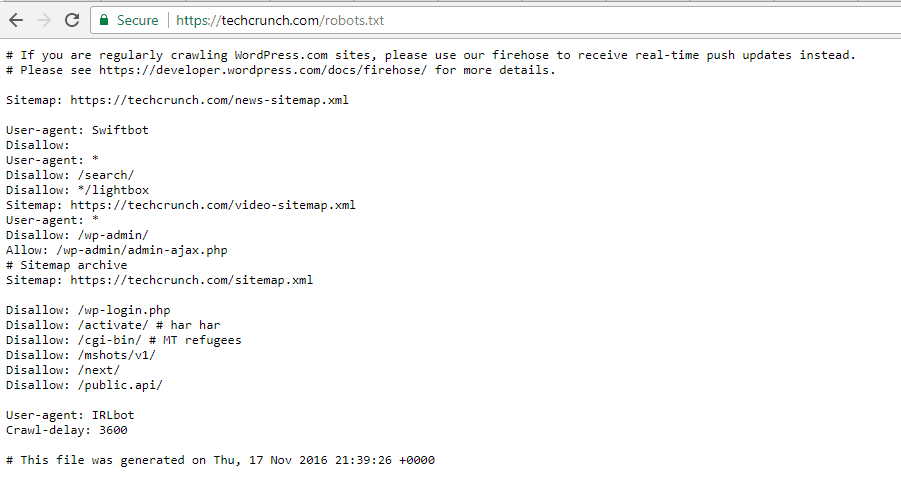

TechCrunch

En plus de restreindre l'accès à un certain nombre de pages uniques, il n'est notamment pas permis d'explorer:

- / Wp-admin /

- /wp-login.php

Des restrictions spéciales sont également imposées à certains robots:

- Robot rapide

- IRLbot

Si vous êtes intéressé, IRLbot est un robot d'exploration d'un projet de recherche Université Texas A&M. C'est étrange!

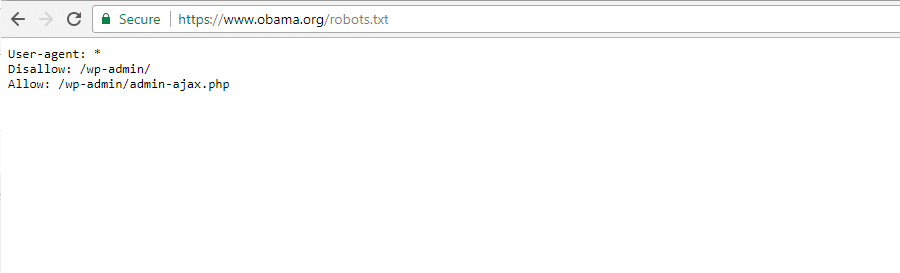

La Fondation Obama

La Fondation Obama n'a fait aucun ajout privé, choisissant de limiter exclusivement l'accès à / Wp-admin /.

Angry Birds

Angry Birds a le même paramètre par défaut que la Fondation Obama. Rien de spécial n'a été ajouté.

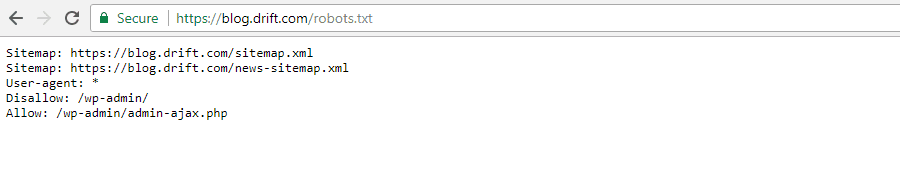

Drift

Enfin, Drift a choisi de sélectionner les fichiers Ses cartes de localisation Dans le fichier Robots.txt, mais à part cela, il a laissé les mêmes restrictions par défaut que Angry Birds.

Utilisez Robots.txt de la bonne manière

À la fin de ce guide, nous vous rappelons une fois de plus que pour utiliser une commande Disallow Pas comme utiliser une balise noindex. Robots.txt empêche l'exploration, mais pas nécessairement l'indexation. Vous pouvez l'utiliser pour ajouter des règles spécifiques pour façonner la façon dont L'interaction des moteurs de recherche Et d'autres robots d'exploration avec votre site, mais il ne contrôlera pas explicitement si votre contenu est indexable ou non.

Pour la plupart Utilisateurs WordPress Ordinaire, il n'est pas urgent de modifier le fichier robots.txt par défaut. Cependant, si vous rencontrez des problèmes avec un robot spécifique ou si vous souhaitez modifier la façon dont les moteurs de recherche interagissent avec un plug-in ou un modèle spécifique que vous utilisez, vous souhaiterez peut-être ajouter vos propres règles.

Nous espérons que vous avez apprécié ce guide et assurez-vous de laisser un commentaire si vous avez d'autres questions sur l'utilisation de votre fichier robots.txt à l'adresse Site web.